上一篇

GTX860M能否胜任深度学习任务?实测性能揭秘!

- 行业动态

- 2025-04-27

- 4

GTX 860M是NVIDIA的中端移动显卡,基于Maxwell架构,具备2GB GDDR5显存,其有限的计算能力和显存容量使其仅适合入门级深度学习实验或轻量级模型训练,处理复杂任务时易显存不足且效率较低,支持CUDA加速,可运行TensorFlow/PyTorch基础框架,但需调低批次规模或模型复杂度,建议作为学习过渡硬件,长期应用需升级更高性能显卡。

GTX 860M能否用于深度学习?全面解析与实战建议

对于许多刚接触深度学习且预算有限的学习者或开发者来说,手头的老显卡(如NVIDIA GTX 860M)能否胜任基础任务是一个常见问题,本文将从硬件性能、框架适配、优化方案及替代建议等多个角度,深入探讨这一问题。

GTX 860M的硬件性能分析

GTX 860M是NVIDIA于2014年推出的移动端显卡,基于Maxwell架构,主要参数如下:

- CUDA核心数:640个

- 显存容量:2GB/4GB GDDR5

- 显存带宽:80GB/s

- 计算能力(Compute Capability):5.0

- FP32单精度性能:约1.3 TFLOPS

关键限制:

- 显存瓶颈:2GB/4GB显存难以加载大型模型(如ResNet-50需约1.5GB显存),训练时易触发OOM(内存溢出)。

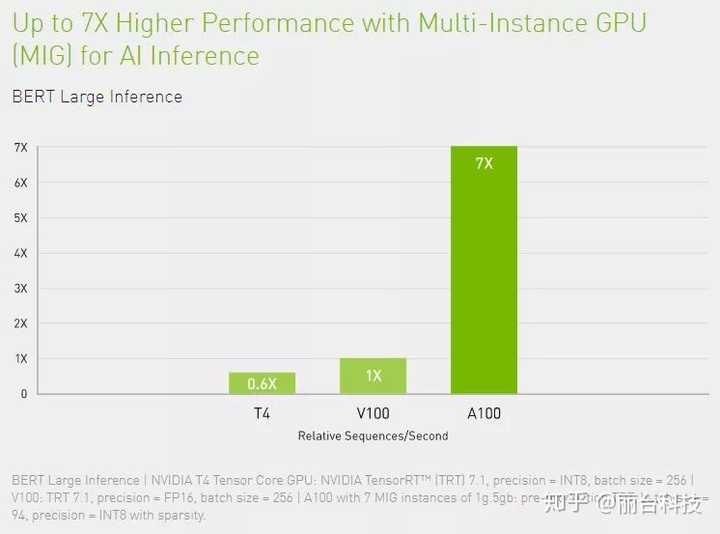

- 计算能力落后:Maxwell架构不支持现代深度学习核心特性(如混合精度训练、Tensor Core加速)。

- 兼容性问题:仅支持CUDA 5.0~6.0,新版深度学习框架(如PyTorch 2.0+、TensorFlow 2.12+)不再适配。

GTX 860M的深度学习可行性

适用场景

- 小型模型训练/推理:MNIST手写识别、简单CNN分类任务。

- 教学与代码验证:学习框架语法、调试基础代码。

- 轻量级任务:传统机器学习(Scikit-learn)或浅层神经网络。

不适用场景

- 大模型训练:BERT、Transformer等参数过亿的模型。

- 复杂任务:目标检测(YOLO)、语义分割(U-Net)等需高显存场景。

- 实时推理:高分辨率图像/视频处理任务。

实战优化方案

若坚持使用GTX 860M,可通过以下策略提升效率:

软件环境适配

CUDA与框架版本:

- 安装CUDA 6.0 + cuDNN v3,匹配旧版框架(如TensorFlow 1.14、PyTorch 1.4)。

- 推荐使用Keras 2.3或更早版本简化操作。

显存优化:

- 启用混合精度(需手动实现,官方API不支持)。

- 减小批量大小(Batch Size),梯度累积(Gradient Accumulation)。

- 使用内存交换(部分数据移至CPU处理)。

模型与数据优化

- 模型轻量化:

- 替换全连接层为全局平均池化。

- 采用MobileNet、SqueezeNet等轻量架构。

- 数据压缩:

- 降低输入分辨率(如224×224→112×112)。

- 使用灰度图像替代RGB。

替代方案

- 云端计算:

按需租用AWS、Google Colab(免费GPU资源)或AutoDL(性价比高)。

- 本地协作:

使用GTX 860M完成预处理、后处理,训练任务转至云端。

长期学习建议

- 硬件升级:

- 预算有限可选NVIDIA RTX 3060(12GB显存,支持CUDA 8.6)。

- 优先选择支持Tensor Core的显卡(如RTX 40系)。

- 框架学习:

从PyTorch Lightning或FastAI入手,简化底层代码。

- 社区资源:

Kaggle、OpenInModel等平台提供免费GPU资源与教程。

GTX 860M可作为深度学习入门“试金石”,但受限于显存与架构,仅适合验证小型项目,长期投入需结合云端资源或升级硬件,建议开发者优先掌握算法逻辑与框架使用,再逐步优化硬件配置。

参考资料

- NVIDIA官方文档:Maxwell架构技术白皮书

- TensorFlow旧版本支持列表(GitHub官方仓库)

- PyTorch社区论坛:老旧显卡适配讨论帖

- Kaggle Learn:免费GPU使用指南