上一篇

分布式文件存储框架

- 行业动态

- 2025-05-08

- 4

分布式文件存储框架通过多节点协同实现数据分片、冗余存储,保障高可用与

分布式文件存储框架详解

分布式文件存储的核心概念

分布式文件存储是一种通过多台服务器协同工作,将文件数据分散存储在多个节点上的技术架构,其核心目标是解决传统集中式存储的单点故障、容量瓶颈和性能限制问题,同时提供高可用性、可扩展性和数据持久性,以下是分布式文件存储的关键特性:

| 特性 | 描述 |

|---|---|

| 数据分片 | 将大文件拆分为多个块(Block)或切片(Shard),分散存储在不同节点 |

| 冗余备份 | 通过副本(Replication)或纠删码(Erasure Coding)实现数据容错 |

| 元数据管理 | 独立管理文件目录结构、权限、位置映射等信息 |

| 可扩展性 | 支持动态扩展存储节点,无需停机即可增加容量 |

| 高可用性 | 通过多副本和故障转移机制保证服务持续可用 |

| 透明访问 | 对上层应用提供统一命名空间,屏蔽底层存储细节 |

主流分布式文件存储框架对比

以下表格对比了当前常见的分布式文件存储框架的技术特点:

| 框架名称 | 架构模式 | 一致性模型 | 扩展性 | 典型应用场景 | 社区/商业支持 |

|---|---|---|---|---|---|

| HDFS | Master-Slave | 强一致性(Single Master) | 横向扩展(需人工干预) | 大数据分析(Hadoop生态) | Apache开源,企业级支持 |

| Ceph | 无中心(CRUSH算法) | 最终一致性 | 自动负载均衡 | 云存储、块存储、对象存储 | 活跃开源社区,商业版支持 |

| GlusterFS | 无中心(弹性哈希) | 最终一致性 | 动态扩展 | 企业NAS、媒体存储 | 开源,红帽商业支持 |

| MinIO | 无中心(分布式KV) | 强一致性(Quorum) | 容器化部署 | 云原生应用、备份归档 | 开源,兼容S3 API |

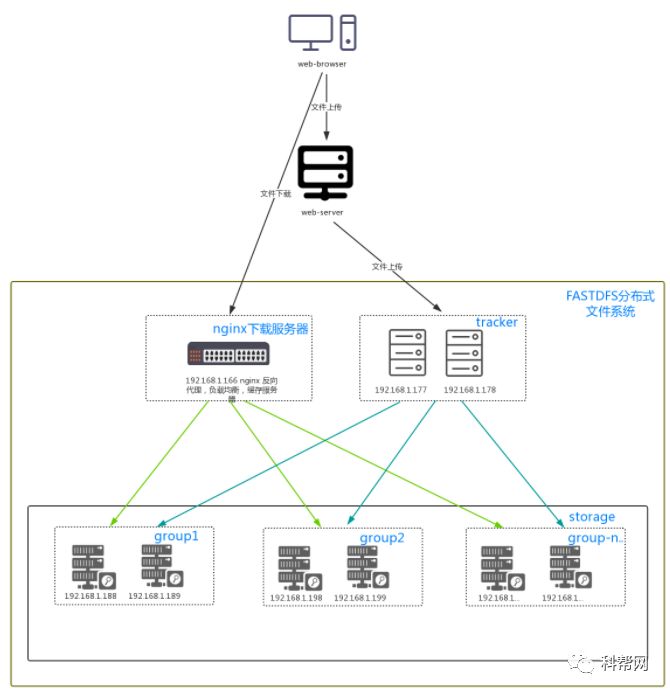

| FastDFS | Master-Slave | 最终一致性 | 分组扩展 | 图片/视频存储、CDN | 国内开源,广泛使用于互联网 |

核心技术实现解析

数据分片与冗余策略

- 固定分片(Fixed Block):如HDFS将文件切分为固定大小(默认128MB)的Block,适合大文件顺序读写。

- 动态分片(Dynamic Shard):如Ceph采用对象存储,根据文件大小动态分配存储空间。

- 冗余方式:

- 副本策略:HDFS默认3副本,简单但存储效率低(300%空间消耗)。

- 纠删码:Ceph支持RS纠删码,5+2配置下存储效率提升至71.4%。

- 混合模式:GlusterFS支持按需选择副本或纠删码。

元数据管理

- 单Master架构:HDFS依赖NameNode管理元数据,存在单点故障风险。

- 无中心架构:Ceph通过CRUSH算法分布式管理元数据,但依赖Paxos协议同步。

- 分区管理:GlusterFS将元数据分片存储,通过弹性哈希实现负载均衡。

一致性保障机制

- 强一致性:MinIO采用Quorum机制,多数节点确认即生效,适合事务型场景。

- 最终一致性:Ceph允许短暂数据不一致,通过后台修复保证最终一致,适合高吞吐场景。

性能优化与容灾设计

性能优化策略

- 数据本地性:HDFS优先从本地节点读取Block,减少网络传输。

- 缓存加速:Ceph支持OSD缓存(如SSD加速)、客户端缓存。

- 并行处理:GlusterFS支持多线程并发读写,吞吐量可达10GB/s+。

容灾与恢复

- 自动故障转移:HDFS Secondary NameNode热备,RPO≈5分钟。

- 多副本地理分布:Ceph支持跨数据中心复制,RTO<1分钟。

- 快照与克隆:GlusterFS提供卷级快照,恢复时间<30秒。

选型建议与实践案例

| 业务场景 | 推荐框架 | 理由 |

|---|---|---|

| 大数据分析(Hadoop) | HDFS | 深度集成MapReduce,支持TB级文件处理,社区成熟 |

| 云存储服务 | Ceph/MinIO | Ceph提供块/对象/文件统一存储,MinIO兼容S3且轻量 |

| 企业NAS替代 | GlusterFS | NFS/Samba协议支持,POSIX兼容性好,适合传统企业迁移 |

案例:某互联网公司采用Ceph构建混合云存储,通过RADOSGW提供S3接口,CRUSH算法实现跨AZ负载均衡,纠删码配置使存储成本降低40%,同时满足99.99% SLA。

常见问题与解决方案

FAQs

Q1:如何选择分布式文件存储框架?

- 评估维度:

- 数据特征:大文件(HDFS)、小文件(FastDFS)、混合类型(Ceph)。

- 一致性要求:金融数据选强一致性(MinIO),日志数据允许最终一致(Ceph)。

- 成本敏感度:纠删码(Ceph)比副本策略节省存储空间。

- 验证方法:通过基准测试工具(如FIO、Ceph Bench)模拟实际负载。

Q2:分布式存储如何应对节点故障?

- 检测机制:心跳检测(如Ceph的Monitor守护进程)。

- 数据恢复:自动触发副本重建(HDFS Replication Manager)。

- 脑裂防护:Paxos协议(Ceph)或仲裁机制(MinIO Quorum)