上一篇

分布式架构数据库1111优惠活动

- 行业动态

- 2025-05-06

- 2

分布式架构数据库11.11限时特惠,高性能、高可用、灵活扩展,助力企业降本增效!活动仅限当日

分布式架构数据库在1111优惠活动中的核心作用与实践

背景与需求分析

在电商大促场景(如双11、618等)中,短时间内爆发的流量洪峰、海量订单处理、实时数据计算等需求对数据库系统提出了极高要求,传统集中式数据库难以应对高并发、高可用、弹性扩展等挑战,而分布式架构数据库凭借其天然优势成为破解这一瓶颈的关键工具,以下从技术实现、业务价值、典型案例等维度展开分析。

分布式架构数据库的核心优势

| 特性 | 传统数据库 | 分布式数据库 | 1111场景适配度 |

|---|---|---|---|

| 扩展性 | 纵向扩展(硬件升级) | 横向扩展(节点增减) | |

| 高可用性 | 主备模式(单点风险) | 多副本冗余、自动故障切换 | |

| 性能 | 单机性能瓶颈 | 分片并行处理、负载均衡 | |

| 成本 | 高端硬件依赖 | 普通PC服务器集群+软件优化 | |

| 数据一致性 | 强一致性(事务保证) | 最终一致性(CAP定理权衡) |

注:1111场景下,分布式数据库通过牺牲部分强一致性(如采用异步复制),换取更高的可用性和扩展性,符合大促场景对“快速响应”和“服务不中断”的核心诉求。

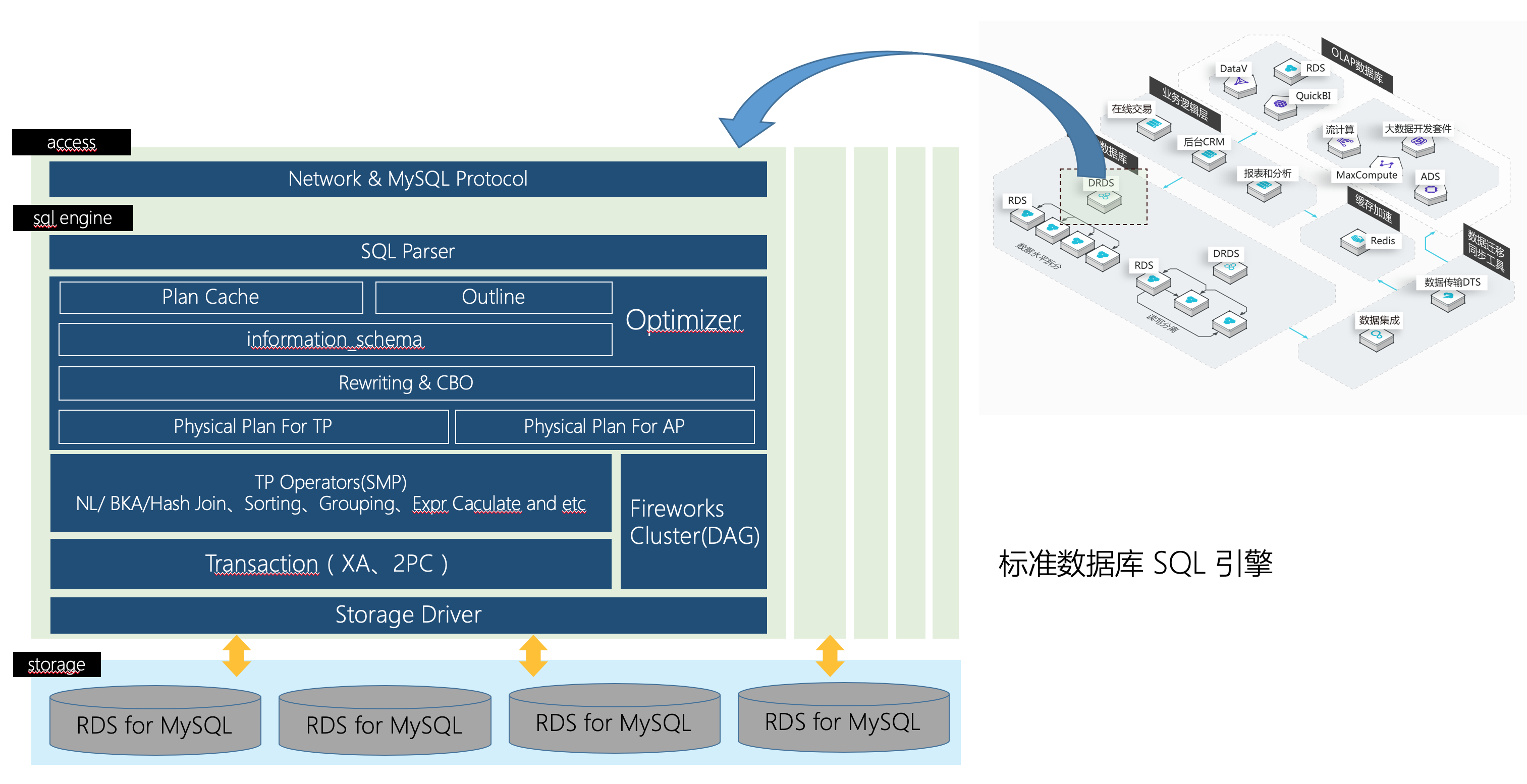

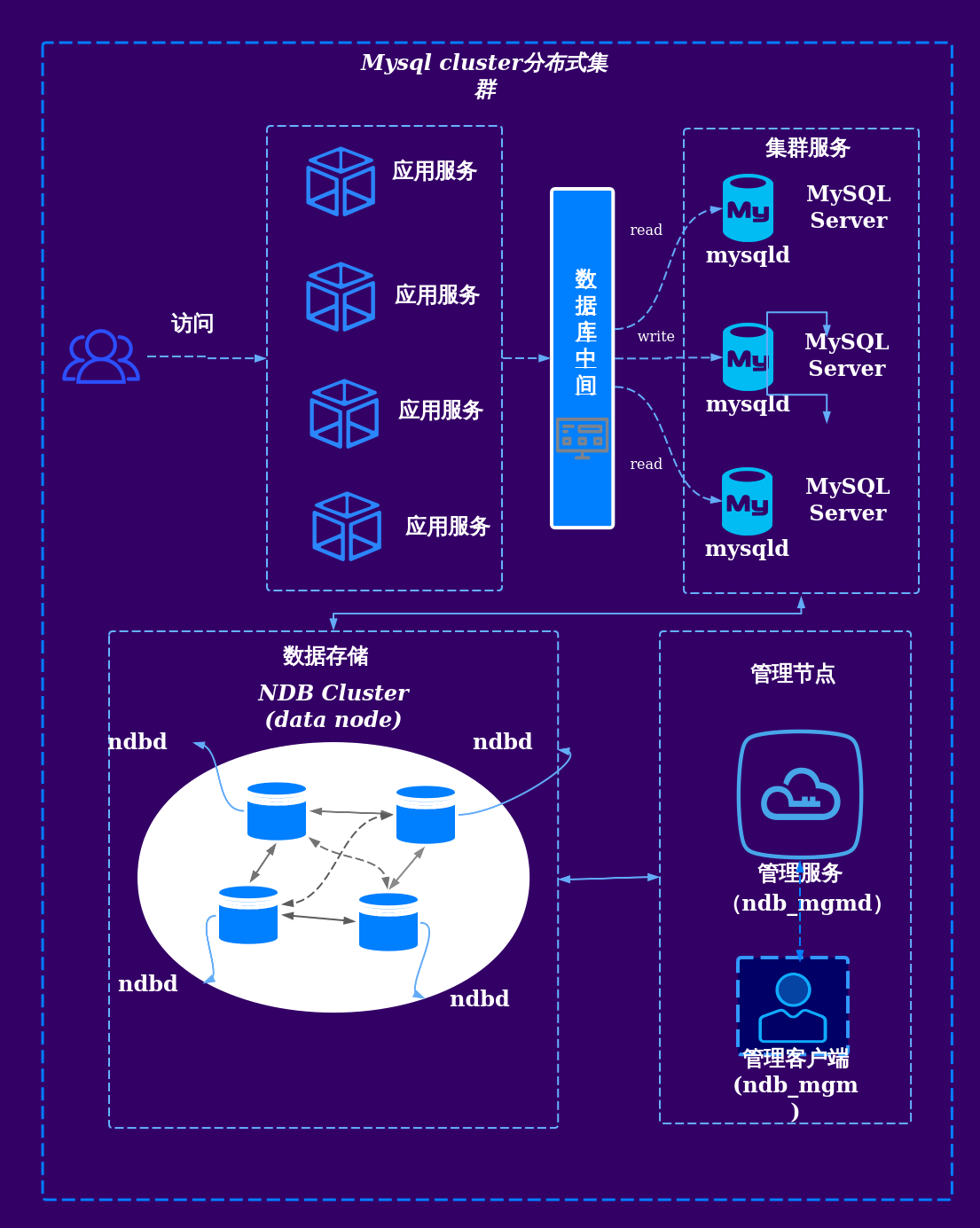

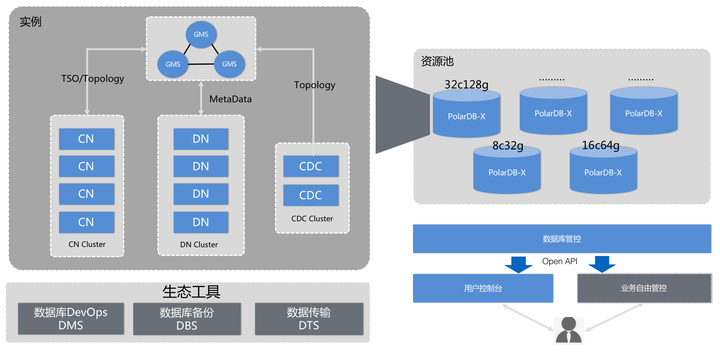

技术实现与关键组件

分片(Sharding)机制

- 范围分片:按用户ID、时间等维度划分数据,避免热点集中。

- 哈希分片:均匀分散数据,提升并行处理能力。

- 示例:某电商平台将订单数据按用户尾号分片,分散至10个节点,每秒可处理百万级请求。

多副本与一致性协议

- Paxos/Raft协议:保障多副本数据一致,支持自动选主与故障恢复。

- 读写分离策略:读操作指向副本,写操作同步至主节点,降低主库压力。

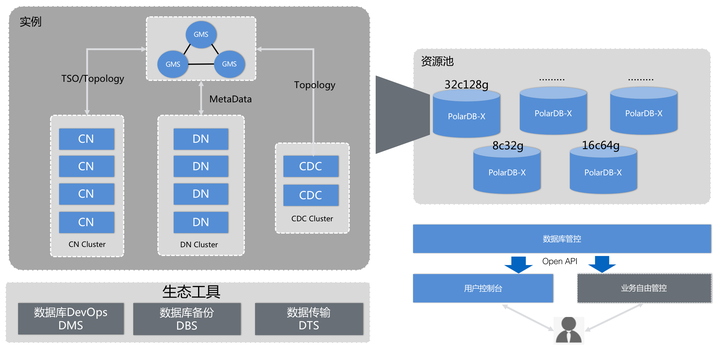

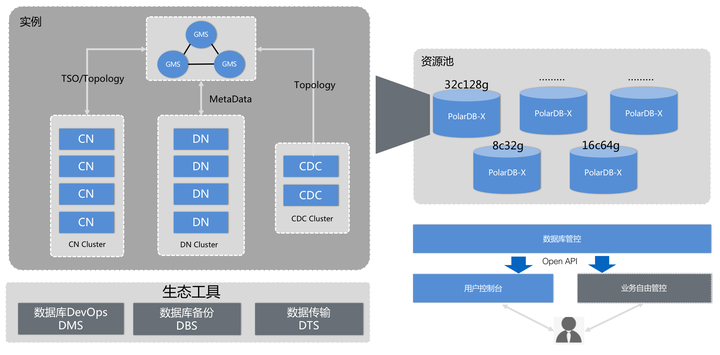

弹性伸缩能力

- 动态扩容:基于流量预测自动增加节点(如阿里云PolarDB秒级扩容)。

- 容器化部署:结合K8s实现资源池化,快速响应峰值需求。

缓存与加速层

- Redis/Memcached:缓存热点数据(如商品详情、购物车),减少数据库访问。

- 异步队列:削峰填谷,将非实时任务(如日志、结算)异步处理。

1111场景下的典型应用

| 业务场景 | 技术方案 | 效果提升 |

|---|---|---|

| 瞬秒抢购 | 分布式锁+限流算法+分片存储 | 避免超卖,支撑千万级TPS |

| 订单处理 | 消息队列(Kafka/RocketMQ)+分库分表 | 订单写入延迟<50ms,成功率>99.9% |

| 实时大屏 | 日志采集(Flink)+时序数据库(TDEngine) | 数据延迟<1s,支撑百万人次并发查询 |

| 容灾演练 | 多活数据中心+流量调度(DNS/SLB) | 故障自愈时间<30秒 |

案例:某头部电商平台在2023年双11期间,通过分布式数据库实现:

- 订单峰值处理能力达120万笔/秒

- 数据库成本降低40%(相比传统架构)

- 核心服务可用性达99.99%

挑战与解决方案

数据一致性问题

- 挑战:分布式事务可能导致性能下降或数据不一致。

- 方案:采用Base理论(基本可用、软状态、最终一致),结合TCC(Try-Confirm-Cancel)模型处理关键业务。

网络延迟与分区故障

- 挑战:跨机房/地域部署时,网络抖动可能影响同步效率。

- 方案:部署就近接入层(如CDN)、使用RPC框架(如gRPC)优化通信。

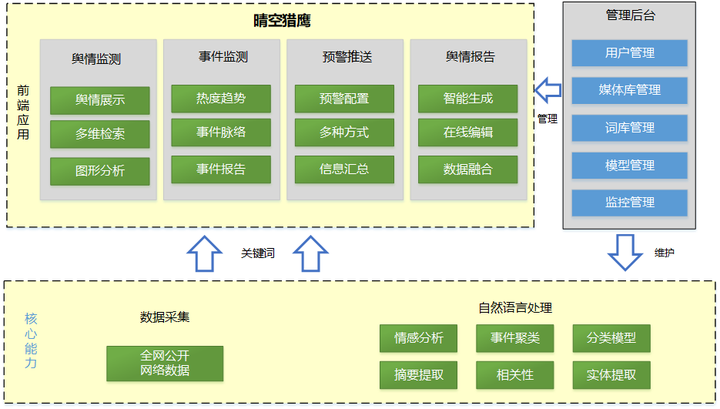

监控与运维复杂度

- 挑战:节点增多导致故障定位困难。

- 方案:引入Prometheus+Granfana监控体系,结合AIOps实现异常预测。

未来趋势与优化方向

| 技术方向 | 落地场景 |

|---|---|

| Serverless化 | 按需计费,冷启动速度优化 |

| AI协同 | 智能分片、自适应索引优化 |

| 多模数据处理 | 支持JSON/XML/时序数据混合存储 |

| 边缘计算集成 | 在离用户最近的节点完成数据预处理 |

FAQs

Q1:如何判断业务是否需要分布式数据库?

A1:若业务存在以下特征,建议优先考虑分布式架构:

- 单日峰值流量超过百万级;

- 数据量TB/PB级且持续增长;

- 需要99.9%以上服务可用性;

- 业务存在明显波峰波谷(如电商大促)。

Q2:分布式数据库在1111活动中的成本如何控制?

A2:成本优化可从以下角度入手:

- 资源弹性:活动前扩容,结束后释放闲置资源;

- 冷热分离:历史数据迁移至低成本存储(如对象存储);

- 按需付费:选择Serverless模式或按量计费服务;

- 混部部署:在非核心业务低谷期复用