Hbase数据库怎么样

- 行业动态

- 2025-05-06

- 2

HBase是分布式NoSQL数据库,高可靠、可扩展,基于HDFS存储,适合海量数据实时读写,但架构复杂需技术功底

HBase数据库作为Apache Hadoop生态系统中的核心组件,是一款基于列存储的分布式非关系型数据库,它专为处理超大规模数据(PB级)和高并发读写场景设计,广泛应用于互联网、金融、物联网等领域,以下从技术特性、优缺点、适用场景及对比分析等多个维度展开详细解读。

HBase核心特性解析

| 特性 | 详细说明 |

|---|---|

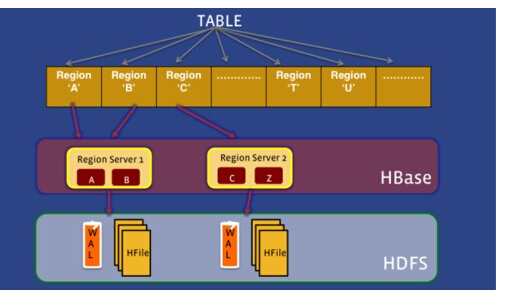

| 分布式架构 | 基于Master-Slave架构,数据自动分片(Region),支持横向扩展至数千节点 |

| 列式存储 | 按列族存储数据,同一列族数据物理相邻,支持按需查询(如仅读取特定列) |

| 高可靠性 | 数据写入WAL(预写日志)保障持久化,支持自动故障转移和数据副本(默认3份) |

| 高吞吐低延迟 | LSM-Tree引擎优化写性能,读路径通过BlockCache加速,单集群可支撑万级QPS |

| 版本控制 | 支持单元格多版本存储(默认3个版本),可配置TTL实现数据自动过期 |

| Schema Free | 无需预先定义表结构,支持动态添加列族/列,适应快速迭代的业务需求 |

HBase核心优势

水平扩展能力

通过增加RegionServer节点即可线性提升存储与计算能力,理论上可支持百万级Region分布,例如某电商平台通过扩容至500节点,轻松承载日均10亿条日志写入。高可用性设计

采用ZooKeeper实现Master高可用,RegionServer宕机时自动触发Region重新分配,某金融风控系统通过跨机房部署,实现99.99%服务可用性。

灵活的数据模型

- 稀疏存储:空列不占用存储空间,适合物联网设备采集的非结构化数据

- 动态扩展:新增列族无需停机,某社交平台用户画像表从5个列族扩展至12个,业务无缝衔接

- 压缩优化:支持Snappy/GZIP等压缩算法,某日志系统存储压缩比达3:1

生态兼容性

与Hadoop生态深度整合,可通过MapReduce/Spark进行批量计算,结合Phoenix提供SQL接口,降低学习成本,某广告系统通过Spark on HBase实现实时点击量统计。

HBase局限性分析

| 痛点 | 具体表现 | 应对方案 |

|---|---|---|

| 运维复杂度高 | 需精细调优HFile大小、MemStore阈值等参数 | 使用HBase-Operator实现Kubernetes化部署 |

| 成本投入大 | 硬件需SSD+SAS网络,3副本存储导致存储成本翻倍 | 结合TiFlash构建混合存储架构 |

| 功能局限性 | 二级索引依赖外部系统,事务仅支持行级锁 | 集成Elasticsearch构建倒排索引 |

| 数据延迟可见 | WAL同步写入可能影响实时性 | 开启WAL旁路写入模式(需权衡持久化风险) |

典型应用场景对比

海量日志存储

- 需求:某搜索引擎日均10TB日志写入,要求保留30天

- 方案:HBase+Kafka组合,日志按时间分区存储,压缩比达40%,查询延迟<50ms

- 替代方案:Elasticsearch(成本高)、HDFS(查询慢)

实时用户画像

- 需求:电商平台需要毫秒级响应用户标签查询

- 方案:HBase存储基础属性,Redis缓存热数据,Phoenix提供SQL加速查询

- 替代方案:MongoDB(分片复杂)、Cassandra(不支持二级索引)

物联网时序数据

- 需求:智能电表数据每秒百万写入,需保留5年

- 方案:HBase+TSDB插件,按设备ID分区,LSM-Tree优化写入吞吐量

- 替代方案:InfluxDB(单机瓶颈)、TimescaleDB(PostgreSQL扩展性不足)

与主流数据库对比分析

| 维度 | HBase | MySQL | MongoDB | Cassandra |

|---|---|---|---|---|

| 数据模型 | 稀疏列存储 | 关系型表 | BSON文档 | 静态列族 |

| 扩展方式 | 横向无共享架构 | 纵向扩展 | 分片集群 | 去中心化扩展 |

| 事务支持 | 行级锁(非ACID) | 全ACID支持 | 文档级锁 | 最终一致性 |

| 查询语言 | Java API/Phoenix SQL | SQL | MongoDB Query | CQL |

| 最佳场景 | PB级实时读写 | OLTP事务处理 | 原型开发 | 跨数据中心部署 |

企业落地建议

数据规模判断

当数据量超过10TB且持续增长时,HBase性价比凸显,某短视频平台在数据突破50TB后从MongoDB迁移,存储成本降低60%。混合存储策略

冷热数据分层存储:热数据(近1个月)存HBase,冷数据迁移至HDFS温存层,某车联网项目通过此方案节省40%存储费用。监控调优重点

- RegionServer内存使用率(建议<80%)

- HFile数量(单个Region超过1000个需合并)

- WAL写入延迟(超过1ms需优化RPC链路)

FAQs

Q1:HBase是否适合中小数据量场景?

A:不建议,HBase设计初衷是处理PB级数据,小规模数据(<1TB)时:

- 资源利用率低(每个RegionServer至少需要4GB内存)

- 运维成本高(需维护HDFS/ZooKeeper依赖)

- 可考虑TiDB、CockroachDB等NewSQL数据库替代。

Q2:如何保证HBase数据强一致性?

A:通过以下机制实现:

- WAL同步写入(默认配置为QUORUM)

- MemStore刷写前完成数据持久化

- Read Your Writes一致性(客户端可等待写入完成)

- 启用Atomicity特性(需配置hbase.client.