hive在数据仓库里面的应用

- 行业动态

- 2025-05-07

- 3

Hive是Hadoop生态的数据仓库工具,通过类SQL语法(HQL)实现海量数据存储与分析,将查询转化为MapReduce任务,支持复杂ETL和OLAP场景,适用于

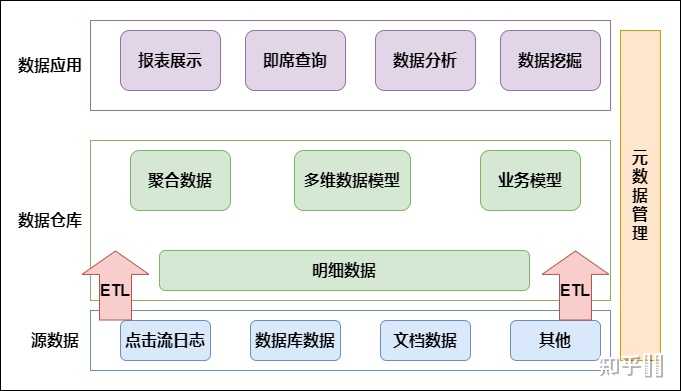

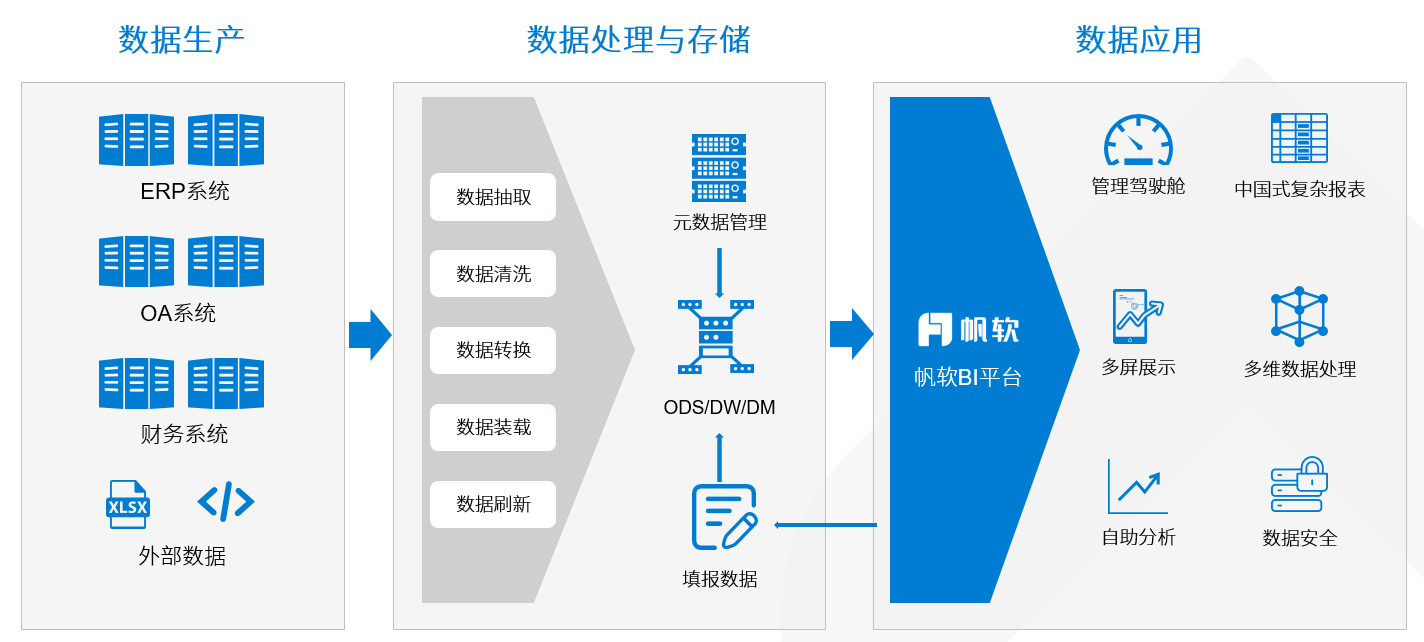

Hive作为构建在Hadoop生态系统之上的数据仓库工具,在大数据存储与分析场景中扮演着核心角色,其通过类SQL语法(HiveQL)实现对分布式存储数据的高效管理,尤其适用于离线批处理场景,以下从技术架构、核心特性、应用场景及优化策略四个维度展开分析:

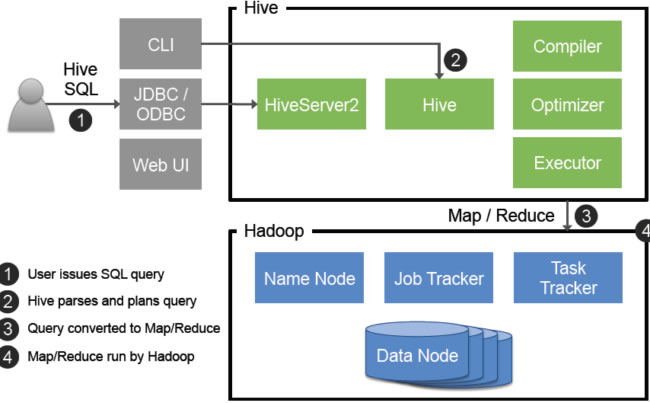

技术架构解析

Hive采用典型的Master/Slave架构,核心组件通过协同工作完成数据存储与查询任务:

| 组件名称 | 功能描述 |

|---|---|

| Driver | 负责编译HiveQL语句并提交执行计划,支持JDBC/ODBC等多种接口 |

| Compiler | 将HiveQL转换为MapReduce/Tez/Spark等计算框架可执行的任务 |

| MetaStore | 元数据管理系统(默认使用内嵌Derby数据库),存储表结构、分区等信息 |

| Execution Engine | 任务执行层,支持多种计算引擎(MapReduce/Tez/Spark) |

| Storage Handler | 底层存储抽象层,兼容HDFS、S3、HBase等多种存储系统 |

该架构通过解耦元数据管理与数据存储,实现了PB级数据的高效管理,值得注意的是,Hive的元数据服务(MetaStore)可独立部署,支持高可用集群配置。

核心竞争优势

与传统数据仓库相比,Hive在以下方面具有显著优势:

弹性扩展能力

通过Hadoop分布式文件系统(HDFS)实现水平扩展,单集群可支持EB级数据存储,计算资源可动态扩展,某电商平台实测数据显示,采用Tez引擎的Hive集群在双十一期间可将查询吞吐量提升300%。

多源数据整合

支持通过SerDe(序列化/反序列化)接口兼容JSON、AVRO、ORC等多种数据格式,结合Hive的外部表特性,可实现对Kafka、HBase等异构数据源的统一访问。类SQL开发体验

提供符合ANSI SQL标准的查询语法,降低数据分析人员的学习成本,典型查询示例:SELECT user_id, COUNT() AS visit_count FROM weblog_parquet_table WHERE dt BETWEEN '2023-10-01' AND '2023-10-07' GROUP BY user_id ORDER BY visit_count DESC;

事务与一致性保障

自Hive 2.0起支持ACID事务,通过引入事务锁机制和快照隔离,保证复杂ETL流程中的数据一致性,配合ZooKeeper实现的分布式锁服务,可有效避免并发写入冲突。

典型应用场景矩阵

| 业务场景 | 技术实现方案 |

|---|---|

| 日志分析 | 使用ORC列式存储+Snappy压缩,结合时间分区策略优化查询性能 |

| 用户行为分析 | 构建多维数据立方体(Data Cube),通过Rollup/Cube操作实现多维度聚合分析 |

| 数据湖集成 | 通过Hive外部表映射S3/ADLS Gen2中的数据资产,实现跨云数据联邦查询 |

| 实时数仓补充 | 与Iceberg/Hudi结合,构建流批一体数据处理体系 |

| 机器学习特征工程 | 利用Hive的UDF扩展能力,实现特征清洗、标准化等预处理操作 |

以电商用户画像系统为例,典型数据处理流程如下:

graph TD

A[原始日志] --> B[Kafka采集]

B --> C{Hive数据湖}

C --> D[用户行为宽表]

D --> E[特征加工]

E --> F[机器学习模型]性能优化策略集锦

存储层优化

- 采用ORC/Parquet列式存储格式,开启Snappy/Zlib压缩

- 按业务时间(如小时/天)进行分区,减少全表扫描

- 使用BloomFilter加速分区裁剪

查询优化技巧

- 合理设置并行度参数(mapreduce.job.reduces)

- 启用CBO(基于代价的优化器)自动选择最优执行计划

- 对高频查询字段建立Bitmap/Bloom索引

资源管理策略

- 配置YARN队列限制资源占用

- 使用Tez替代MapReduce提升执行效率(某金融客户实测提升40%)

- 开启中间结果缓存(Intermediate Data Caching)

FAQs

Q1:HiveQL与标准SQL的主要区别是什么?

A:HiveQL在保留标准SQL语法的基础上,扩展了针对大数据处理的特性:

- 增加

TRANSFORM语句支持自定义MapReduce - 提供

LATERAL VIEW实现爆炸式查询(如JSON数组展开) - 支持复杂数据类型(STRUCT/ARRAY/MAP)的直接操作

- 特有的存储格式指定语法(STORED AS ORC)

Q2:如何诊断Hive作业性能瓶颈?

A:建议采用分层排查法:

- 元数据层面:检查MetaStore响应时间,确认无锁等待

- 编译阶段:查看执行计划(EXPLAIN命令),确认无全表扫描

- 运行阶段:通过YARN ResourceManager监控容器分配情况

- IO层面:检查HDFS文件块分布,避免数据倾斜

- 配置验证:核对hive-site.xml中的并行度、内存分配等