上一篇

GPU运算服务器系统如何彻底改变你的计算效率?

- 行业动态

- 2025-05-02

- 2

GPU运算服务器系统是基于图形处理器的高性能计算平台,具备大规模并行运算能力,适用于深度学习、科学仿真及大数据分析等领域,其通过多GPU协同架构与高速互联技术,显著提升计算效率,支持复杂模型训练与实时处理需求,同时优化能耗管理与散热设计,为人工智能和超算场景提供稳定算力支撑。

GPU运算服务器系统:驱动未来计算的核心引擎

在人工智能、深度学习、科学计算等领域飞速发展的今天,传统的CPU算力已难以满足海量数据与复杂模型的需求。GPU运算服务器系统凭借其并行计算能力与高吞吐量特性,成为现代高性能计算(HPC)的基石,本文将从技术原理、核心优势、应用场景及选型指南等多维度,为您解析这一关键技术的核心价值。

什么是GPU运算服务器?

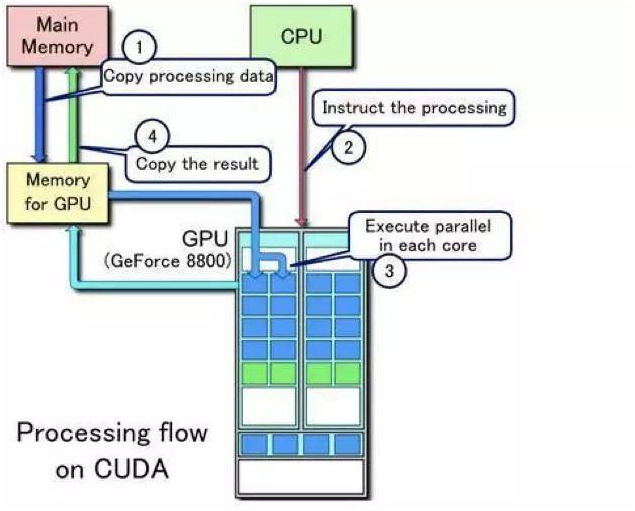

GPU运算服务器是一种专为并行计算设计的硬件系统,其核心组件为图形处理器(GPU),搭配多核CPU、高速内存及网络模块,相较于传统CPU服务器,GPU通过数千个计算核心实现任务并行处理,尤其擅长处理矩阵运算、浮点计算等高密度任务。

GPU vs CPU:算力差异的本质

- CPU:注重通用性,适合串行任务(如逻辑判断、系统调度),但核心数有限(通常为4-128核)。

- GPU:专为并行优化,核心数可达上万(例如NVIDIA H100含16,896个CUDA核心),适合同时处理海量相似任务。

GPU服务器的核心优势

- 算力飞跃

以训练AI大模型为例,单台配备8颗A100 GPU的服务器,算力相当于数百台CPU服务器的集群。 - 能效比提升

GPU的TFlops/Watt(每瓦特浮点运算能力)是CPU的5-10倍,显著降低数据中心能耗。 - 加速创新周期

深度学习训练时间从数周缩短至几小时,助力企业快速迭代产品。

典型应用场景

人工智能与深度学习

- 模型训练:支持Transformer、CNN等复杂架构的分布式训练。

- 推理部署:实时处理图像识别、自然语言理解任务(如ChatGPT类应用)。

科学计算与仿真

- 气候建模:处理PB级气象数据,预测极端天气。

- 生物医药:加速分子动力学模拟,缩短新药研发周期。

图形渲染与元宇宙

- 影视特效:实时渲染4K/8K超高清画面(如《阿凡达2》制作)。

- 数字孪生:构建工厂、城市的虚拟复刻体,支持实时决策。

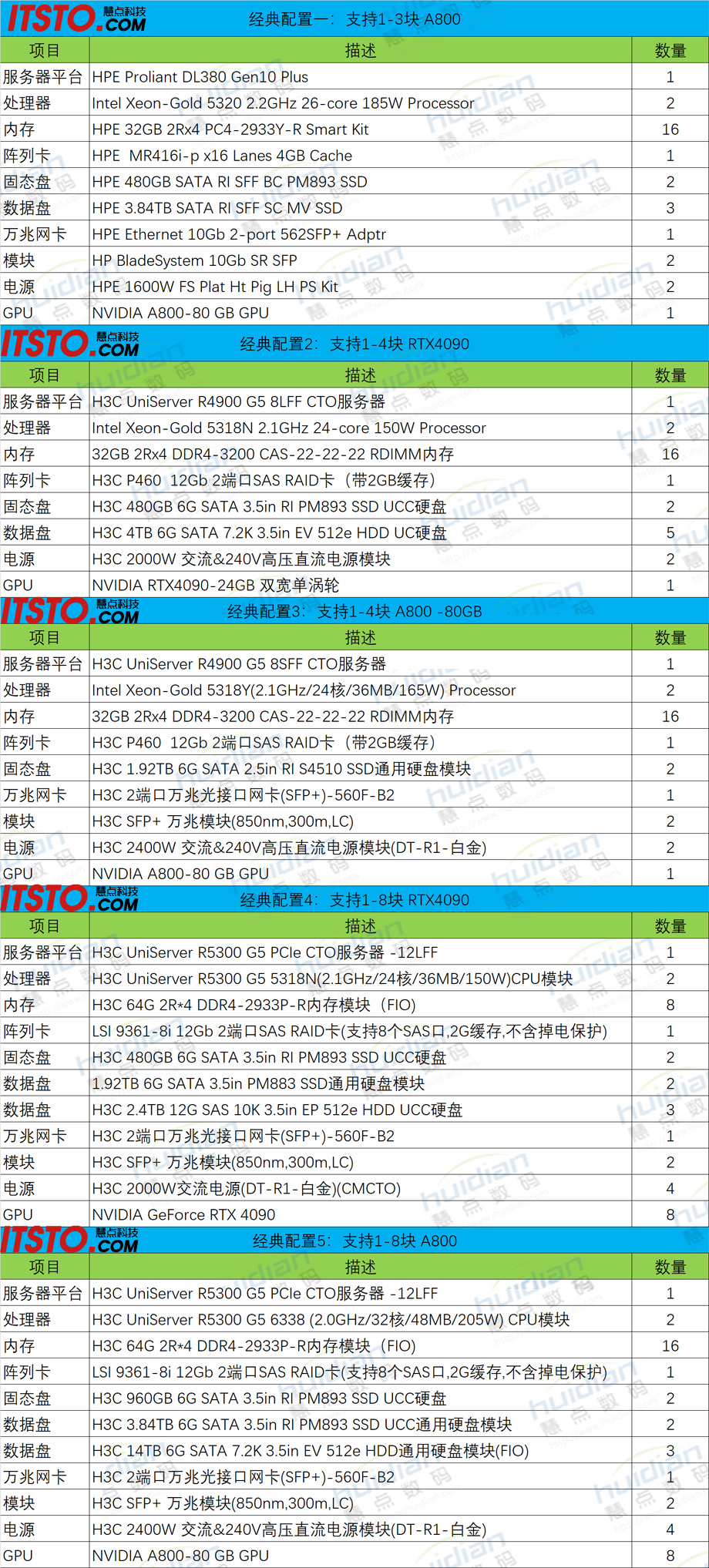

如何选择GPU服务器?

硬件配置要点

| 组件 | 关键指标 | 推荐方案 |

|---|---|---|

| GPU | CUDA核心数、显存容量(≥80GB)、互联带宽 | NVIDIA H100、A100 |

| CPU | 核心数、PCIe通道数 | AMD EPYC 9004/Intel至强铂金系列 |

| 存储 | NVMe SSD阵列、全闪存架构 | 支持RAID 0/1/10 |

| 网络 | 100Gbps RDMA(如InfiniBand) | 低延迟、高吞吐集群通信 |

软件生态支持

- 开发框架:CUDA、TensorFlow、PyTorch的兼容性。

- 虚拟化方案:VMware vGPU、Kubernetes容器化部署。

行业趋势与未来展望

- 异构计算架构普及

CPU+GPU+DPU协同设计,提升资源利用率(参考NVIDIA Grace Hopper超级芯片)。 - 绿色算力革命

液冷技术可将PUE(电源使用效率)降至1.1以下,减少碳排放。 - 云边端协同

边缘GPU服务器支持自动驾驶、工业质检等低延迟场景。

权威数据参考

- 据IDC预测,2025年全球AI服务器市场规模将达318亿美元,其中GPU服务器占比超70%。

- NVIDIA A100在MLPerf测试中,推理性能较CPU提升237倍(来源:MLCommons 2025)。

引用说明

- NVIDIA官方技术白皮书《Accelerated Computing: The Future of HPC》

- IDC报告《Worldwide Artificial Intelligence Server Market Forecast, 2025–2027》

- MLCommons基准测试结果(2025年6月)

通过上述分析可见,GPU运算服务器不仅是算力升级的必然选择,更是推动行业数字化转型的核心动力,企业需结合自身业务需求,从硬件性能、软件生态及长期TCO(总拥有成本)等维度综合评估,方能最大化技术投资回报。