GPU服务器性能提升全靠CPU和内存?

- 行业动态

- 2025-05-05

- 7

GPU服务器中,CPU负责通用计算和任务调度,协调系统资源;内存(RAM)提供临时数据存储空间,保障CPU/GPU高效访问数据;GPU专攻并行计算,加速图形处理、深度学习等复杂任务,三者协同提升运算性能与效率。

在数字化时代,GPU服务器已成为高性能计算领域的核心设备,广泛应用于人工智能、科学模拟、大数据分析等场景,理解其核心组件——GPU、内存和CPU的作用与协作原理,对优化服务器性能至关重要,以下内容将从技术细节、应用场景及选购要点展开,为您提供深度解析。

GPU:并行计算的“加速引擎”

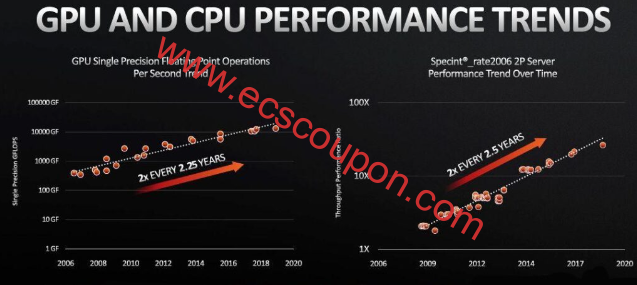

GPU(图形处理器)最初设计用于图形渲染,但因其高度并行计算能力,逐渐成为通用计算的“加速器”,与CPU不同,GPU拥有数千个计算核心(如NVIDIA的CUDA核心、AMD的流处理器),适合处理海量重复性任务。

- 深度学习训练:GPU可同时处理数万次矩阵运算,加速模型收敛。

- 科学模拟:在流体力学或分子动力学中,实时计算数百万个粒子的运动。

- 视频渲染:并行编码/解码4K/8K视频,效率远超CPU。

关键技术指标包括:

- 显存容量与带宽:如NVIDIA A100配备40GB HBM2显存,带宽达1.5TB/s,确保大数据吞吐。

- 计算精度:支持FP16、FP32、FP64等精度,适应不同场景需求。

CPU:通用计算的“指挥中枢”

CPU(中央处理器)是服务器的逻辑控制核心,负责任务调度、系统管理及串行计算,其特点是:

- 高单核性能:适用于复杂逻辑判断、数据库查询等场景。

- 多核多线程:如AMD EPYC处理器提供128线程,可并行处理多个任务。

- I/O控制:管理硬盘、网络等外设的数据流。

在GPU服务器中,CPU的核心作用包括:

- 预处理数据:将原始数据转换为GPU可处理的格式。

- 分配计算任务:协调多个GPU之间的负载均衡。

- 运行非并行程序:如Web服务、文件系统操作。

内存:数据流通的“高速通道”

服务器内存(RAM)是CPU与GPU之间的临时存储介质,直接影响系统整体性能:

- 容量:内存不足会迫使系统使用硬盘缓存,速度下降百倍,处理10亿级数据集的AI训练需至少256GB内存。

- 带宽:DDR5内存带宽达4.8GB/s,减少CPU与GPU间的数据传输延迟。

- 显存 vs 系统内存:显存专供GPU使用,而系统内存供CPU调用,二者通过PCIe总线连接,高带宽PCIe 4.0/5.0可提升数据交换效率。

协同工作原理:三者的黄金三角

GPU服务器的性能取决于CPU、GPU、内存的协同效率,典型流程如下:

- 数据加载:CPU从存储设备读取数据到系统内存。

- 任务分配:CPU将计算密集型任务(如神经网络推理)分配给GPU。

- 并行计算:GPU调用显存数据,利用数千核心加速运算。

- 结果回传:计算结果通过内存返回CPU,进行后续处理。

场景案例:

- AI训练集群:CPU管理分布式节点,GPU集群同步更新模型参数,内存缓存训练数据集。

- 实时数据分析:CPU处理用户查询请求,GPU加速实时特征提取,内存维持高并发访问。

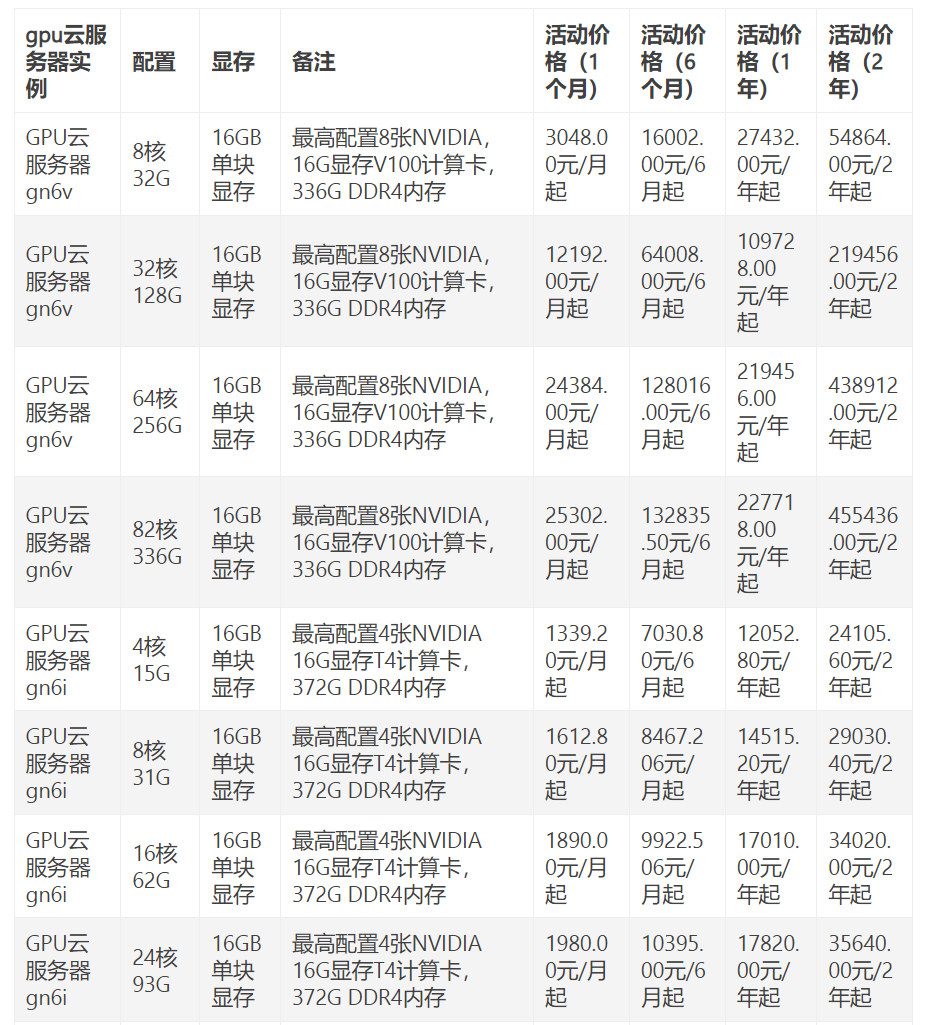

如何选择GPU服务器配置?

- 按场景匹配硬件:

- AI训练:优先大显存GPU(如NVIDIA H100)+ 高内存带宽。

- 边缘推理:中端GPU(如T4)+ 低延迟内存。

- 科学计算:双路CPU(如Intel Xeon Platinum)+ 多GPU互联。

- 平衡瓶颈:

- 避免“GPU强、内存弱”:如使用8块A100的服务器需搭配1TB以上内存。

- 选择PCIe 5.0主板,确保CPU与GPU间带宽充足。

引用说明

本文技术参数参考自NVIDIA官网、AMD处理器技术白皮书,以及《IEEE高性能计算架构研究报告》(2025),应用案例部分数据来源包括Google AI Blog及ArXiv公开论文。