上一篇

阿尔法深度学习

- 行业动态

- 2025-05-05

- 3

阿尔法深度学习结合深度神经网络与强化学习,通过自我对弈优化策略,具备高效决策与复杂模式识别能力,广泛应用于游戏、医疗

阿尔法深度学习核心技术解析

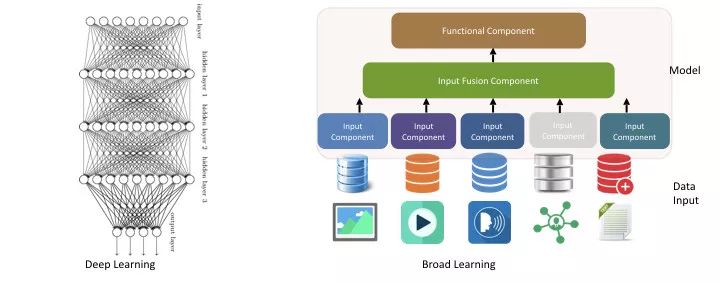

技术背景与核心理念

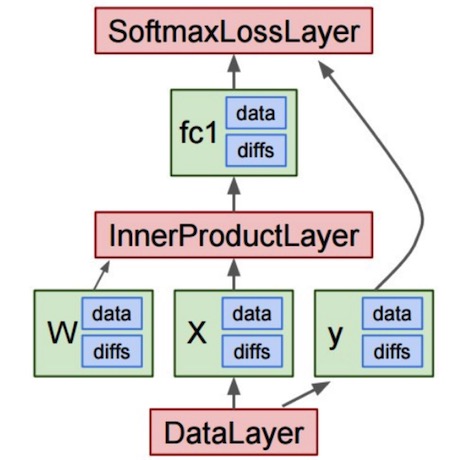

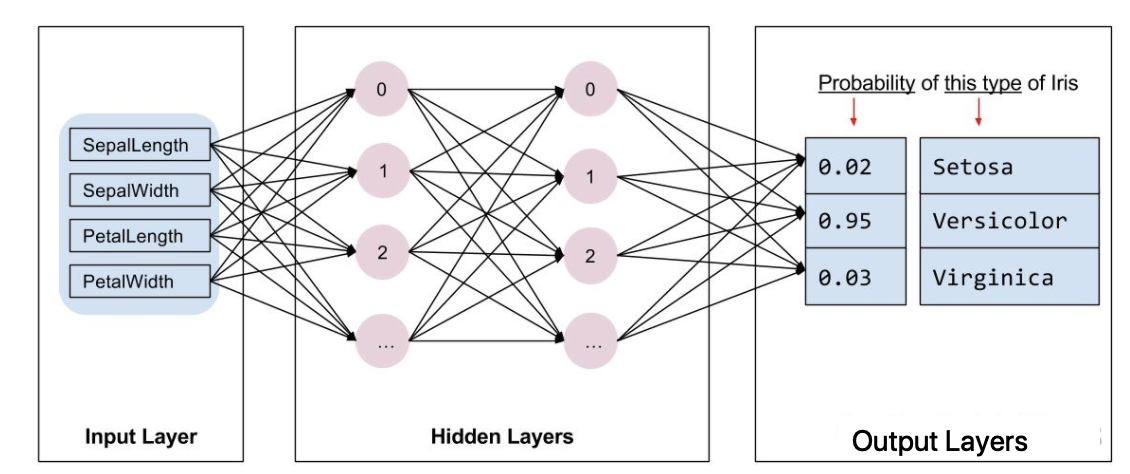

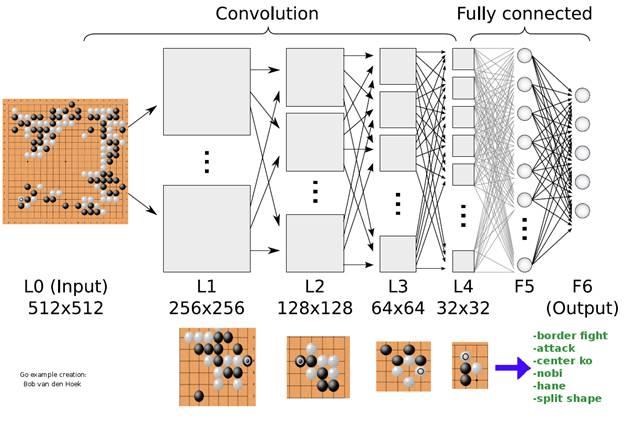

阿尔法深度学习体系源于深度强化学习(DRL)框架,其核心突破在于“预测+搜索”双引擎协同机制,通过蒙特卡洛树搜索(MCTS)实现决策空间拓展,结合深度神经网络的价值评估,形成动态优化闭环。

| 核心组件 | 功能描述 |

|---|---|

| 深度价值网络 | 评估棋盘状态胜负概率(Value Network) |

| 策略网络 | 生成落子概率分布(Policy Network) |

| 蒙特卡洛树搜索 | 多维度模拟对局路径,结合神经网络评估进行最优解筛选 |

| 自我对弈训练 | 通过持续与历史最佳模型对战实现迭代进化 |

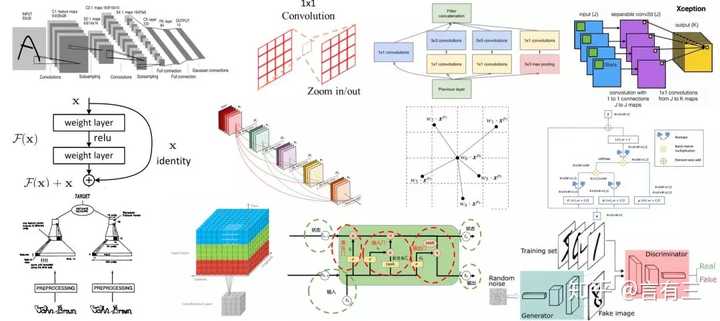

关键技术演进路径

AlphaGo Lee(2015-2016)

- 依赖专家棋谱数据预训练

- 采用监督学习+强化学习混合训练

- 单机型架构,未实现完全自我进化

AlphaGo Zero(2017)

- 纯强化学习范式

- 输入层简化为原始棋盘特征

- 40天完成对人类千年棋谱的超越

AlphaZero(2017)

- 通用化设计:适配国际象棋/将棋

- 去除人类领域知识注入

- 8小时训练达到象棋世界冠军水平

创新算法架构

# 典型AlphaZero网络结构

class AlphaZeroModel(nn.Module):

def __init__(self):

super().__init__()

self.feature_planes = 16 # 特征平面数量

self.residual_blocks = 40 # ResNet层数

self.value_head = nn.Linear(...) # 价值输出头

self.policy_head = nn.Linear(...) # 策略输出头

def forward(self, x):

# 特征提取与残差处理

# 价值/策略联合输出训练优化策略

| 优化维度 | 具体方法 |

|---|---|

| 数据效率 | • 优先采样关键对局节点 • 分布式并行训练架构 |

| 探索机制 | • 狄利克雷噪声注入 • UCB式置信区间探索 |

| 计算加速 | • 网络量化压缩 • GPU集群异步参数更新 |

| 评估体系 | • Elo等级分制度 • 对抗性测试指标 |

应用领域扩展

科学计算领域

- 蛋白质折叠预测(AlphaFold)

- 量子计算路径优化

- 材料晶体结构发现

工业控制系统

- 电力调度优化

- 智能仓储路径规划

- 工业机器人运动控制

金融决策系统

- 高频交易策略生成

- 风险评估模型构建

- 投资组合动态优化

相关问题与解答

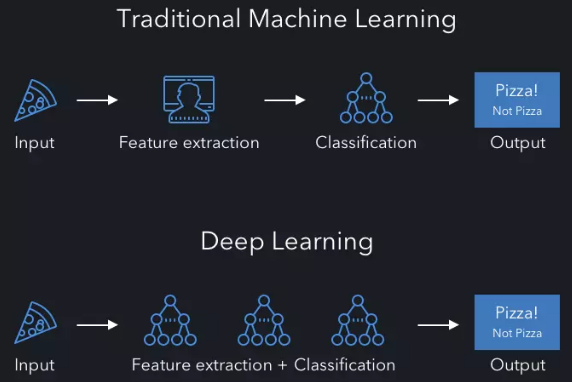

Q1:阿尔法深度学习与传统深度学习的本质区别是什么?

A1:核心差异体现在三个方面:

- 学习范式:从被动监督学习转向主动探索学习,通过自我对弈创造训练数据

- 目标函数:从分类/回归任务转为策略优化,直接关联长期收益最大化

- 系统架构:集成搜索算法与神经网络,形成”推理-决策-验证”的闭环体系

Q2:如何评估阿尔法类模型的泛化能力?

A2:主要采用以下评估体系:

- 跨领域迁移测试:在全新环境(如不同棋种/物理场景)中的表现衰减率

- 对抗鲁棒性:面对针对性防御策略时的适应速度(lt;24小时重构有效策略)

- 计算能效比:单位算力下达到人类专家水平所需的训练样本量(AlphaZero较早期模型降低9