GPU开发中有哪些不可忽视的高效技巧与常见陷阱?

- 行业动态

- 2025-05-03

- 3

GPU开发聚焦于利用图形处理器的高并行架构加速复杂计算任务,涵盖CUDA/OpenCL编程、核心算法优化及内存管理,应用于深度学习、科学模拟与实时渲染领域,通过软硬件协同设计实现高性能计算与能效提升。

什么是GPU开发?

GPU(图形处理器)最初设计用于加速图形渲染,但随着技术进步,其并行计算能力被广泛应用于人工智能、科学计算、游戏开发等领域,GPU开发的核心在于利用其数千个计算核心处理海量数据,实现比传统CPU快数十倍甚至百倍的性能提升。

GPU开发的核心应用领域

人工智能与深度学习

- 训练神经网络模型时,GPU通过CUDA或OpenCL加速矩阵运算,缩短训练时间,训练ResNet-50模型在GPU上仅需数小时,而CPU可能需要数周。

- 框架支持:TensorFlow、PyTorch等均提供GPU加速接口。

科学计算与仿真

在流体力学、分子动力学等领域,GPU可加速大规模数值模拟,NVIDIA的CUDA库(如cuBLAS、cuFFT)被广泛用于优化科学计算代码。

游戏与图形渲染

实时渲染光线追踪(如NVIDIA RTX技术)、物理引擎(如Havok)依赖GPU的并行处理能力,提升画面真实感和交互体验。

区块链与密码学

GPU被用于加密货币挖矿(如以太坊),因其哈希计算能力远超CPU,但随着算法升级(如以太坊转向PoS),开发方向转向零知识证明(ZKP)等新型加速场景。

GPU开发的核心技术栈

编程模型与框架

- CUDA(NVIDIA独占):直接控制GPU硬件,支持C/C++、Python等语言,提供底层优化接口(如共享内存、原子操作)。

- OpenCL(跨平台):适用于AMD、Intel等GPU,兼容移动设备,但需处理不同厂商的硬件差异。

- 高级封装库:如Thrust(C++ STL风格)、CuPy(NumPy兼容),简化开发流程。

性能优化技巧

- 内存管理:减少全局内存访问,优先使用共享内存/寄存器。

- 线程调度:优化线程块(Block)与网格(Grid)的划分,避免资源争用。

- 异步计算:通过CUDA Stream实现数据传输与计算重叠,提升吞吐量。

工具链与调试

- 性能分析器:NVIDIA Nsight、AMD ROCProfiler,用于定位瓶颈(如内存带宽限制)。

- 调试工具:CUDA-GDB、Vulkan调试层,帮助排查内核崩溃或数据竞争问题。

跨平台与异构计算

- Vulkan/DirectX 12:低开销API,支持多GPU协同工作。

- HIP(Heterogeneous-Compute Interface for Portability):AMD推出的代码移植工具,可将CUDA代码转换为兼容AMD GPU的版本。

GPU开发的未来趋势

AI驱动的新型架构

NVIDIA Hopper架构集成Transformer引擎,专为大型语言模型优化;AMD CDNA系列针对机器学习负载优化矩阵运算。

量子计算与GPU混合加速

量子电路模拟(如Google Cirq)依赖GPU集群加速,未来或与量子处理器协同工作。

边缘计算与小型化

嵌入式GPU(如Jetson系列)在自动驾驶、工业机器人中承担实时推理任务。

挑战与开发者建议

- 硬件碎片化:不同厂商的GPU架构差异大,需针对性优化代码。

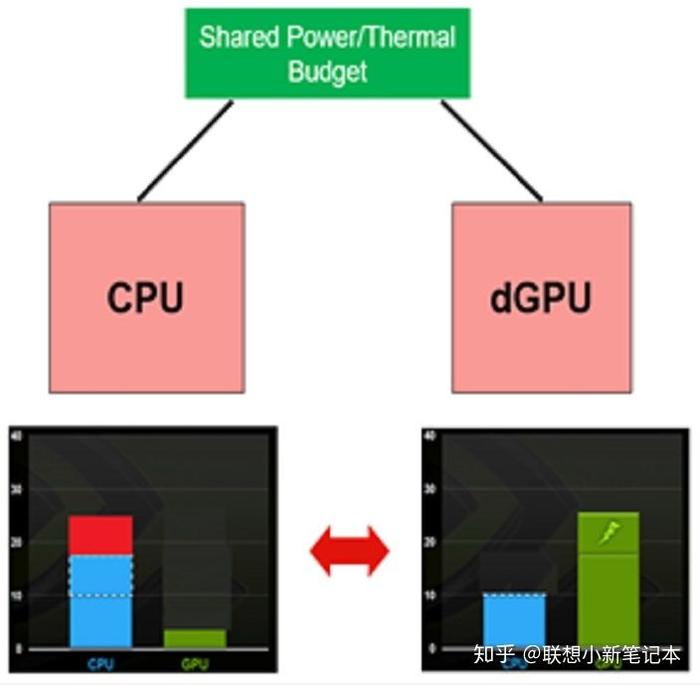

- 能效比要求:移动端和边缘设备需平衡性能与功耗(如使用TensorRT优化模型)。

- 学习路径:建议从CUDA C编程入门,逐步掌握性能分析与异构系统设计。

参考资料

- NVIDIA官方文档:CUDA Toolkit 12.2 Programming Guide

- AMD ROCm技术白皮书(2025)

- IDC报告:全球AI芯片市场增长预测(2022-2026)

- ACM SIGGRAPH论文:GPU加速光线追踪算法优化(2021)