上一篇

为什么创建的外部表没有数据并提示5C错误?

- 行业动态

- 2025-05-05

- 2

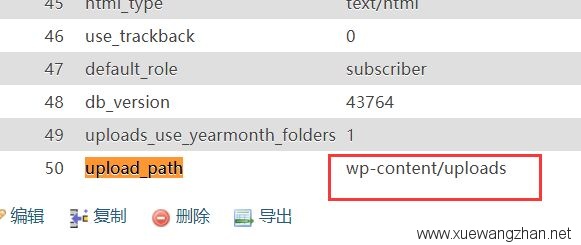

外部表无数据(错误5C)通常由路径错误、权限不足或文件格式不符导致,需检查文件存储路径、用户访问权限及表结构定义是否与数据源格式(如分隔符、编码)匹配,若配置正确但数据仍无法加载,建议验证数据文件完整性或查询系统日志排查具体原因。

在使用大数据平台(如Hive、Spark或云数据库)时,用户可能会遇到“外部表创建成功但查询不到数据,错误提示代码5C”的问题,这种情况通常由数据源配置、权限或元数据错误引起,以下从技术角度提供详细排查方案,帮助用户定位并解决问题。

确认数据源路径是否正确

外部表的核心依赖于数据存储路径,若路径错误,表结构虽能创建,但无法读取数据。

- 检查存储路径是否存在

- 在HDFS或云存储中,通过命令行或管理工具(如Hadoop的

hdfs dfs -ls /path)确认路径存在。 - 示例:若表指向HDFS路径

/user/data/logs,需确保该目录下有文件(如part-00000.parquet)。

- 在HDFS或云存储中,通过命令行或管理工具(如Hadoop的

- 验证路径是否拼写错误

- 注意区分大小写(如

/User/与/user/在Linux系统中为不同路径)。 - 检查特殊字符(如空格、中文符号)是否被转义。

- 注意区分大小写(如

检查文件权限设置

权限问题是导致外部表无法读取数据的常见原因,尤其是在多用户协作环境中。

- 查看文件或目录的访问权限

- 执行

hdfs dfs -ls -h /path,确认当前用户对数据文件有读取权限(Read)。 - 若使用云存储(如AWS S3、阿里云OSS),检查Bucket的ACL策略是否允许当前账号访问。

- 执行

- 修复权限问题

- 对HDFS文件:

hdfs dfs -chmod -R 755 /user/data/logs # 开放读取权限

- 对云存储:在控制台调整Bucket策略,添加

GetObject权限。

- 对HDFS文件:

验证数据格式与表结构是否匹配

若数据文件格式与表定义不兼容,查询时会返回空结果或错误。

- 检查文件格式

- 确认数据文件格式(如Parquet、CSV、JSON)与

CREATE TABLE语句中的STORED AS声明一致。 - 示例:若表定义为

STORED AS PARQUET,但实际文件是CSV格式,则需转换文件或修改表定义。

- 确认数据文件格式(如Parquet、CSV、JSON)与

- 核对字段定义

- 使用

DESCRIBE FORMATTED table_name查看表的元数据,确认字段类型与数据文件匹配。 - 示例:若数据中的

date字段为字符串类型"2025-01-01",但表定义中为TIMESTAMP,需修改表结构或转换数据。

- 使用

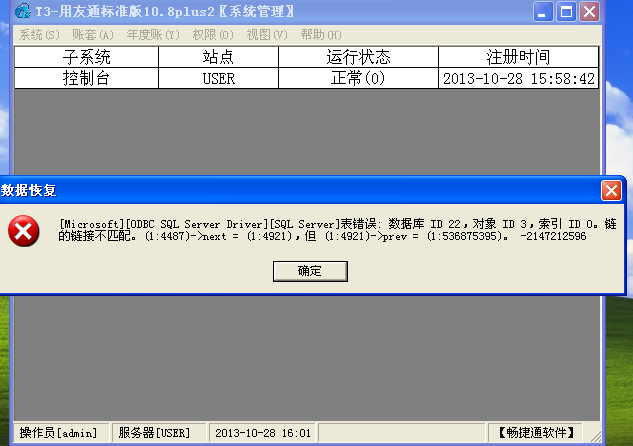

检查元数据缓存与更新

部分平台(如Hive)依赖元数据服务,缓存可能导致数据未及时同步。

- 刷新元数据

- 对Hive执行

MSCK REPAIR TABLE table_name,修复分区元数据。 - 若使用AWS Glue,在控制台触发元数据爬虫重新抓取数据。

- 对Hive执行

- 删除并重建表

- 若元数据损坏,尝试删除外部表后重新创建:

DROP TABLE IF EXISTS table_name; CREATE EXTERNAL TABLE table_name (...) LOCATION '/path';

- 若元数据损坏,尝试删除外部表后重新创建:

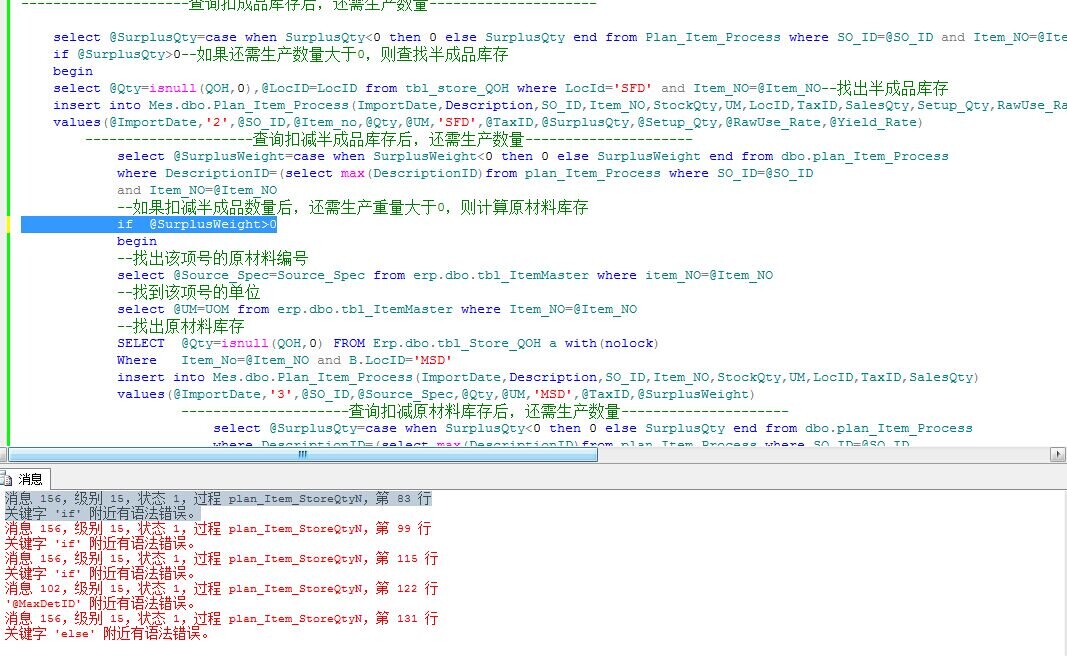

查看错误日志定位具体原因

通过日志获取错误代码5C的详细信息,精准定位问题。

- 查询平台日志

- Hive日志路径:

/tmp/<user>/hive.log - Spark日志:通过YARN UI或Spark History Server查看任务报错信息。

- Hive日志路径:

- 解读错误代码

- Hive的

Error 5C可能关联SemanticException,提示路径不可访问或文件格式解析失败。

- Hive的

验证外部系统状态

若数据源来自第三方系统(如Kafka、MySQL),需确保其运行正常。

- 测试外部系统连接

- 使用命令行工具(如

kafkacat或mysql-client)验证能否读取数据。

- 使用命令行工具(如

- 检查网络配置

确认防火墙未阻止端口(如HDFS的8020端口、MySQL的3306端口)。

分步操作示例(以Hive为例)

-- 1. 创建外部表

CREATE EXTERNAL TABLE logs (

id INT,

event_time STRING,

content STRING

)

STORED AS PARQUET

LOCATION '/user/data/logs';

-- 2. 查询数据(若无结果)

SELECT * FROM logs LIMIT 10;

-- 3. 排查步骤

-- 检查路径是否存在

!hdfs dfs -ls /user/data/logs;

-- 修复权限

!hdfs dfs -chmod -R 755 /user/data/logs;

-- 刷新元数据

MSCK REPAIR TABLE logs;引用说明

本文参考以下技术文档:

- Apache Hive官方指南:Hive External Tables

- AWS S3权限配置:Bucket Policy Examples

- Hadoop文件权限管理:HDFS Permissions