gRPC自带的负载均衡方案能否真正提升你的系统性能?

- 行业动态

- 2025-05-04

- 2

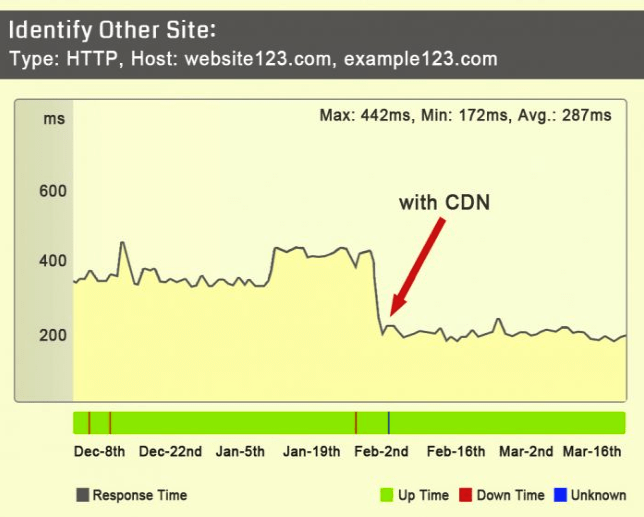

gRPC内置客户端负载均衡机制,支持轮询、加权轮询等策略,通过服务发现获取可用服务端列表,自动分发请求至不同实例,可与DNS、etcd等集成实现动态节点更新,有效分配流量提升系统可用性,避免单点过载并降低延迟。

在分布式系统架构中,gRPC作为高性能、跨语言的RPC框架,其自带的负载均衡方案能有效提升服务可用性和资源利用率,以下是针对gRPC负载均衡机制的深度解析,结合官方文档与实际场景,帮助开发者理解其原理与实现方式。

gRPC负载均衡的核心模式

gRPC负载均衡分为客户端负载均衡与服务端负载均衡两种模式,分别适用于不同场景。

客户端负载均衡(Client-Side LB)

客户端通过内置策略直接选择目标服务实例,减少中间代理开销,适合对延迟敏感的场景。

实现方案:

Proxy模式

客户端通过代理(如Envoy、Nginx)与服务端通信,代理负责维护服务列表并执行负载均衡策略。

优点:简单易用,适合小型系统。

缺点:代理可能成为性能瓶颈。External Load Balancer模式

依赖云服务商(如AWS ALB、GCP Cloud Load Balancing)提供外部负载均衡器。

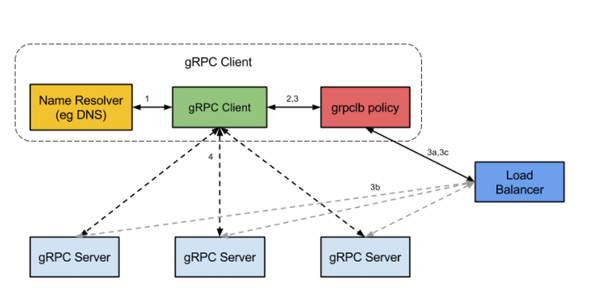

适用场景:云原生环境,服务实例动态扩缩容。Lookaside LB模式(推荐)

客户端通过独立负载均衡协调器(如etcd、Consul)动态获取服务列表,结合本地策略(如Round Robin)决策。

流程示例:- 客户端向协调器查询可用服务列表;

- 协调器返回健康实例地址;

- 客户端根据策略选择实例并建立连接。

优势:高灵活性,支持复杂策略(如权重分配、地域感知)。

服务端负载均衡(Server-Side LB)

由基础设施层实现,常用于Kubernetes或云平台:

- Kubernetes Service:通过kube-proxy和Endpoint实现流量分发。

- 云服务商LB:如阿里云SLB自动分配请求到后端实例。

适用场景:服务实例无状态,且运维团队熟悉云平台工具。

负载均衡策略对比

gRPC支持多种策略,需在客户端或服务端配置:

| 策略 | 原理 | 适用场景 |

|---|---|---|

round_robin | 轮询选择服务实例 | 实例性能均匀的集群 |

pick_first | 始终选择第一个可用实例 | 测试环境或单点服务 |

grpclb | 依赖外部负载均衡器提供决策 | 需要动态权重调整的场景 |

选型建议:如何选择最佳方案?

- 中小规模系统

使用Lookaside LB模式+round_robin策略,平衡性能与复杂度。 - 云原生环境

优先采用云服务商的External Load Balancer,结合自动扩缩容。 - 微服务架构

集成服务网格(如Istio),通过Sidecar代理实现精细化流量管理。

最佳实践与注意事项

- 健康检查机制

客户端或LB需定期探测服务实例状态,避免将请求路由到宕机节点。 - 超时与重试

在gRPC配置中设置合理的超时时间,并启用重试策略(如retryPolicy)。 - 监控与调优

通过Prometheus监控各实例负载,动态调整策略参数。

引用说明参考以下权威资料:

- gRPC官方文档 – 负载均衡

- Google Cloud架构框架 – 负载均衡设计

- Kubernetes Service官方指南