上一篇

host修改内网负载均衡策略

- 行业动态

- 2025-05-04

- 4

修改host内网负载均衡策略需先检查当前配置,通过工具(如Nginx upstream/HAProxy)调整策略类型(轮询/最小连接等),修改健康检查参数及权重分配,保存配置后重启服务,最后通过压力测试验证策略

内网负载均衡策略中Host配置的深度解析与实践指南

内网负载均衡与Host关联的核心概念

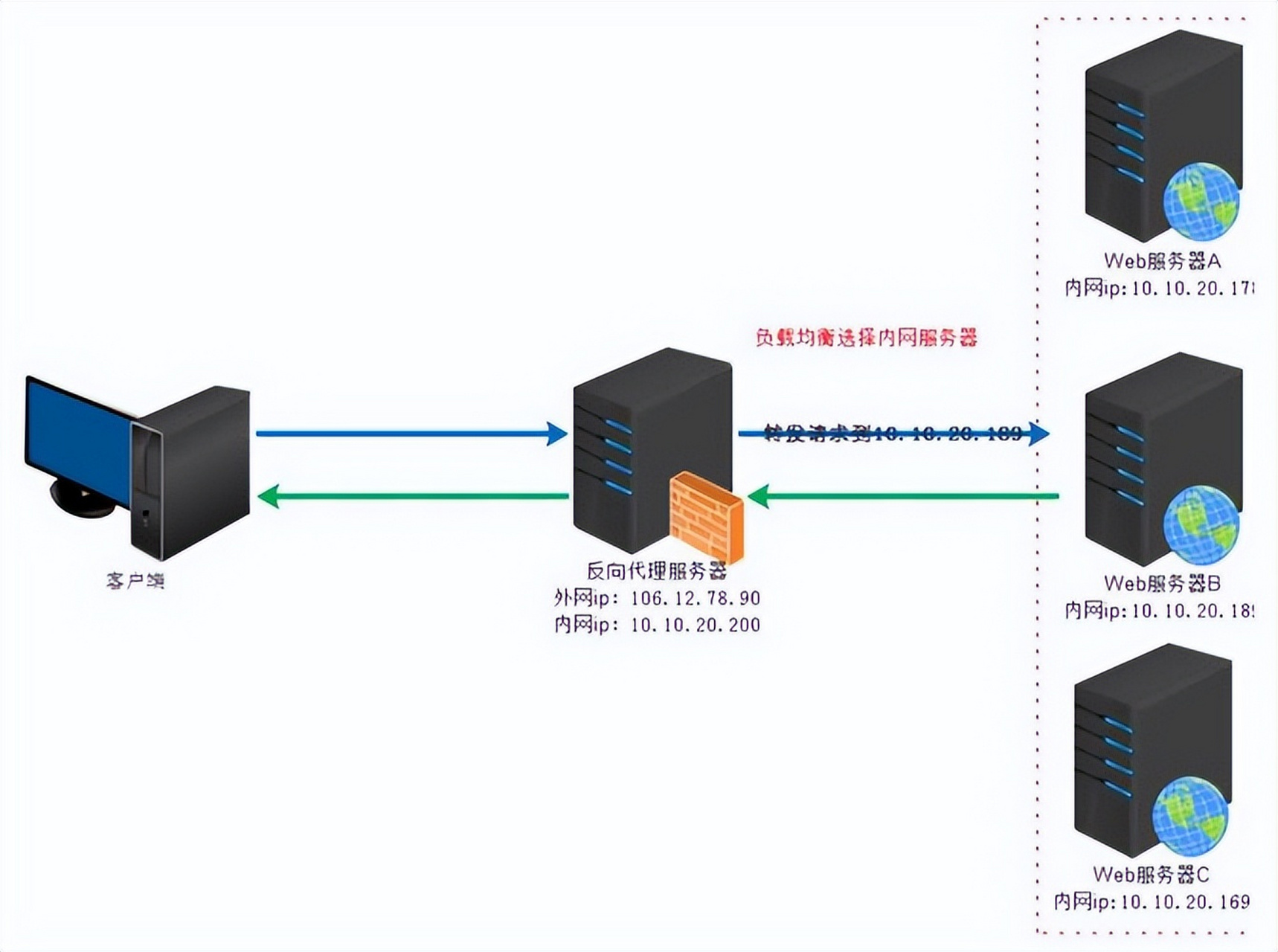

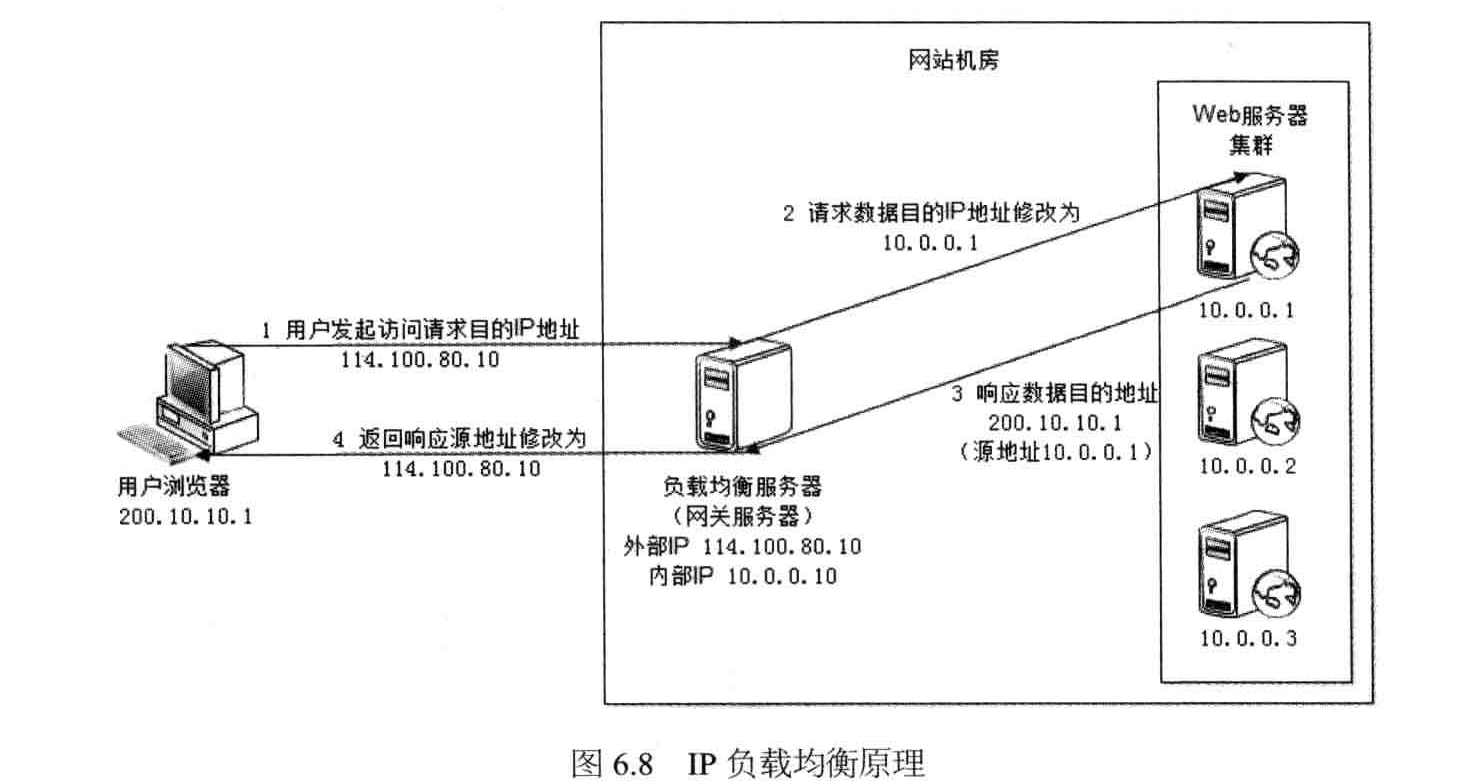

在私有网络环境中,负载均衡器(如Nginx、HAProxy、F5 LTM或云厂商提供的ALB/NLB)通过将客户端请求分配到后端服务器集群实现流量调度。Host字段在此过程中承担双重角色:

- 域名解析入口:客户端通过HTTP Host头指定目标服务(如

api.internal.com) - 策略触发条件:负载均衡器根据Host值匹配不同监听配置和分流规则

| 关键要素 | 说明 |

|---|---|

| Host匹配优先级 | 精确匹配 > 通配符匹配(如.internal.com)> 默认策略 |

| 典型应用场景 | 多租户环境、灰度发布、版本控制、地理路由 |

| 协议层位置 | HTTP层面(TCP/UDP四层负载均衡不处理Host头) |

修改Host相关策略的6大配置维度

当需要调整内网负载均衡策略时,需从以下层面进行Host配置优化:

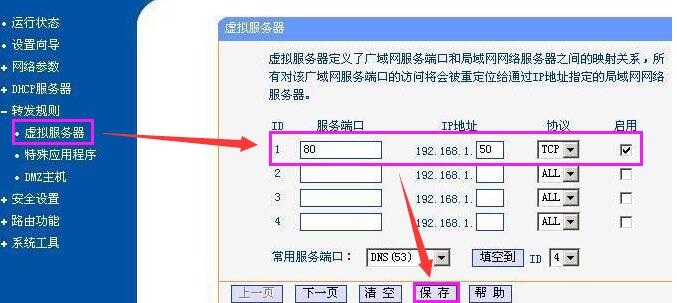

域名解析层(DNS配置)

| 操作项 | 实施要点 |

|---|---|

| 私有DNS记录 | 为每个服务节点创建A记录,TTL设置需平衡解析缓存与故障切换速度(建议<60s) |

| 负载均衡器VIP | 为LB分配固定内网IP,并配置DNS轮询(如lb1.internal.com/lb2.internal.com) |

| 健康检查专用域名 | 设置独立域名(如health.internal.com)用于主动健康检查,避免业务干扰 |

七层负载均衡策略

| 配置类型 | 实施示例 |

|---|---|

| 基于Host的路由规则 | `map $http_host $backend { |

| api.internal.com backend1; | |

| web.internal.com backend2; | |

| .test.internal.com backend3; | |

| default backend_default; | |

| }` | |

| 适用场景:微服务按功能模块划分 | |

| 加权轮询策略 | `upstream backend { |

| server 192.168.1.10 weight=3; | |

| server 192.168.1.11 weight=1; | |

| server 192.168.1.12 backup; | |

| }` | |

| 适用场景:主备架构+动态扩容 |

会话保持机制

| 实现方式 | 配置要点 |

|---|---|

| Cookie插入 | proxy_set_header Cookie $cookie_domain; |

| 需确保Cookie域与Host头一致 | |

| IP粘性哈希 | sticky cookie srv_pool_cookie expire=1h domain=.internal.com; |

| 适用于无状态应用,减少Cookie传输开销 |

SSL/TLS配置

| 证书管理 | 最佳实践 |

|---|---|

| SNI(服务器名称指示) | 为每个Host配置独立证书 |

ssl_certificate /certs/$server_name.crt; | |

ssl_certificate_key /keys/$server_name.key; | |

| Strict Transport Security | 配置HSTS头部强制HTTPS通信 |

健康检查优化

| 检测方式 | 参数调优 |

|---|---|

| HTTP探测 | health_check_url /health + health_check_host header_field(host) |

| 确保健康检查携带原始Host头 | |

| TCP端口探测 | 对数据库等特殊服务启用TCP层面的健康检查 |

| 阈值配置 | nb_get_retry=3 + delay_before_retry=5s |

高级流量管理

| 控制策略 | 实现代码 |

|---|---|

| A/B测试分流 | `map $http_host $ab_test_group { |

| qa.internal.com “groupA”; | |

| prod.internal.com “groupB”; | |

| }` | |

| 灰度发布控制 | `set $weight 0.2; |

| if ($http_cookie ~ “beta_user”) { | |

| set $weight 0.8; | |

| }` |

策略修改的实施流程与风险控制

标准操作流程:

- 配置验证:在测试环境使用

curl -H "Host:test.com" ...模拟请求 - 灰度发布:通过DNS权重逐步切换流量(如10%->50%->100%)

- 监控验证:实时查看LB状态页和后端服务器日志

- 回滚机制:保留旧配置快照,确保可快速回退

典型故障排查矩阵:

| 异常现象 | 可能原因 |

|———————–|————————————————————————–|

| 部分请求无法到达新节点 | DNS缓存未刷新/负载均衡器配置未生效/防火墙规则缺失 |

| 会话中断 | Cookie域配置错误/粘性会话参数不一致/健康检查误判 |

| SSL证书报错 | SNI配置遗漏/证书链不完整/客户端未启用TLS1.2+ |

性能优化建议

| 优化方向 | 实施方案 |

|---|---|

| 连接复用 | 启用Keep-Alive + 调整keepalive_timeout |

| 并发控制 | 配置worker_connections和worker_rlimit_nofile限制 |

| 资源隔离 | 使用容器化部署LB(如Docker+Traefik)实现资源硬限制 |

FAQs

Q1:修改Host策略后部分请求仍然指向旧节点,如何处理?

- 可能原因:

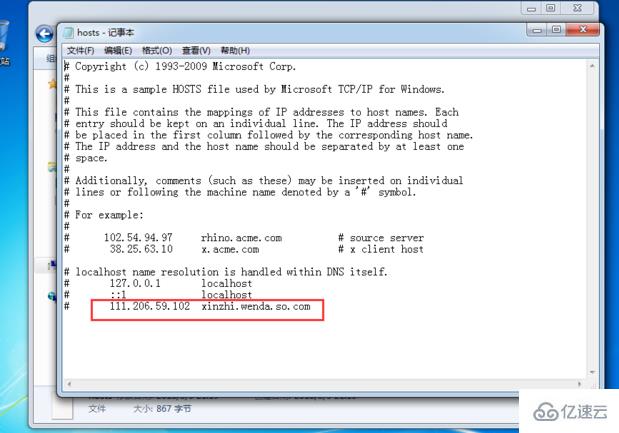

- 客户端DNS缓存未更新(尝试

ipconfig/flushdns或dig +short验证) - 负载均衡器配置未热加载(需执行

nginx -s reload或类似命令) - CDN缓存未失效(如存在全局加速节点)

- 客户端DNS缓存未更新(尝试

- 解决方案:

- 强制刷新客户端DNS缓存

- 检查LB配置版本号是否更新

- 临时禁用CDN加速进行测试

Q2:如何实现基于Host头的动态权重分配?

实现思路:

http { upstream dynamic_pool { server 192.168.1.10 max_fails=3 fail_timeout=30s; server 192.168.1.11 max_fails=3 fail_timeout=30s; } server { listen 80; set $host_weight 1; if ($http_host ~ "critical.internal.com") { set $host_weight 3; } location / { proxy_pass http://dynamic_pool; proxy_set_header X-WeightField $host_weight; # 自定义头部传递权重 } } }扩展应用:结合Lua脚本实现实时权重计算,或