Excel数据去重难题如何借助数据库一键解决?

- 行业动态

- 2025-05-01

- 2

在Excel中去除重复数据,可通过“数据”选项卡中的“删除重复项”功能,选中目标区域后一键操作,也可使用条件格式标记重复值,或利用公式(如COUNTIF)及高级筛选实现,处理前建议备份原始数据,避免误删。

在企业数据处理场景中,Excel表格与数据库的结合使用非常普遍,当需要将Excel数据导入数据库时,重复数据会导致统计误差、存储冗余等问题,本文提供一套完整解决方案,涵盖从Excel预处理到数据库整合的全流程操作指南。

Excel数据去重基础操作

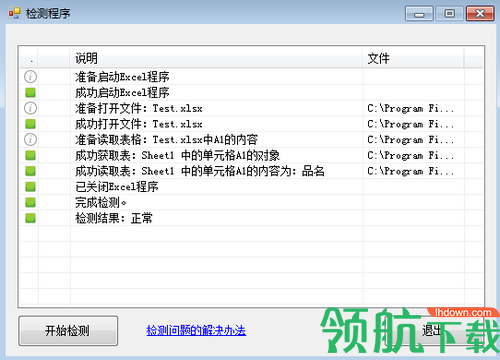

内置去重功能(推荐新手)

- 选中数据区域 → 数据选项卡 → 删除重复值

- 可勾选需校验的列(多列联合校验)

- 自动显示删除结果统计

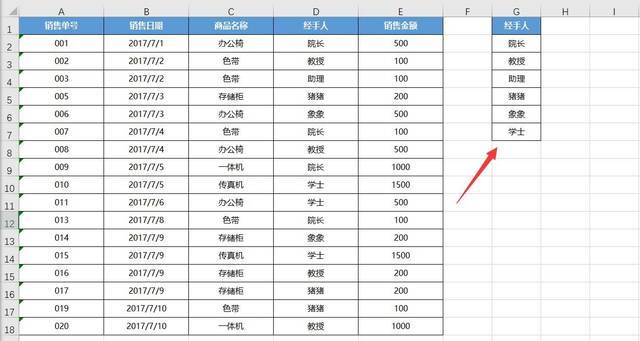

高级筛选法(适合复杂条件)

- 数据选项卡 → 排序和筛选 → 高级

- 选择”将筛选结果复制到其他位置”

- 勾选”选择不重复的记录”

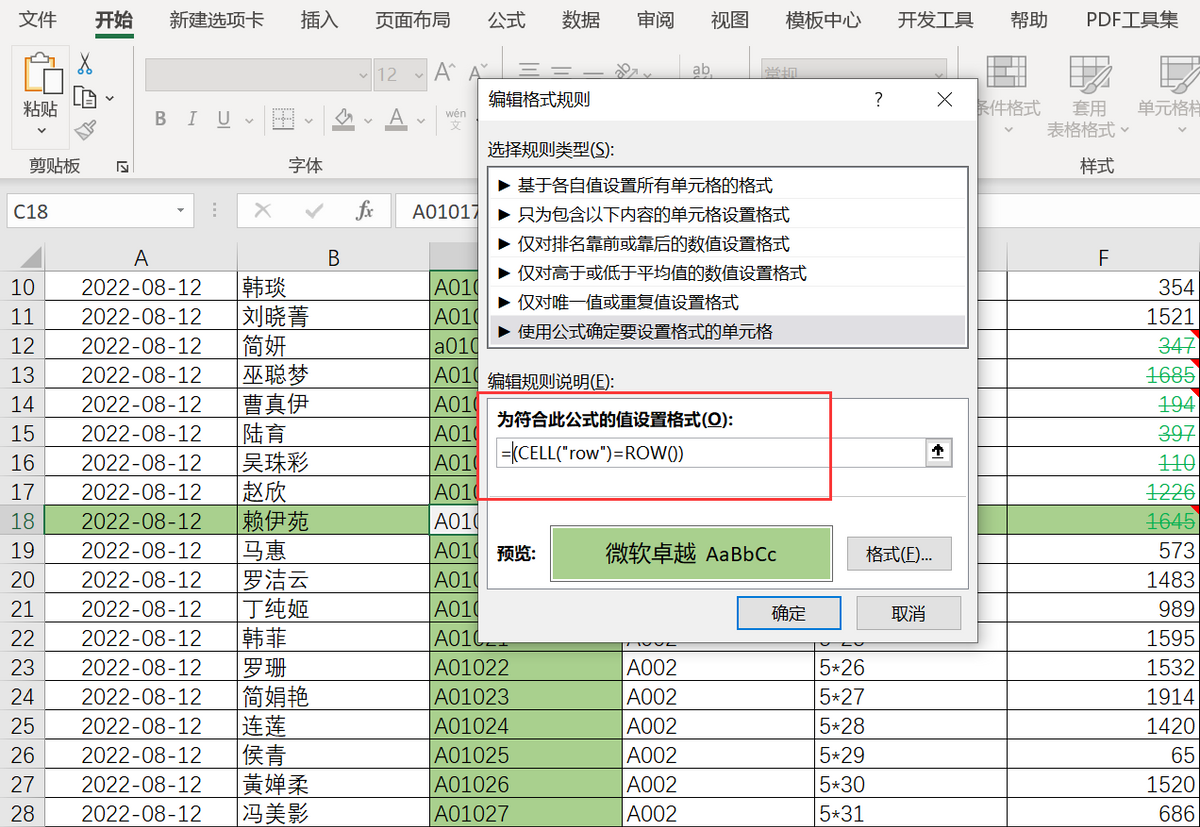

公式辅助定位

- COUNTIF函数检测重复:=COUNTIF($A$1:A2,A2)>1

- 筛选出标记为TRUE的记录进行删除

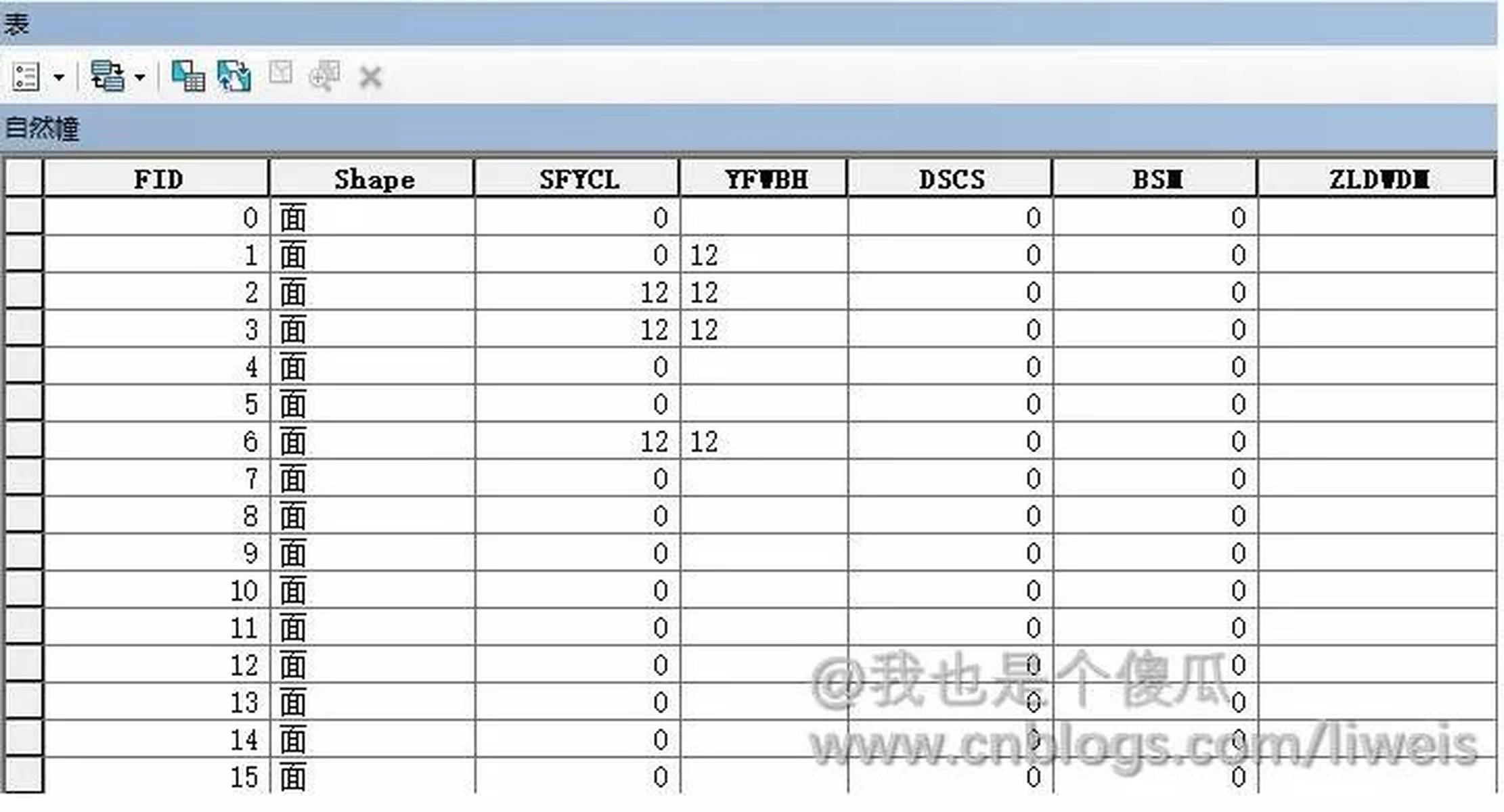

数据库整合阶段去重方案

- 导入前预处理(以MySQL为例)

-- 创建临时表存储Excel数据 CREATE TEMPORARY TABLE temp_table LIKE target_table;

— 导入数据后执行去重插入

INSERT INTO target_table

SELECT DISTINCT * FROM temp_table

ON DUPLICATE KEY UPDATE id=id;

2. 数据库端处理(PostgreSQL示例)

```sql

-- 使用CTE删除重复记录

WITH duplicates AS (

SELECT ctid,

ROW_NUMBER() OVER(PARTITION BY column1,column2) AS rn

FROM your_table

)

DELETE FROM your_table

WHERE ctid IN (SELECT ctid FROM duplicates WHERE rn > 1);- 编程工具辅助(Python案例)

import pandas as pd from sqlalchemy import create_engine

读取Excel并去重

df = pd.read_excel(‘data.xlsx’).drop_duplicates(subset=[‘关键列’])

数据库连接

engine = create_engine(‘postgresql://user:pass@localhost/dbname’)

使用SQL的ON CONFLICT语句处理重复

df.to_sql(‘target_table’, engine, if_exists=’append’,

index=False, method=’multi’,

conflict_resolution=’IGNORE’)

三、混合场景处理策略

1. 增量数据同步方案

- 使用MD5哈希校验:对关键字段生成哈希值

- 建立哈希索引库进行快速比对

- 结合时间戳字段提升比对效率

2. 模糊匹配去重(适用于文本数据)

- 采用Levenshtein距离算法

- 设置相似度阈值(建议80-90%)

- 使用Python的fuzzywuzzy库实现

四、常见问题解决方案

1. 部分列重复判断

- 组合关键字段生成唯一标识

- 使用CONCATENATE函数创建校验列

例:=A2&B2&C2 作为联合主键

2. 大数据量处理技巧

- 分批次处理(建议单次处理<10万行)

- 启用Excel的Power Query工具

- 使用数据库的批量插入功能

3. 误删数据恢复

- 操作前务必创建数据备份

- 使用Excel的版本历史功能

- 数据库开启事务机制:

```sql

BEGIN TRANSACTION;

-- 执行去重操作

ROLLBACK; -- 发现错误时回滚注意事项

业务逻辑确认

- 明确”重复”的判定标准

- 区分数据副本与业务流水记录

- 保留必要的审计字段

性能优化建议

- 对常用查询字段建立数据库索引

- 设置合适的唯一约束

- 定期执行VACUUM/OPTIMIZE TABLE维护

数据完整性检查

- 去重后验证记录总数

- 检查外键关联关系

- 保持数据类型一致性

进阶工具推荐

- OpenRefine:智能数据清洗工具

- Talend:ETL数据处理平台

- Apache Spark:大数据去重框架

引用说明:

- Microsoft官方文档《Excel数据清洗指南》

- W3School SQL教程唯一约束章节

- Pandas官方文档drop_duplicates方法

- PostgreSQL CTE技术白皮书

- Google研究院《数据去重最佳实践》