数据库同步方案可采用主从架构,通过日志解析(如Binlog)或消息队列(如Kafka)捕获变更,结合时间戳校验实现准实时同步,需处理

数据同步方案核心要素分析

需求分析维度

| 维度 | 关键考量点 |

| 同步类型 | 实时/准实时/批量同步 |

| 数据方向 | 单向同步(主->从)/双向同步 |

| 数据量 | 每日增量数据规模(GB/TB级) |

| 网络环境 | 跨机房/跨地域(需考虑网络延迟与带宽限制) |

| 一致性要求 | 强一致性(金融交易)vs 最终一致性(日志分析) |

| 数据库类型 | 同构(MySQL->MySQL)vs 异构(MySQL->MongoDB) |

技术选型矩阵

| 场景 | 推荐工具 | 适用特征 |

| 同构数据库实时同步 | Debezium + Kafka | 支持CDC(变更数据捕获),低延迟 |

| 异构数据库同步 | Apache NiFi + Scripted Processors | 可视化数据流设计,支持自定义转换逻辑 |

| 混合云环境 | AWS DMS + Step Functions | 跨AWS/AZURE/本地数据中心,支持schema转换 |

| 低成本批量同步 | Airbyte + Fivetran | 开源+商业化连接器,支持150+数据源,适合非实时场景 |

| 高并发写入场景 | Kafka + Flink | 分布式流处理,支持每秒百万级消息吞吐 |

典型架构设计方案

基础架构拓扑图

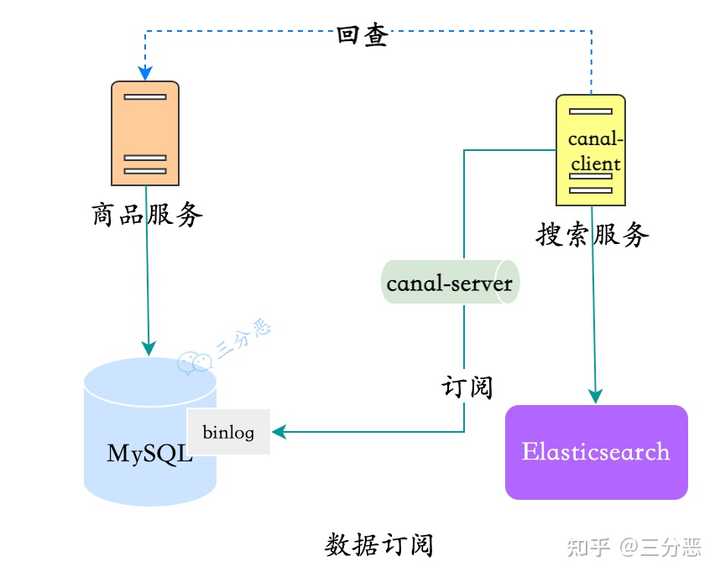

[源数据库] --(Binlog/Oplog)---> [采集器] --(Kafka/MQ)---> [处理器] --(API/JDBC)---> [目标数据库]

▲

|

[Webhook/监控告警]

核心组件说明

- 变更捕获层:通过Debezium监听MySQL的Binlog,或MongoDB的Oplog,捕获数据变更事件

- 消息队列层:Kafka集群作为缓冲区,实现削峰填谷,保证数据可靠传输

- 数据处理层:Flink实时计算引擎进行字段映射、数据清洗、冲突解决

- 目标适配层:针对目标数据库特性开发Loader(如Sink Connector for ClickHouse)

关键技术实现要点

数据一致性保障

- 事务补偿机制:采用预写日志(WAL)方式,确保同步操作与源数据库事务原子性

- 冲突检测策略:

- 时间戳优先级:最后更新时间戳优先

- 版本向量:为每条记录维护版本号(如ODI框架)

- 业务标识冲突:通过预设业务规则(如订单号唯一性)解决冲突

性能优化方案

| 优化方向 | 具体措施 |

| 传输效率 | 启用Kafka压缩(LZ4/Snappy算法),减少网络带宽消耗 |

| 批量处理 | 设置合理的batch size(如500-1000条/批次),平衡延迟与吞吐量 |

| 索引优化 | 为目标数据库建立哈希索引(如Redis)或分区表(如Cassandra) |

| 资源隔离 | 使用容器化部署(Docker/K8s),设置CPU/内存配额,防止资源争抢 |

故障恢复机制

- 断点续传:记录同步位点(checkpoint),重启时从上次完成位置继续

- 数据对账:定期生成数据指纹(如MD5校验和),比对源/目标数据一致性

- 多活架构:采用Raft协议实现同步组件高可用,如etcd集群管理偏移量

实施步骤与规范

标准化实施流程

- 环境调研:绘制数据流向图,统计峰值TPS/QPS

- 沙箱验证:搭建测试环境,模拟全量+增量同步场景

- 灰度发布:选择非核心业务表进行试运行,监控延迟/错误率

- 容量规划:根据数据增长模型,计算存储/计算资源需求

- 监控体系:部署Prometheus+Grafana,设置延迟/丢包/重试率阈值告警

SQL与NoSQL同步特殊处理

- Schema映射:

- 关系型->文档型:将JOIN操作转换为嵌套文档结构(如MySQL的订单表+客户表 -> MongoDB嵌套文档)

- 字段类型转换:DATETIME->ISO8601字符串,DECIMAL->BigDecimal

- 数据裁剪:通过正则表达式过滤掉敏感字段(如身份证号、银行卡号)

典型应用场景方案

场景1:跨地域灾备同步

| 组件 | 配置参数 |

| 源数据库 | 开启Binary Log,设置GTID模式 |

| 传输网络 | AWS Direct Connect专线,带宽>=50Mbps |

| 延迟要求 | <1s(金融交易类数据) |

| RPO/RTO | RPO=0,RTO<30分钟 |

场景2:实时数据分析同步

| 组件 | 配置参数 |

| 源数据库 | 启用逻辑删除标记(如is_deleted字段) |

| ETL引擎 | Flink窗口计算,会话窗口设置为5分钟 |

| 目标数据湖 | 按业务日期分区,ORC列式存储 |

| 数据保鲜期 | 热数据保留7天,冷数据转存至低频存储 |

FAQs

Q1:如何应对源库频繁更新导致的目标库写入冲突?

A1:可采用以下组合策略:

- 乐观锁控制:为目标表增加

version字段,更新时校验版本号 - 重试机制:配置指数退避算法(如初始间隔100ms,最大重试次数5次)

- 冲突日志:将无法自动解决的冲突记录到ES中,供人工干预

- 时间窗口合并:对同一时间窗口内的更新进行合并处理

Q2:如何评估同步方案的可靠性指标?

A2:建议从三个维度进行量化评估:

- 数据完整性:每日执行CRC32校验,比对源/目标数据差异率应<0.01%

- 服务可用性:同步组件SLA应达到99.95%(年宕机时间<5小时)

- 延迟稳定性:通过滑动窗口算法计算P99延迟,波动范围应<±20%

可建立监控看板,包含以下关键指标:

- 同步成功率(成功记录数/总记录数)

- 端到端延迟(从COMMIT到目标库写入完成)

- 重试事件数(按错误类型分类统计)