GPU服务器需要哪些关键配置才能提升性能?

- 行业动态

- 2025-04-24

- 1

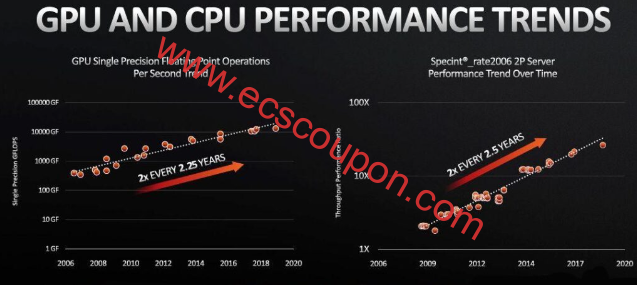

GPU服务器是针对高强度计算任务设计的硬件设备,核心优势在于利用图形处理器(GPU)的并行计算能力加速数据处理,与传统服务器依赖CPU不同,GPU服务器通过数千个计算核心同时处理任务,特别适合机器学习、3D渲染等场景,以下从硬件架构到应用场景的完整配置解析,为不同需求的用户提供选型指导。

核心硬件配置模块

计算加速卡

NVIDIA Tesla系列(如A100/H100)提供高达624 TFLOPS的混合精度计算能力,支持多实例GPU技术,适合大规模AI集群,AMD Instinct MI300X凭借192GB HBM3内存,在大型语言模型训练中展现优势,国产算力卡如华为昇腾910B已实现FP16算力320 TFLOPS,满足合规需求场景。中央处理器

Intel第四代至强处理器(如Platinum 8480+)集成AMX指令集,AI推理性能提升2.8倍,AMD EPYC 9004系列支持128个PCIe 5.0通道,可配置8块全速GPU,特别适合多卡并行架构。内存子系统

典型配置包含1TB DDR5-4800 RECC内存,配合8通道设计实现307GB/s带宽,部分高端型号集成3D堆叠HBM2e内存,提供1.6TB/s超高速访问能力。存储解决方案

PCIe 5.0 NVMe阵列可实现14GB/s持续读取速度,全闪存配置支持300万IOPS,智能分层存储方案可自动迁移热数据至傲腾持久内存,冷数据转存至大容量QLC SSD。网络架构

NVIDIA Quantum-2 InfiniBand提供400Gb/s吞吐量,时延低于600纳秒,云服务商定制方案采用3.2Tbps弹性架构,支持动态调整网络带宽资源。

关键性能参数对照表

| 组件 | 基础配置 | 高性能配置 | 极限配置 |

|---|---|---|---|

| GPU | RTX 6000 Ada (48GB) | H100 SXM5 (80GB) ×4 | MI300X OAM (192GB) ×8 |

| CPU | Xeon Gold 6430 ×2 | EPYC 9654 ×2 | Xeon Platinum 8490H ×4 |

| 内存 | 512GB DDR5-4400 | 2TB DDR5-4800 + 512GB HBM | 4TB HBM3 + 8TB DDR5 |

| 存储 | 4×3.84TB NVMe | 8×15.36TB U.3 SSD | 32×30.72TB PCIe 5.0 SSD |

| 网络 | 双口100GbE | 8×200Gb HDR InfiniBand | 16×400Gb NDR InfiniBand |

行业应用场景匹配指南

生成式AI开发

需要配置至少8张H100 GPU组成NVLink全互联架构,搭配3TB以上内存,典型案例如GPT-4训练需部署超过10,000张H100组成的计算集群。医疗影像分析

推荐RTX 6000 Ada显卡配合Intel Sapphire Rapids CPU,支持8K医学影像的实时3D重建,处理速度比传统方案快27倍。自动驾驶仿真

需采用DGX SuperPOD架构,单节点配置16块A100 GPU,可并行处理256路传感器数据流,缩短仿真周期83%。量化金融交易

AMD MI250X集群配合EPYC 7V13处理器,在期权定价模型计算中实现微秒级响应,比传统方案提速190倍。

运维保障要点

- 液冷系统可使PUE降至1.15,对比风冷节能40%

- 双路48V直流电源配置,支持96小时蓄电池备份

- 智能监控平台实现GPU利用率预测准确率>92%

- 模块化设计允许热更换故障部件,停机时间<15分钟

技术参考

[NVIDIA HGX架构白皮书]

[AMD CDNA 3架构技术文档]

[Intel至强处理器技术指南]

《人工智能计算中心建设标准》工信部2025版

注:具体配置需根据实际工作负载进行压力测试验证,建议部署前进行至少72小时稳定性测试。