GPU运算服务器如何高效提升计算性能?

- 行业动态

- 2025-05-05

- 1

GPU运算服务器通过搭载高性能显卡加速计算任务,主要用于深度学习、科学模拟等场景,使用时需安装GPU驱动及CUDA工具包,配置深度学习框架(如TensorFlow、PyTorch),调用算法模型进行训练或推理,并可通过分布式计算提升效率,同时监控资源状态确保稳定运行。

什么是GPU运算服务器?

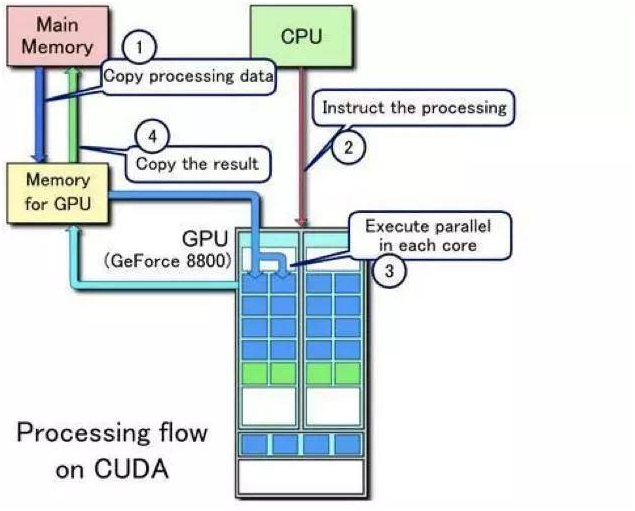

GPU运算服务器是配备图形处理器(GPU)的高性能计算设备,专为处理复杂并行计算任务设计,与传统CPU不同,GPU拥有上千个计算核心,可同时执行大量运算,适用于人工智能训练、深度学习、科学模拟、图像渲染等需要高算力的场景。

GPU运算服务器的核心应用场景

人工智能与深度学习

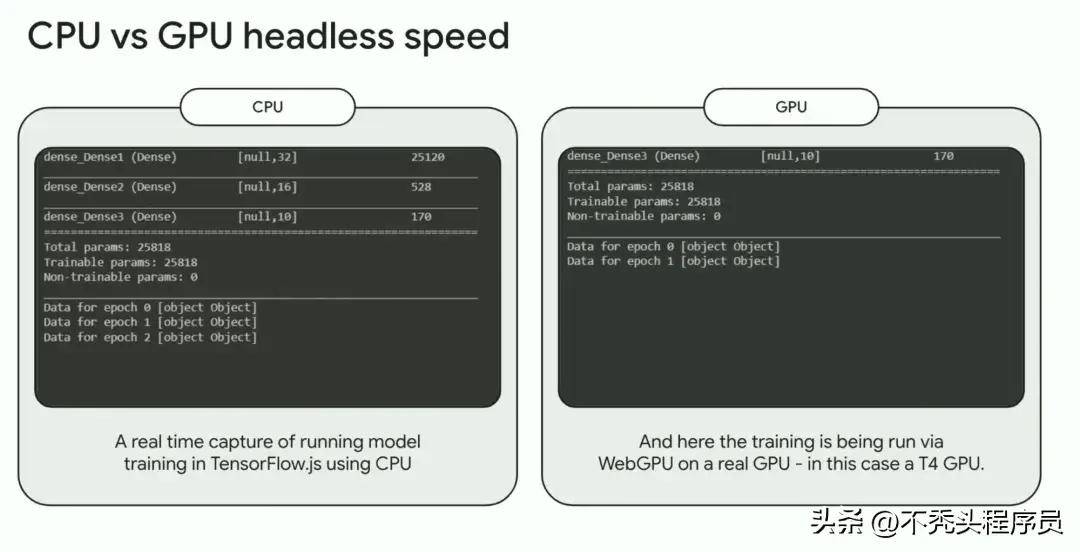

- 训练大规模神经网络(如自然语言处理、图像识别)时,GPU可加速矩阵运算,缩短训练时间,使用NVIDIA的A100 Tensor Core GPU可将训练效率提升数十倍。

- 常用框架:TensorFlow、PyTorch、Keras等均支持GPU加速。

科学计算与工程模拟

- 在气象预测、流体力学、量子化学等领域,GPU服务器可快速完成高精度数值模拟。

- 工具支持:CUDA、OpenCL、MATLAB并行计算工具箱。

图形渲染与媒体处理

影视特效、3D建模、视频编码等任务依赖GPU的实时渲染能力,如使用Blender或Adobe Premiere Pro的GPU加速功能。

区块链与密码学

GPU并行计算特性适用于加密货币挖矿(如以太坊)、哈希运算等场景。

如何使用GPU运算服务器?

以下是详细的操作步骤指南:

步骤1:选择适合的硬件与云服务

- 自建服务器:需采购GPU卡(如NVIDIA Tesla系列、AMD Instinct系列),配置高带宽内存、兼容主板及散热系统。

- 云服务器:主流云平台(阿里云、AWS、酷盾)提供按需租用的GPU实例(如NVIDIA V100/T4),适合灵活部署。

步骤2:安装驱动程序与开发环境

- 安装GPU厂商的驱动程序(如NVIDIA驱动),并配置CUDA Toolkit(版本需与框架兼容)。

- 通过Anaconda或Docker搭建Python环境,安装GPU加速库(cuDNN、NCCL)。

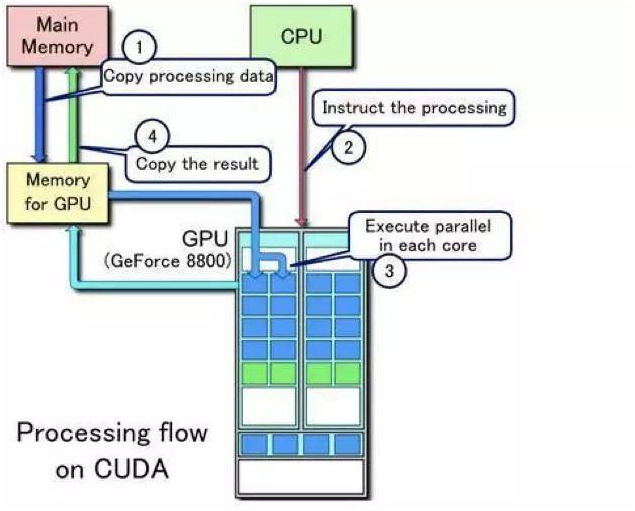

步骤3:编写或迁移代码至GPU

- 在代码中调用GPU加速接口:

import tensorflow as tf # 检查GPU是否可用 if tf.test.is_gpu_available(): with tf.device('/GPU:0'): # 在此处定义模型或运算 - 使用并行计算框架(如OpenMP、MPI)优化多GPU任务分配。

步骤4:监控与调优性能

- 利用

nvidia-smi命令实时监控GPU利用率、显存占用和温度。 - 优化方法:

- 减少CPU与GPU之间的数据传输(使用内存映射或共享内存)。

- 调整批量大小(batch size)以平衡显存占用与计算效率。

步骤5:部署与扩展

- 使用Kubernetes或Slurm集群管理工具实现多节点GPU任务的自动化调度。

- 在云平台中启用自动扩缩容功能,应对突发计算需求。

使用GPU服务器的注意事项

- 成本控制

自建服务器需考虑电费、维护成本;云服务器建议按需选择竞价实例(Spot Instance)。

- 散热与稳定性

GPU高负载运行时温度可能超过80°C,需确保服务器机房具备强制散热系统。

- 软件兼容性

验证框架版本与CUDA驱动的匹配性,避免因依赖冲突导致运行失败。

常见问题解答

- Q:普通程序能否直接在GPU服务器上运行?

A:需对代码进行并行化改造,或调用支持GPU加速的库(如NumPy的CuPy替代库)。 - Q:如何选择显存容量?

A:训练大型模型(如GPT-3)需24GB以上显存;推理任务可选择8-16GB的中端显卡。

GPU运算服务器通过并行计算能力显著提升复杂任务的执行效率,广泛应用于AI、科研、工程等领域,用户可根据需求选择硬件方案,并掌握环境配置、代码优化及性能监控的关键技巧,最大化发挥GPU的算力价值。

引用说明

- NVIDIA CUDA文档:https://docs.nvidia.com/cuda/

- TensorFlow GPU支持指南:https://www.tensorflow.org/install/gpu

- AWS GPU实例类型:https://aws.amazon.com/ec2/instance-types/