上一篇

如何利用GPU云服务器加速CNN训练并优化成本?

- 行业动态

- 2025-04-29

- 1

GPU云服务器通过弹性计算资源与分布式训练加速CNN模型训练,显著降低本地硬件成本并提升效率,其高并行计算能力支持复杂网络结构和大规模数据处理,结合自动扩展与灵活配置,为深度学习任务提供高效稳定的训练环境,适用于图像识别等实时性要求高的场景。

在深度学习领域,卷积神经网络(CNN)已成为图像识别、医学检测、自动驾驶等场景的核心技术,训练高性能CNN模型需要强大的算力支持,而GPU云服务器凭借其弹性算力、灵活配置和成本优势,成为企业和研究者的首选解决方案,本文将系统解析GPU云服务器训练CNN的技术原理、部署策略和优化方案,帮助用户高效完成模型开发。

为什么选择GPU云服务器训练CNN?

CNN的计算特征与硬件需求

卷积神经网络包含大量并行矩阵运算(如卷积层、池化层),传统CPU受限于串行处理架构,难以高效处理,GPU拥有数千个计算核心(如NVIDIA A100含6912个CUDA核心),可实现万倍于CPU的并行计算能力,ImageNet数据集上的ResNet-50训练,GPU可将训练时间从数周缩短至数小时。

云服务器的核心优势

- 弹性扩展:按需选择Tesla V100/A100/H100等显卡,支持单机多卡或多节点集群

- 成本优化:按小时计费避免硬件闲置,竞价实例费用可低至按需价格的1/3

- 环境预配置:主流云平台(AWS/GCP/阿里云)提供预装PyTorch、TensorFlow的镜像

- 数据安全:支持VPC私有网络、加密存储与传输,符合HIPAA/GDPR合规要求

GPU云服务器选型指南

硬件参数对照表

| 指标 | 推荐配置 | 说明 |

|---|---|---|

| GPU型号 | NVIDIA A100/A40/RTX 4090 | FP32算力>20 TFLOPS,支持混合精度训练(FP16/BF16) |

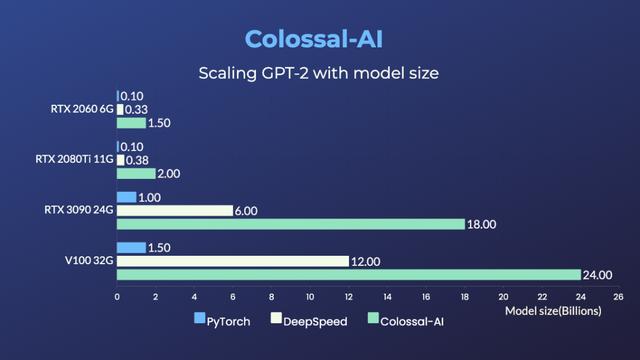

| 显存容量 | ≥24GB(如A100 80GB) | 满足大Batch Size需求(如医疗影像1024×1024分辨率需≥32GB) |

| GPU数量 | 4-8卡NVLink互联 | 多卡并行加速,通信带宽≥600GB/s |

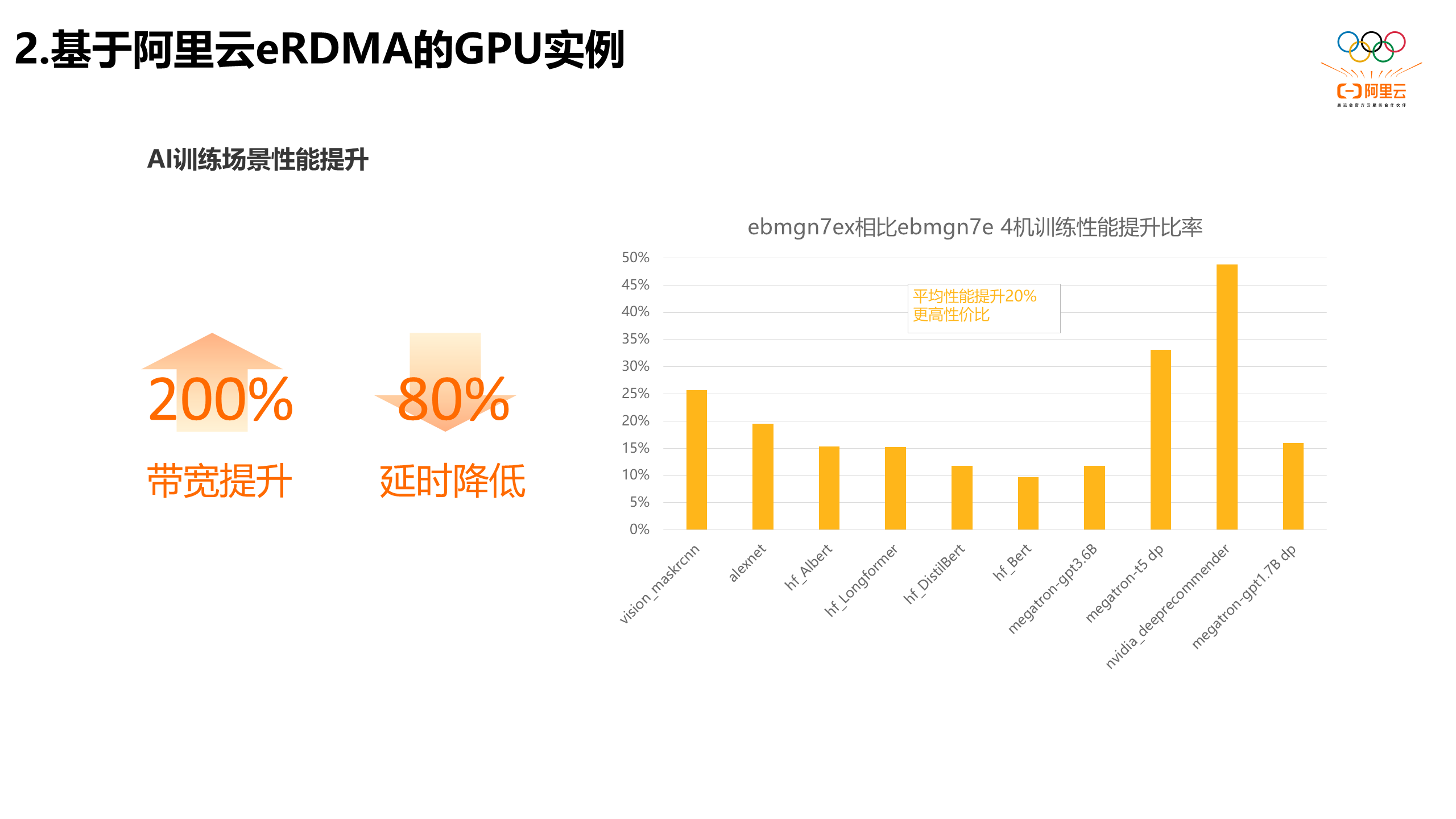

| 网络带宽 | ≥25Gbps RDMA | 减少分布式训练中的参数同步延迟 |

| 存储类型 | NVMe SSD + 对象存储 | 高速读写训练数据,对象存储用于长期归档 |

主流云平台对比

- 阿里云GN7系列:性价比之选,配备Tesla T4,适合中小规模模型

- AWS P4d实例:搭载8块A100,NVIDIA NVSwitch实现GPU直连

- 酷盾GN10X:支持H100芯片,TF32算力达1139 TFLOPS

CNN训练全流程实战

环境配置示例(以PyTorch为例)

# 检查GPU可用性

import torch

print(f"Available GPUs: {torch.cuda.device_count()}")

print(f"Current Device: {torch.cuda.get_device_name(0)}")

# 设置多卡并行

model = torch.nn.DataParallel(model, device_ids=[0,1,2,3])数据处理优化技巧

- 使用TFRecord/WebDataset格式:减少I/O瓶颈,提升数据加载速度

- 启用DALI库:NVIDIA数据加载加速库,可提升3倍预处理效率

- 内存映射技术:将大型数据集映射到虚拟内存,避免重复读取

分布式训练方案对比

| 方法 | 适用场景 | 通信效率 | 实现复杂度 |

|---|---|---|---|

| Data Parallel | 单机多卡 | 中等 | |

| Horovod | 跨节点多卡 | 高 | |

| PyTorch DDP | 大规模集群 | 高 |

性能调优关键技巧

- 混合精度训练:通过

torch.cuda.amp自动转换FP16/FP32,显存占用减少50%,速度提升2倍 - 梯度累积:在小显存设备上模拟大Batch Size(如累计4次梯度后更新参数)

- 算子融合:使用TVM/Apex库优化卷积+BN+ReLU的融合计算

- 监控工具链:

- DCGM:实时监测GPU利用率、显存占用

- PyTorch Profiler:分析计算图耗时分布

- TensorBoard:可视化损失曲线、参数分布

常见问题与解决方案

- 显存不足:启用梯度检查点(

torch.utils.checkpoint)、降低Batch Size - 数据瓶颈:使用多进程加载(

num_workers=4*cpu核心数)、预加载至内存 - 通信延迟:采用All-Reduce算法优化参数同步,启用NCCL后端

- 模型收敛慢:尝试SWA(随机权重平均)、学习率warmup策略

未来趋势与成本控制

- 异构计算架构:GPU+IPU(Graphcore)协同训练,能效比提升40%

- Serverless训练:按实际计算资源消耗付费(如AWS SageMaker)

- AutoML集成:使用NAS(神经网络架构搜索)自动生成高效CNN结构

- 绿色计算:选择碳足迹较低的云区域(如谷歌云碳中和区域)

引用来源

- NVIDIA CUDA编程指南 v12.1

- MLPerf Training Benchmark 2025结果报告

- AWS EC2实例类型官方文档

- PyTorch官方分布式训练教程

- 《Deep Learning with Python》 François Chollet著

通过合理选型与优化,GPU云服务器可让CNN训练效率提升10倍以上,建议在项目初期采用按需实例进行原型验证,进入生产阶段后切换至预留实例或专属主机降低成本。