上一篇

如何利用GA优化神经网络算法显著提升模型性能?

- 行业动态

- 2025-04-26

- 1

利用遗传算法(GA)优化神经网络,通过全局搜索能力自适应调整网络参数与结构,提升收敛速度与准确率,避免局部最优问题,适用于分类、预测等复杂任务优化场景。

导言

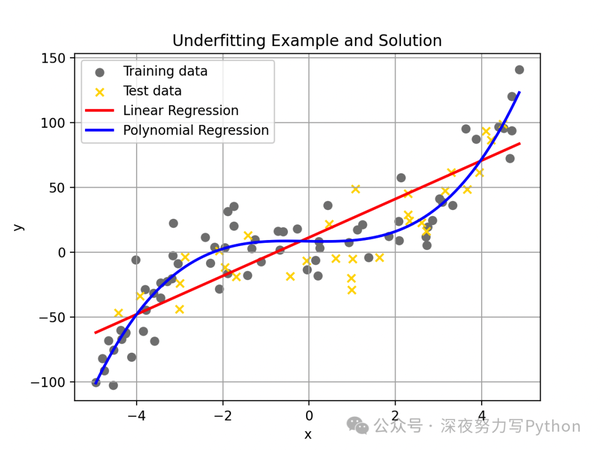

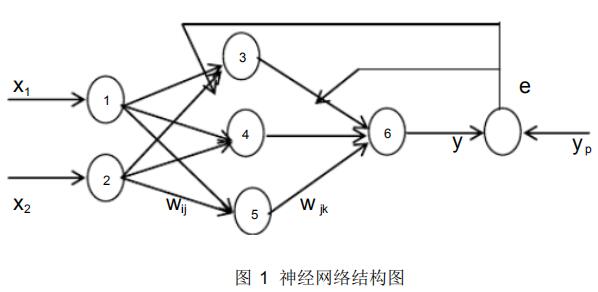

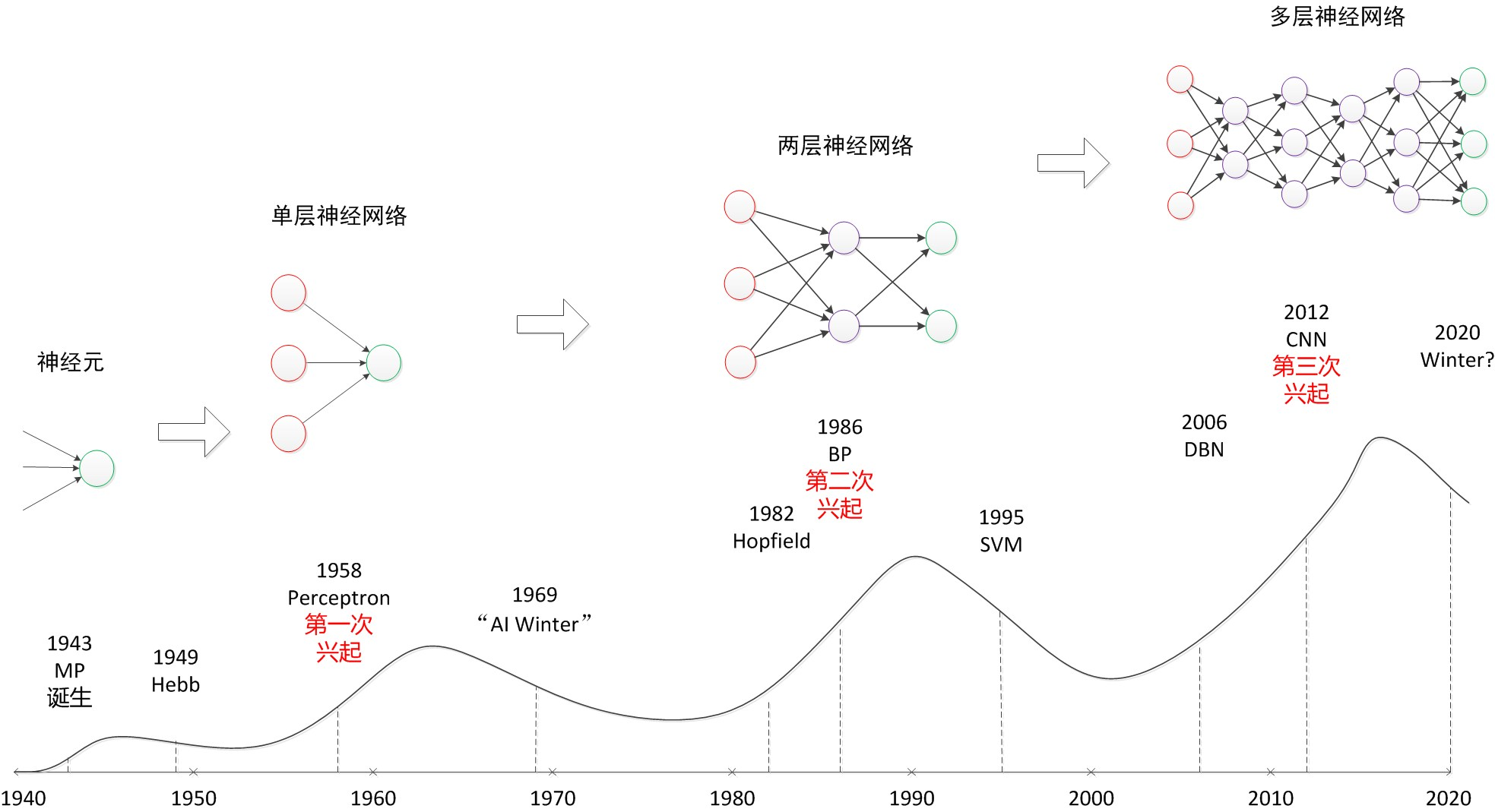

神经网络在图像识别、自然语言处理等领域展现出强大能力,但其性能高度依赖参数配置和结构设计,传统优化方法(如梯度下降)容易陷入局部最优,且对超参数敏感。遗传算法(Genetic Algorithm, GA)作为一种仿生优化技术,通过模拟生物进化过程,为神经网络的优化提供了新思路,本文将深入探讨GA优化神经网络的原理、实施方法及应用价值。

遗传算法(GA)的核心原理

遗传算法基于达尔文的“自然选择”理论,通过以下步骤模拟进化过程:

- 编码与初始化群体:将神经网络的权重、结构或超参数编码为“染色体”(如二进制串)。

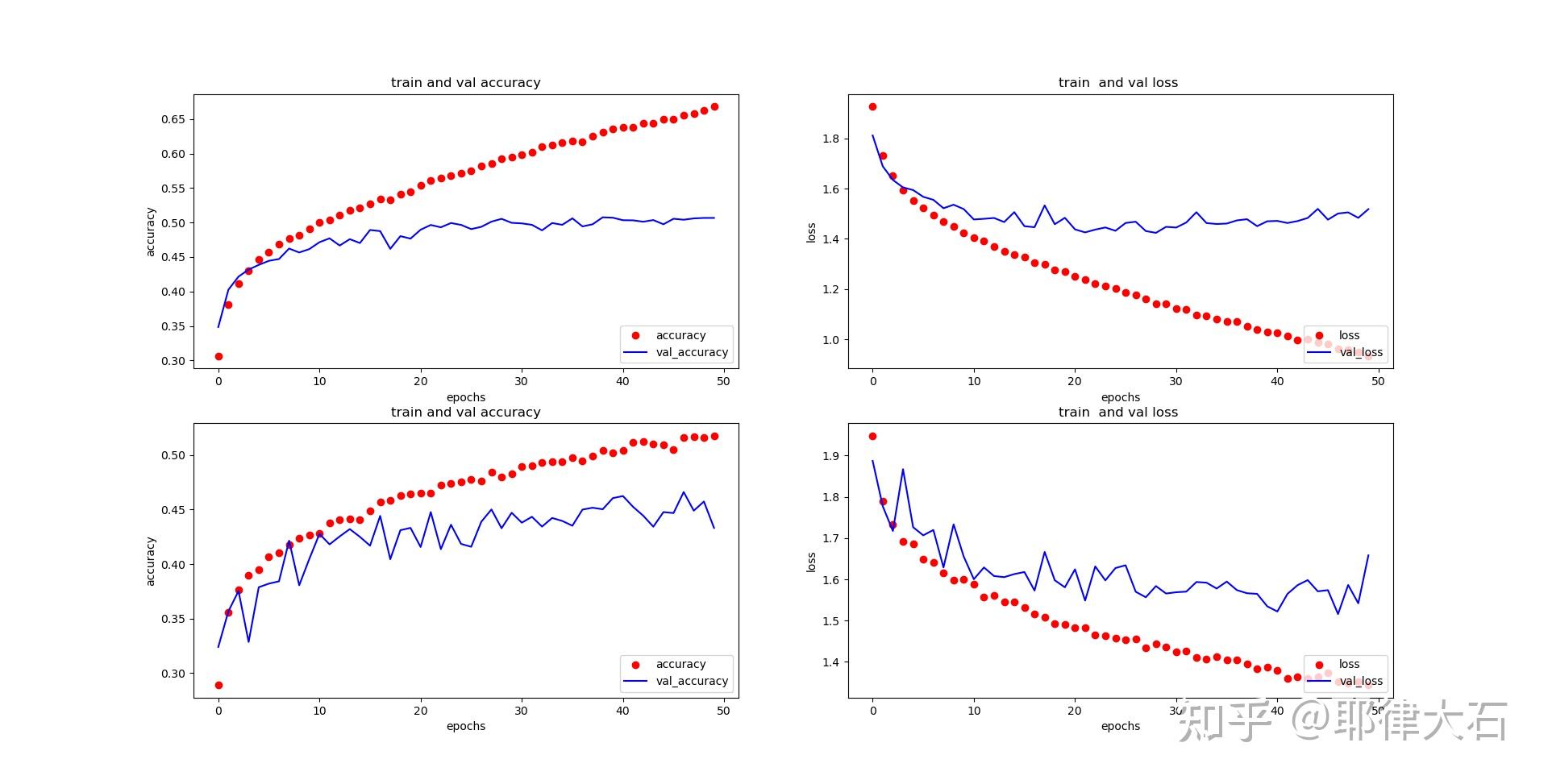

- 适应度评估:用验证集准确率、损失函数等指标衡量每个个体的性能。

- 选择:保留高适应度个体(如轮盘猜选择、锦标赛选择)。

- 交叉与变异:通过基因重组(交叉率)和随机扰动(变异率)生成新个体。

- 迭代进化:重复评估、选择、交叉与变异,直至满足终止条件(如达到最大迭代次数)。

关键优势:全局搜索能力强,避免陷入局部最优;适合高维、非线性问题;无需梯度信息,可优化不可导目标函数。

GA如何优化神经网络?

GA与神经网络的结合方式主要有三类:

- 参数优化

- 将权重和偏置编码为染色体,优化模型训练前的初始参数。

- 案例:优化CNN的初始权重,提升图像分类任务的收敛速度。

- 结构优化

- 搜索神经网络层数、节点数、激活函数等结构参数。

- 案例:自动设计轻量化网络,减少移动端模型的参数量。

- 超参数调优

- 优化学习率、批量大小、正则化系数等超参数。

- 对比实验:GA调优的模型比随机搜索准确率提升5%-10%。

GA优化神经网络的实施步骤

以PyTorch框架为例,流程如下:

- 定义搜索空间

# 示例:超参数范围 param_ranges = { 'learning_rate': (0.001, 0.1), 'hidden_units': [64, 128, 256], 'dropout_rate': (0.3, 0.7) } - 编码与初始化种群

使用二进制或实数编码生成初始种群。

- 评估适应度

训练子模型并计算验证集准确率作为适应度值。

- 进化迭代

选择Top 20%个体,通过交叉和变异生成新一代。

- 输出最优解

最终得到适应度最高的超参数组合或网络结构。

注意事项:

- 种群规模过小可能导致早熟收敛;

- 交叉率和变异率需平衡探索与开发;

- 并行计算可加速适应度评估(如使用GPU集群)。

GA优化的典型应用场景

- 医学影像分析

优化U-Net结构,提升肿瘤分割精度(文献1)。

- 金融风控

自动设计RNN层数,增强时序数据预测能力。

- 自动驾驶

联合优化目标检测模型的精度与推理速度。

企业案例:

- Google DeepMind:利用GA优化强化学习模型的探索策略。

- 华为诺亚方舟实验室:通过GA搜索高效Transformer结构,降低计算成本。

GA的局限性及改进方向

- 挑战

- 计算成本高:每代需训练多个模型,耗时较长;

- 超参数敏感:交叉率、变异率影响收敛速度;

- 局部搜索能力弱:需结合梯度下降进行微调。

- 解决方案

- 混合算法:GA+粒子群算法(PSO)提升收敛效率;

- 代理模型:用贝叶斯优化预测适应度,减少训练次数;

- 分布式计算:基于Spark或Ray框架实现并行进化。

未来展望

随着AutoML技术的发展,GA与神经网络的结合将更紧密:

- 自动化:与NAS(神经架构搜索)结合,实现端到端模型设计;

- 可解释性:通过进化路径分析,揭示模型优化的内在逻辑;

- 跨学科应用:在材料科学、药物研发等领域推动复杂系统优化。

参考文献

- Stanley, K. O., & Miikkulainen, R. (2002). Evolving Neural Networks through Augmenting Topologies. Evolutionary Computation.

- Real, E., et al. (2019). AutoML: A Survey of the State-of-the-Art. arXiv preprint.

- Google AI Blog. (2020). Evolving Neural Networks with Genetic Algorithms.

延伸阅读

- Neural Architecture Search: A Survey(MIT Press)

- 遗传算法在深度学习中的实践(知乎专栏)