上一篇

多条数据怎么保存到数据库

- 数据库

- 2025-08-26

- 21

条数据保存到数据库可采用批量插入、数据导入工具或编写脚本实现高效操作

准备工作

- 明确目标结构

- 确认数据库表的结构(字段类型、约束条件),例如主键是否自增、是否有唯一性索引等。

- 如果涉及复杂关联关系(如外键),需提前规划插入顺序以避免依赖冲突。

- 选择适配的工具/库

根据使用的编程语言和技术栈选择合适的API:- Python常用

SQLAlchemy或原生psycopg2(PostgreSQL)、pymysql(MySQL); - Java可基于JDBC批量执行;Node.js则通过

knex或Sequelize封装操作; - 直接编写SQL时利用特定语法优化性能(如MySQL的

INSERT INTO ... VALUES (...), (...), ...)。

- Python常用

- 预处理待存数据

- 清洗无效值:过滤空字符串、非规格式等内容;

- 类型转换:将字符串转为日期型、数字型等符合字段定义的类型;

- 去重逻辑:若允许部分重复但需规避全表冗余,可在内存中先做初步筛选。

核心实现方式对比

| 方法 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 单条逐次插入 | 简单直观,错误定位容易 | 效率极低(网络开销大) | 调试阶段或小批量测试 |

| 批量单次提交 | 显著减少I/O次数,速度快 | 需自行拼接SQL语句 | 中等规模且结构固定的数据 |

| 事务包裹批量操作 | 原子性强,失败回滚保障一致性 | 内存占用较高 | 关键业务的关键批次写入 |

| 存储过程调用 | 服务器端执行效率高 | 跨语言兼容性差 | 复杂计算后的批量更新需求 |

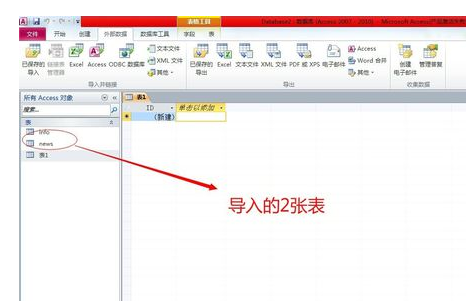

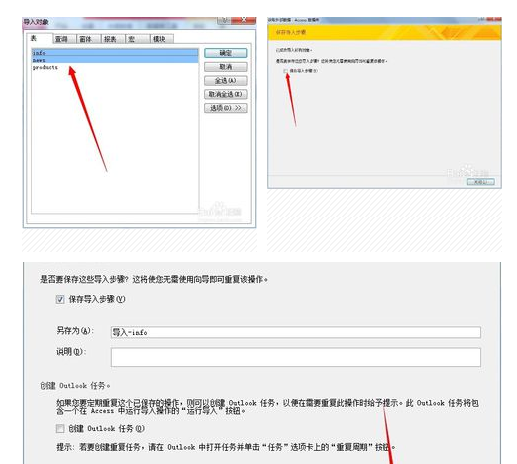

| 第三方工具加载 | 无需编码,图形化界面友好 | 灵活性不足 | Excel/CSV文件快速导入 |

推荐方案:事务内的批量插入

以Python+MySQL为例演示代码框架:

import pymysql

from contextlib import contextmanager

@contextmanager

def db_session():

conn = pymysql.connect(host='localhost', user='root', password='xxx', db='test')

try:

yield conn

conn.commit()

except Exception as e:

conn.rollback()

raise e

finally:

conn.close()

# 构造批量插入语句模板

def build_batch_sql(table_name, columns):

placeholders = ['%s'] len(columns)

return f"INSERT INTO {table_name} ({','.join(columns)}) VALUES ({','.join(placeholders)});"

with db_session() as cur:

cursor = cur.cursor()

records = [

('Alice', 25, 'Female'),

('Bob', 30, 'Male'),

# ...更多记录...

]

sql = build_batch_sql('users', ['name', 'age', 'gender'])

cursor.executemany(sql, records)

️ 注意点:不同数据库占位符可能差异较大(如SQLite用问号?),务必查阅对应文档;对于超长列表建议分块处理(每批500~1000条),防止单次请求过大超时。

高级优化策略

- 禁用索引临时加速

在导入前删除目标表的非必要索引,完成后重建,适用于首次大规模初始化场景,示例(MySQL):ALTER TABLE target_table DISABLE KEYS; -导入期间关闭索引维护 -[执行批量插入] ALTER TABLE target_table ENABLE KEYS; -恢复并重新生成索引

- 异步写入与队列削峰

采用消息队列(RabbitMQ/Kafka)缓冲突发流量,消费者后端服务按节奏消费并入库,避免瞬时压力击垮数据库连接池,特别适合电商大促时的订单洪峰场景。 - 并发控制机制

通过线程池实现多路并行插入,但需注意:

- 同一连接不可并发使用;

- InnoDB存储引擎下默认行级锁可能导致死锁风险增加;

- 可通过分片键将数据哈希到不同分区表分散压力。

- 错误处理精细化

不要简单忽略异常,应记录失败项的位置并补偿重试,例如捕获主键冲突后跳过该条继续执行后续操作:try: cursor.executemany(...) except pymysql.IntegrityError as e: log.error(f"Duplicate entry at position {e.args[1]}") continue_from_failure_point()

典型工具链集成示例

| 来源类型 | 推荐工具 | 工作流程说明 |

|---|---|---|

| Excel/CSV | Pandas + SQLAlchemy | Pandas读取文件→DataFrame清洗→to_sql()批量写入 |

| API响应体JSON数组 | FastAPI流式解析 | Request Body直接反序列化为ORM对象列表→session.add_all() |

| Web表单多选文件上传 | Django Formset组件 | FormSet验证多份表单数据→bulk_create()批量创建模型实例 |

| 物联网传感器流数据 | TimescaleDB时序扩展 | UDP接收二进制包→解码为度量指标→按时间窗口聚合存储 |

常见陷阱规避指南

- 误区1:盲目追求速度而忽视事务边界 → 导致部分成功部分失败的状态被墙数据库;

- 误区2:未限制单次批量大小 → 可能触发数据库的最大允许参数限制(如MySQL默认max_allowed_packet=64MB);

- 误区3:忽略字符集编码问题 → Emoji表情符号存入VARCHAR可能出现乱码;

- 误区4:过度依赖ORM自动映射 → 特殊类型(几何图形、JSONB)需手动干预序列化过程。

FAQs

Q1: 如果中途发生网络中断怎么办?如何保证已传输的部分不被丢失?

A: 采用带确认机制的断点续传方案:①每次成功写入后记录检查点(checkpoint);②重启时从最后一个成功位置继续传输;③结合Redis缓存未完成的批次数据作为兜底措施,例如FTP协议本身的REST命令即可实现类似功能。

Q2: 当存在外键约束时,应该先插入父表还是子表?如何处理级联删除?

A: 必须遵循引用完整性规则——先插入父表记录获取其ID,再以此作为外键值插入子表,对于级联删除操作,应在数据库层面设置ON DELETE CASCADE规则,并在应用层提供软删除标记替代物理删除以