上一篇

怎么截取数据库里的数据库

- 数据库

- 2025-08-25

- 22

SQL语句中的

SELECT命令配合

WHERE子句或LIMIT等参数,可精准截取数据库中的指定数据

明确需求与准备工作

-

确定目标字段和条件

- 先梳理需要提取的具体列(如用户ID、订单金额)、过滤条件(时间范围、状态标识)及排序规则。“获取2023年活跃用户的姓名与消费总额”。

- 若涉及多表关联,需提前设计JOIN逻辑(如通过外键连接订单表与商品分类表)。

-

权限验证

确保当前账户具备SELECT权限,可通过执行SHOW GRANTS FOR current_user;(MySQL)或查询系统视图(如PostgreSQL的pg_roles)确认权限范围,无权限时需联系DBA授权。 -

备份原始数据(可选但推荐)

对生产环境操作前,建议创建临时副本表:CREATE TABLE temp_backup AS SELECT FROM original_table;

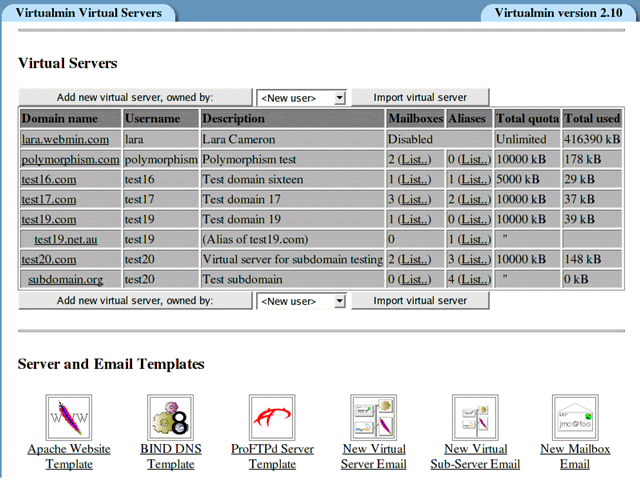

主流数据库的实现方法对比

| 数据库类型 | SQL语法示例 | 图形化工具路径 |

|---|---|---|

| MySQL/MariaDB | SELECT col1, col2 FROM table WHERE condition ORDER BY sort_field LIMIT n; |

Navicat → 右键表名→“导出数据” |

| PostgreSQL | COPY (SELECT ...) TO '/path/file.csv' DELIMITER ','; |

DBeaver → 结果集→“导出到文件” |

| SQL Server | BULK INSERT target_table FROM 'C:data.txt' WITH (FIELDTERMINATOR=','); |

SSMS → 任务→导入/导出向导 |

| Oracle | SPOOL output.csv; SET COLSEP ','; SELECT ...; SPOOL OFF; |

SQLPlus命令行+第三方插件支持 |

| MongoDB | db.collection.find({filter}, {projection}).toArray(); |

Compass界面→筛选器设置→下载JSON |

进阶技巧:分页与性能优化

- 大数据集处理:使用

OFFSET+FETCH NEXT分批次读取(如SQL Server的OFFSET 1000 ROWS FETCH NEXT 500 ROWS ONLY),避免内存溢出。 - 索引利用:确保WHERE子句中的字段已建立索引,可显著提升查询速度,例如为

create_time添加索引后,WHERE create_time > '2023-01-01'效率更高。 - 游标慎用:仅在无法避免逐行处理时使用游标,因其会降低并发性能。

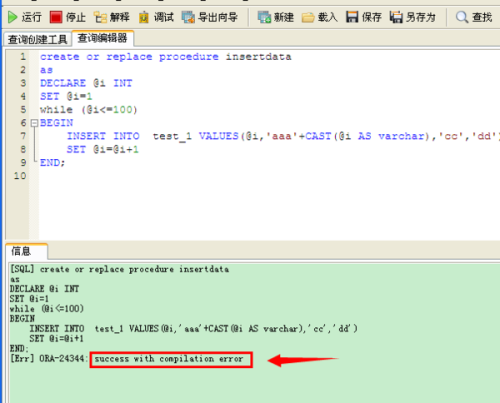

常见错误及解决方案

| 问题现象 | 根本原因 | 修复方案 |

|---|---|---|

| “Access denied”报错 | 用户缺乏读权限 | 执行GRANT SELECT ON db. TO user; FLUSH PRIVILEGES; |

| 中文乱码 | 字符集不匹配 | 统一设置为UTF8:SET NAMES utf8mb4;(MySQL) |

| 导出文件过大导致崩溃 | 单次提取量超限 | 拆分为多个小批次,或启用压缩格式(如GZIP) |

| 日期格式解析异常 | 区域设置差异 | 显式转换格式:DATE_FORMAT(datecol, '%Y-%m-%d') |

实战案例演示

假设有一个电商系统的订单表orders结构如下:

+------------+--------------+---------+----------+ | order_id | user_id | amount | status | +------------+--------------+---------+----------+ | ODR_001 | U1001 | 299.50 | completed| | ODR_002 | U1002 | 150.00 | cancelled| ...共10万条记录

场景1:提取近7天的有效订单明细

SELECT order_id, user_id, amount, status, order_time FROM orders WHERE status = 'completed' AND order_time >= NOW() INTERVAL 7 DAY ORDER BY amount DESC;

关键点:用索引加速status和order_time的双重过滤。

场景2:跨库迁移至新实例

- 源端导出CSV:

mysqldump -t -T /tmp/ --fields-terminated-by=',' orders --where="status='active'"

- 目标端导入:

LOAD DATA INFILE '/tmp/orders.csv' INTO TABLE new_orders FIELDS TERMINATED BY ',';

️注意:需保持两端表结构的一致性,尤其是主键约束。

安全合规性考量

- 脱敏处理敏感信息

对身份证号、手机号等隐私字段进行掩码替换:SELECT REPLACE(phone, SUBSTRING(phone, 4, 4), '') AS masked_phone FROM users;

- 审计日志留存

记录每次数据导出的操作人、IP地址、执行时间等信息到专用审计表。 - 最小权限原则

限制应用账户仅能访问必要表,禁止使用SELECT通配符。

FAQs

Q1: 如果遇到“锁表”导致其他事务阻塞怎么办?

A: 采用低优先级会话执行长时间查询:在MySQL中添加LOW_PRIORITY修饰符;或改用READ COMMITTED隔离级别减少等待时间,更优方案是将分析类操作放在业务低谷期执行。

Q2: 如何验证导出数据的完整性?

A: 通过以下方式交叉校验:①对比源表与目标表的总行数(SELECT COUNT() FROM table;);②抽样检查哈希值(如MD5SUM);③使用CHECKSUM表级约束,对于关键业务