消息记录怎么存放在数据库

- 数据库

- 2025-08-24

- 19

数据库类型选择

根据业务规模和性能需求,主流方案包括关系型数据库(如MySQL/PostgreSQL)或NoSQL(如MongoDB),两者各有优劣:

| 特性 | 关系型数据库 | NoSQL(文档型) |

|——————|——————————–|——————————-|

| 结构化程度 | 强Schema约束 | 灵活半结构化 |

| ACID事务支持 | | ️部分牺牲一致性换性能 |

| 查询复杂度 | SQL复杂联表操作 | JSON路径/聚合管道 |

| 适用场景 | 需严格事务保障的场景 | 高并发写入、动态字段扩展 |

即时通讯类应用因消息体含富文本、图片链接等非固定字段,常选用MongoDB;而金融系统则倾向PostgreSQL以确保数据完整性。

核心表结构设计

以关系型数据库为例,典型设计如下:

主表 messages

| 字段名 | 类型 | 注释 | 约束条件 |

|---|---|---|---|

id |

BIGINT(20) | 自增主键 | PRIMARY KEY, AUTO_INCREMENT |

conversation_id |

VARCHAR(64) | 会话唯一标识(如用户A+用户B哈希值) | NOT NULL |

sender_uid |

INT | 发送方用户ID | FOREIGN KEY→users.id |

receiver_uid |

INT | 接收方用户ID | FOREIGN KEY→users.id |

content |

LONGTEXT/TEXT | (支持HTML/Markdown) | 默认字符集UTF8mb4 |

status |

ENUM(‘sent’,’delivered’,’read’) | 状态枚举值 | DEFAULT ‘sent’ |

created_at |

TIMESTAMP(3) | 精确到毫秒的时间戳 | DEFAULT CURRENT_TIMESTAMP() |

updated_at |

TIMESTAMP(3) | 最后更新时间 | ON UPDATE CURRENT_TIMESTAMP |

辅助索引表

为加速高频查询,需创建复合索引:

-按会话ID倒序排列最新消息 CREATE INDEX idx_conversation ON messages (conversation_id DESC); -针对发送者的历史消息检索 CREATE INDEX idx_sender ON messages (sender_uid, created_at DESC); -状态过滤专用索引 CREATE INDEX idx_status ON messages (status);

注意:避免过度索引导致写性能下降,建议通过

EXPLAIN分析执行计划后调整。

大数据量下的分库分表策略

当单表数据超过500万条时,可采用以下架构:

-

水平拆分(Sharding)

- 规则示例:按

conversation_id % N取模路由至不同物理库,N通常取节点数倍数(如8个节点则N=8)。 - 优势:突破单节点存储限制,降低单机IO压力。

- 挑战:跨分片查询需中间件代理(如MyCat),可能引入额外延迟。

- 规则示例:按

-

冷热分离

- 将最近30天活跃的对话存入SSD高速集群,历史冷数据迁移至HDD或对象存储(如S3),配合元数据库记录位置映射关系。

- 实现工具:使用Apache Camel定时任务完成异步迁移。

-

分区表机制

在MySQL中使用RANGE分区按月份自动归档旧数据:ALTER TABLE messages PARTITION BY RANGE (TO_DAYS(created_at)) ( PARTITION p202401 VALUES LESS THAN (TO_DAYS('2024-02-01')), PARTITION p202402 VALUES LESS THAN (TO_DAYS('2024-03-01')),... );

关键性能优化技巧

批量写入替代逐条插入

- 错误做法:每收到一条消息执行一次

INSERT,造成大量网络往返开销。 - 正确方案:累积到一定阈值(如500条)后调用

INSERT INTO ... VALUES (...),...批量提交,吞吐量提升可达10倍以上。 - 代码片段(Java):

public void batchSave(List<Message> batch) { StringBuilder sql = new StringBuilder("INSERT INTO messages VALUES "); for (Message m : batch) { sql.append("(?,?,?),"); // 参数化占位符 } // 删除末尾逗号并执行预编译语句 }

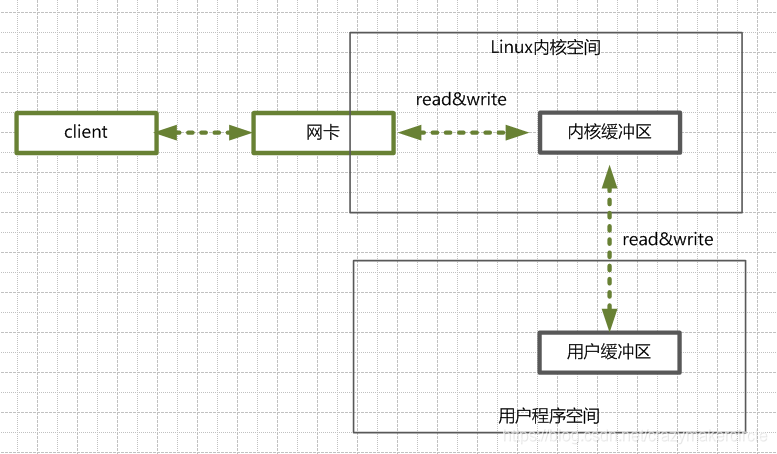

缓存层设计

- Redis缓存策略:对热点会话的最新100条消息进行缓存,设置TTL=60秒,减少数据库读压力。

- 缓存击穿防护:采用互斥锁机制防止雪崩效应,伪代码如下:

def get_cached_messages(conv_id): if not redis.exists(f"msg:{conv_id}"): lock = acquire_lock(f"lock:{conv_id}") try: data = db.query("SELECT FROM messages WHERE conversation_id=?", conv_id) redis.setex(f"msg:{conv_id}", ttl=60, value=data) finally: release_lock(lock) return redis.get(f"msg:{conv_id}")

异步日志削峰填谷

引入Kafka消息队列作为缓冲池,生产者端快速写入Topic,消费者后端服务按需消费并持久化到数据库,此模式可将峰值QPS从10万降至平稳的2万以内。

安全性与合规性措施

-

敏感信息脱敏

- 对电话号码、身份证号等字段启用透明加密算法(AES-GCM),密钥由KMS统一管理。

- SQL示例:

UPDATE users SET mobile = AES_ENCRYPT(mobile, 'secret_key') WHERE role='client';

-

审计追踪机制

单独建立audit_log表记录所有增删改操作,包含操作人IP、客户端指纹等信息:CREATE TABLE audit_log ( log_id BIGINT PRIMARY KEY AUTO_INCREMENT, action_type ENUM('CREATE','UPDATE','DELETE'), table_name VARCHAR(50), -e.g., 'messages' record_id BIGINT, -affected row ID operator_uid INT, -who did this change? old_values JSON, -before image new_values JSON, -after image occurred_at TIMESTAMP -when happened ); -

GDPR合规删除

实现软删除标记而非物理删除,保留90天宽限期供用户后悔恢复;彻底删除时需同步清理关联表外键约束。

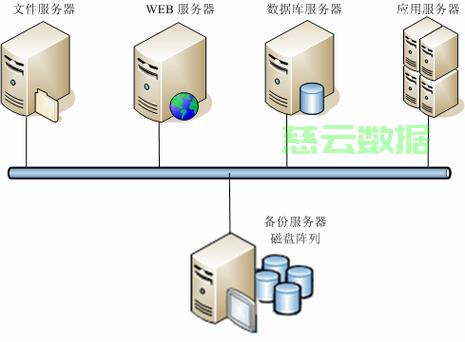

容灾备份方案对比

| 方案 | RPO目标 | RTO目标 | 成本效益比 | 适用场景 |

|---|---|---|---|---|

| 每日全量备份+增量日志 | <1小时 | <4小时 | 中小型企业 | |

| Binlog实时复制到灾备库 | <5分钟 | <30分钟 | 关键业务系统 | |

| CDP连续数据保护 | <1分钟 | <15分钟 | 金融级高可用要求 |

推荐组合使用Binlog+定期快照,兼顾效率与恢复粒度。

FAQs

Q1: 如果遇到消息乱序怎么办?

A: 确保数据库连接设置为可重复读隔离级别(REPEATABLE READ),并在应用层为每条消息添加递增序列号字段,查询时按sequence_num排序即可保证展示顺序正确。

SELECT FROM messages WHERE conversation_id='abc123' ORDER BY sequence_num ASC;

Q2: 如何高效统计某用户的未读消息数?

A: 维护一个计数器缓存表unread_counters,每当产生新消息时原子更新对应用户的未读总数;用户主动查阅后重置该值,SQL实现如下:

-新增消息时触发更新 UPDATE unread_counters SET count = count + 1 WHERE user_id = ?; -用户查看后清零 UPDATE unread_counters SET count = 0 WHERE user_id = ?;