数据容错 怎么导入数据库

- 数据库

- 2025-08-20

- 18

待导入数据按规范整理成文件,设置好字段映射与校验规则;再借助数据库管理工具或编程接口,开启事务处理后批量导入并捕获异常,完成容错式数据入库。

是关于如何在保证数据容错的前提下将数据导入数据库的详细说明,涵盖多种方法和注意事项:

基础概念与准备

- 数据容错的核心目标:在导入过程中允许部分错误存在而不中断整体流程,同时记录异常以便后续修正,通过设置最大允许错误行数阈值或跳过无效字段来实现,这种机制尤其适用于海量数据处理场景,避免因个别脏数据导致整个任务失败。

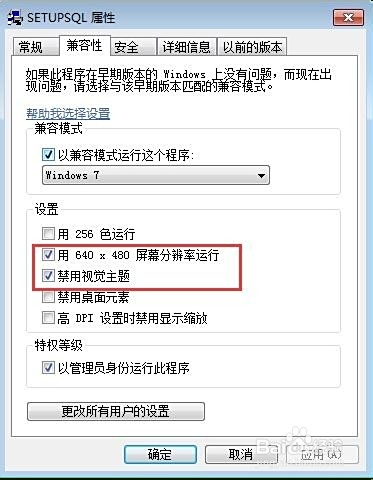

- 预处理关键环节:需先对原始文件进行格式标准化(如统一编码为UTF-8)、去除空白行、验证字段类型匹配度等,若源数据包含混合编码(如同时存在GBK和UTF8),建议拆分为独立批次分别处理。

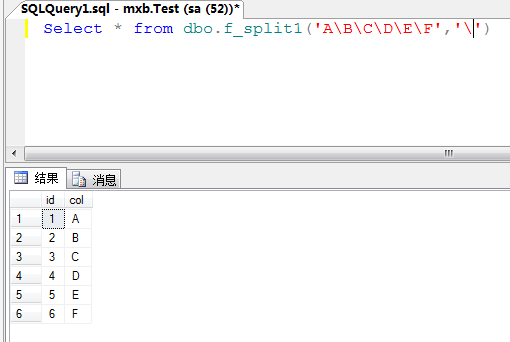

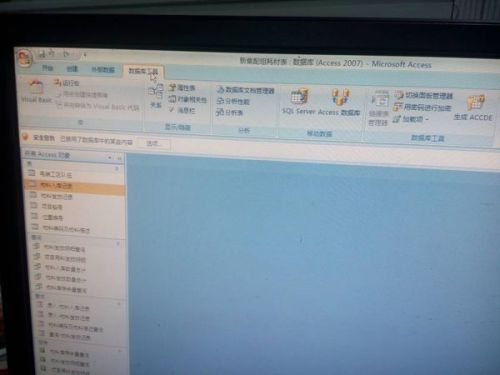

主流实现方案对比

| 工具/命令 | 适用场景 | 容错特性配置要点 | 优势 |

|---|---|---|---|

mysql命令行工具 |

结构化SQL文件导入 | 使用--force参数强制继续执行;结合IGNORE INTO语法忽略非规记录 |

原生支持事务回滚,适合精确控制 |

| DBeaver图形化界面 | 多数据库类型兼容操作 | 在导入向导中勾选“Skip Errors”选项并设置错误日志路径 | 可视化调试方便,支持断点续传 |

PostgreSQL的COPY命令 |

高效批量加载平面文本数据 | 添加WITH (COMPATIBLE_ILLEGAL_CHARS)子句处理特殊字符;配合LOG_MINOR_MESSAGES记录警告信息 |

直接操作物理存储层,性能损耗极低 |

| 自定义脚本解析 | 复杂业务逻辑适配 | 编写正则表达式过滤异常值;采用Try-Catch结构捕获解析异常并写入备用表 | 灵活度高,可嵌入动态补偿算法 |

分步实施指南

Step 1:建立错误隔离机制

创建专用于暂存可疑记录的过渡表(如temp_error_records),包含原始内容、错误类型戳记和时间戳三列,当主表插入失败时触发触发器自动归档异常数据,确保主流程不受阻塞。

Step 2:配置渐进式加载策略

对于超大规模数据集,推荐采用分层导入模式:首次全量尝试→提取失败清单→人工干预修复→二次增量补录,此方法可将资源消耗降低,且每次迭代都能明确缩减待处理范围。

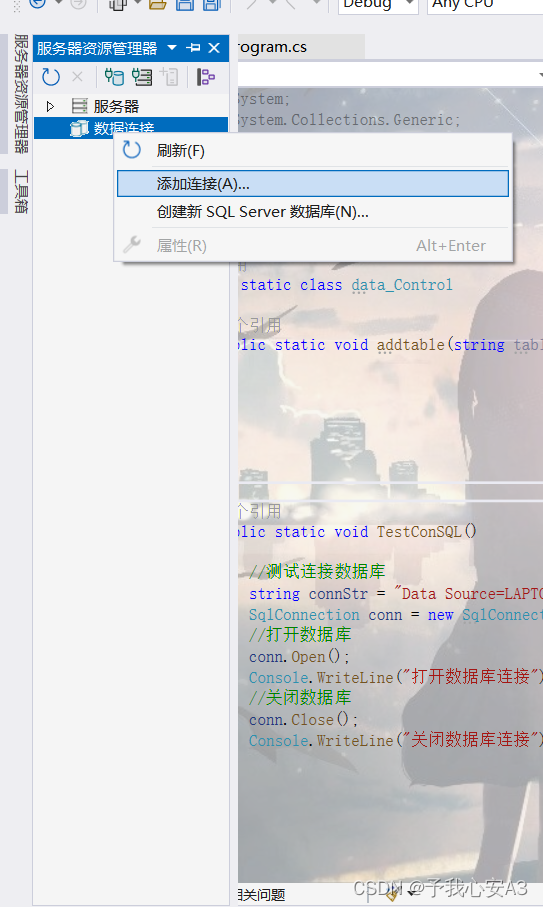

Step 3:编码兼容性处理

跨平台迁移时特别注意字符集转换问题,例如从GBK向UTF8迁移时,应在连接字符串中显式指定charset=gbk参数,并在目标库启用CLIENT_ENCODING兼容性设置,防止出现乱码导致的校验失败。

Step 4:事务控制优化

合理设置事务边界:将逻辑相关的数据块打包为单个事务单元,既保证原子性又减少锁竞争,在MySQL中可通过调整innodb_flush_log_at_trx_commit参数优化刷盘频率,平衡性能与安全性需求。

典型错误应对预案

| 错误类型 | 诊断方法 | 解决方案 |

|---|---|---|

| 主键冲突 | Show Engine InnoDB Status | 修改冲突记录的业务标识符或启用自动递增代理键 |

| 外键约束违反 | Check Foreign Key Violations View | 优先补充缺失的父表条目,其次考虑级联删除策略 |

| 数据类型溢出 | SHOW WARNINGS | 扩展目标列宽度;对数值型字段实施范围裁剪 |

| 字符截断丢失 | Dumpfile Hexdump Analysis | 统一源数据的NVARCHAR长度定义;启用ZEROFILL填充 |

FAQs

Q1:如何快速定位导入失败的具体位置?

A:启用详细日志模式(如MySQL的--verbose选项),结合二进制日志坐标定位,大多数现代数据库还提供基于行的报错行号指示器,可直接跳转到Excel对应行列进行修正。

Q2:大量浮点数精度丢失怎么办?

A:改用DECIMAL(M,D)类型替代FLOAT/DOUBLE;在数据抽取阶段即进行四舍五入预处理;或者采用字符串暂存+程序化解析的折衷方案,保留完整精度信息供应用程序动态渲染。

实现数据容错的核心在于构建弹性导入管道——通过预处理标准化降低初始错误率,利用中间件缓冲层吸收突发异常,最终形成闭环的数据质量监控体系,实际实施时建议采用逐步收紧的策略:先宽松接纳全部数据建立基线统计模型,再根据业务规则迭代