怎么把服务器数据库拷下来

- 数据库

- 2025-08-20

- 19

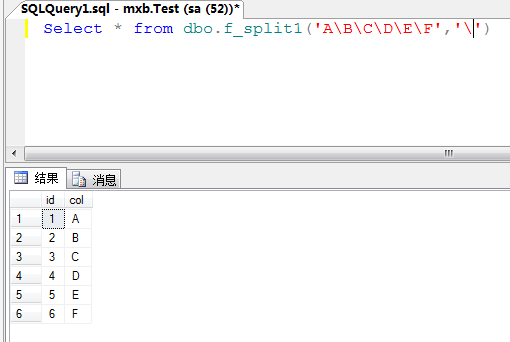

mysqldump等命令行

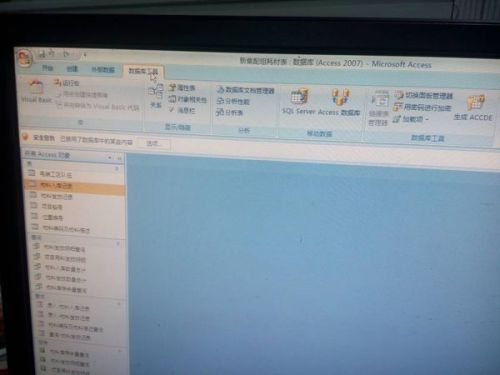

服务器上的数据库拷贝下来(即进行备份或迁移),具体操作取决于所使用的数据库管理系统(如MySQL、PostgreSQL、SQL Server、Oracle等)、操作系统环境以及目标存储位置,以下是详细的通用步骤和针对不同主流数据库的具体实现方法,涵盖命令行工具与图形化界面两种方式,并附注意事项及常见问题解决方案。

核心原理与准备工作

无论采用何种方式,本质都是通过特定指令生成包含完整数据的二进制文件(物理备份)或结构化脚本(逻辑备份),在此之前需完成以下基础配置:

权限验证:确保当前登录账户具备SELECT, LOCK TABLES等必要权限;若涉及跨网络传输,还需检查防火墙是否开放对应端口。

空间预留:本地磁盘/外部存储设备应有足够容量存放备份文件(建议比原数据库大20%以上)。

业务低峰期执行:避免高并发写入导致锁表超时错误,通常选择深夜时段操作。

版本兼容性确认:新旧环境的数据库主版本号应保持一致(例如从MySQL 8.0导出的数据不宜直接导入到5.7)。

主流数据库实操指南

场景1:MySQL/MariaDB

这是最广泛使用的开源关系型数据库之一,支持多种备份策略:

| 方法类型 | 适用场景 | 优点 | 缺点 |

|—————-|——————————|———————–|————————–|

| mysqldump | 中小型库、结构复杂的表 | 生成可读性强的SQL脚本 | 大数据量时效率低 |

| mysqlhotcopy | InnoDB引擎的大体量单表 | 速度快且占用资源少 | 仅能备份MyISAM格式数据 |

| XtraBackup | Percona提供的企业级工具 | 在线热备无锁表影响 | 需要额外安装依赖包 |

方案A:使用mysqldump命令行导出

# 基本语法(带注释和触发器的完整导出) mysqldump -u [用户名] -p --single-transaction --routines --triggers [数据库名] > backup_$(date +%F).sql # 示例:备份名为"testdb"的所有内容到当前目录 mysqldump -u root -p --single-transaction --routines --triggers testdb > /backups/testdb_backup_20250417.sql

️ 关键参数解析:

--single-transaction:通过事务保证一致性快照,替代旧版的--lock-tables减少阻塞;--skip-tz-utc:若遇到时区转换异常可添加此选项强制使用本地时间;--result-file=filename:指定输出路径而非标准输出重定向。

方案B:借助phpMyAdmin可视化操作

- 登录Web管理后台 → 选中目标数据库 → 点击顶部菜单栏的“导出”;

- 在“自定义”标签页勾选所需对象类型(结构+数据/仅结构);

- 选择压缩格式(GZIP可减小体积)、字符集编码后提交下载。

提示:对于超大数据库,建议分批次导出各个表再手动合并。

场景2:PostgreSQL

作为功能丰富的对象关系型系统,其备份机制更强调原子性和并行处理能力:

# 方式①:pg_dump实用程序(推荐) pg_dump -U postgres -F c -b -v -f /path/to/backup.dump dbname # 参数说明:-F c表示自定义格式归档,支持增量更新;-b包含大对象存储的数据块 # 方式②:COPY命令逐表导出CSV(适合数据分析场景) COPY table_name TO '/tmp/output.csv' DELIMITER ',' HEADER;

进阶技巧:结合pg_restore可实现基于时间点的精准恢复,配合WAL日志还能实现PITR(点对点恢复)。

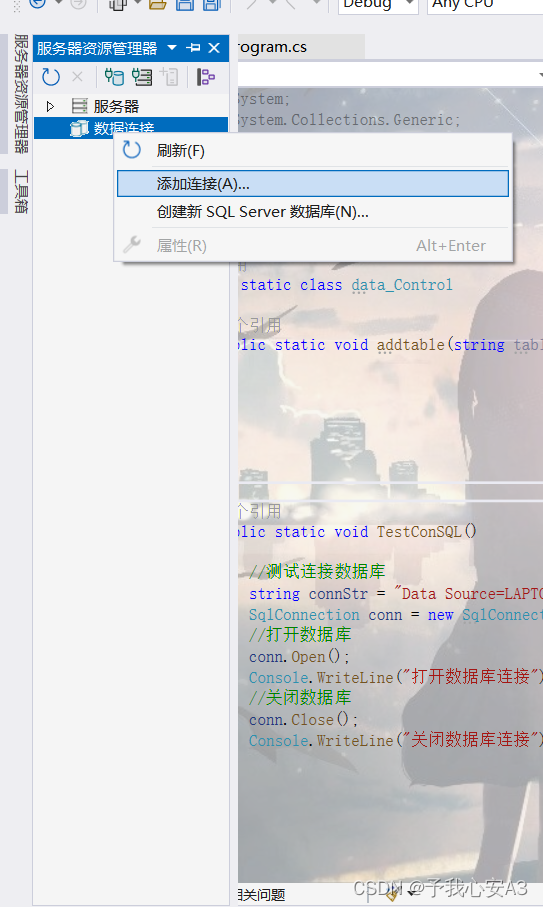

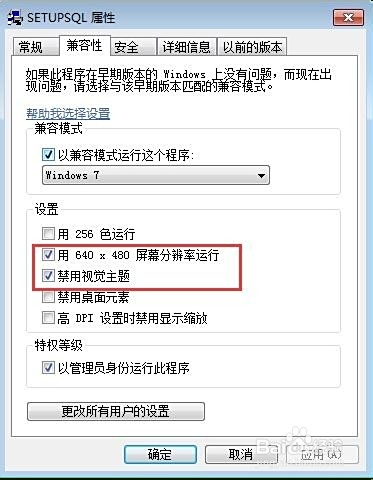

场景3:Microsoft SQL Server

微软生态下的商业化解决方案提供了图形化的维护计划任务功能:

- 打开SSMS管理器 → 右键实例→任务→备份;

- 选择完整备份模式,设置覆盖策略为“追加到媒体集”;

- 高级选项中启用校验和计算以提高可靠性。

或者通过T-SQL脚本自动化执行:BACKUP DATABASE AdventureWorks TO DISK='D:SQLBackupsAdventureWorks.bak' WITH INIT, COMPRESSION; GO

注意:当启用透明数据加密(TDE)时,必须同时备份证书私钥才能正常解密数据。

场景4:MongoDB NoSQL数据库

文档型数据库采用不同的设计理念,常用mongoexport工具实现JSON格式转储:

mongoexport --db mydatabase --collection users --out users_backup.json # 如果集合数量庞大,可以用--oplog选项记录变更历史便于后续同步

对于海量数据集,推荐使用OplogTail工具实现持续增量备份。

通用优化建议

- 压缩处理:Linux环境下可通过管道组合实现无损压缩:

mysqldump ... | gzip > backup.sql.gz # GZIP算法平衡速度与比率 tar -zcf archive.tar.gz folder/ # Tar打包后再压缩更适合多文件场景

- 加密传输:敏感数据应启用SSL/TLS加密通道传输,例如MySQL配置项中加入:

[client] ssl-ca=/etc/mysql/ca.pem ssl-cert=/etc/mysql/client-cert.pem ssl-key=/etc/mysql/client-key.pem

- 自动化调度:利用cronjob定期执行备份脚本并清理过期副本:

0 3 /usr/bin/mysqldump ... >> /var/log/db_backup.log 2>&1 && find /backups -mtime +30 -exec rm {} ; - 验证完整性:恢复前务必先用校检命令确认文件有效性:

mysqlcheck --all-databases --auto-repair # MySQL校验工具 pg_verifychecksums backup.dump # PostgreSQL哈希校验

典型错误排查手册

| 现象描述 | 可能原因 | 解决方法 |

|---|---|---|

| “Access denied”报错 | 用户权限不足 | GRANT ALL PRIVILEGES ON TO ‘user’@’host’; FLUSH PRIVILEGES; |

| 导出过程中断 | 内存溢出或磁盘满 | 增大sort_buffer_size参数值;切换至临时目录较大的分区 |

| 中文字符乱码 | 字符集设置不一致 | 确保客户端与服务端均使用UTF8mb4编码格式 |

| 外键约束失败 | 表导出顺序错误 | 按依赖关系逆序排列导出顺序(先子表后父表) |

| 恢复后缺失存储过程 | 未包含例行程序选项 | 添加–routines参数重新导出 |

FAQs

Q1: 如果数据库正在被频繁写入,如何保证备份数据的一致性?

A: 对于支持事务的引擎(如InnoDB),可以使用--single-transaction参数创建一个只读事务快照;若不支持事务则需短暂加锁(FLUSH TABLES WITH READ LOCK),完成后立即解锁,LSM树结构的NoSQL数据库通常采用写时复制技术保证最终一致性。

Q2: 为什么有时候备份出来的SQL文件无法直接导入到另一个环境?

A: 常见原因包括:①大小写敏感差异(Linux区分大小写而Windows不区分);②特殊函数兼容性问题(如MySQL的INFORMATION_SCHEMA在其他数据库不存在);③自增ID冲突(可通过--skip-auto-increment跳过该属性),建议在导出时启用--compatible=ANSI