数据库 怎么排除相同的

- 数据库

- 2025-08-20

- 21

数据库中排除相同记录,可用

DISTINCT 关键字查询去重;或用

GROUP BY 分组结合聚合函数;也可通过子查询、窗口函数等实现,具体依

数据库管理中,排除相同(即去重)是一项常见且重要的任务,以下是详细的技术和方法介绍,涵盖不同场景下的解决方案:

基础SQL实现方式

-

DISTINCT关键字

- 原理:直接对查询结果中的指定列进行去重,仅保留唯一值组合,适用于简单场景下的单表操作,若需获取某字段的所有独立值,可编写如下语句:

SELECT DISTINCT column_name FROM table;,此命令会返回该列中所有不同的数值或文本条目; - 局限性:无法处理多条件关联的复杂逻辑,且当需要保留其他辅助信息时显得力不从心。

- 原理:直接对查询结果中的指定列进行去重,仅保留唯一值组合,适用于简单场景下的单表操作,若需获取某字段的所有独立值,可编写如下语句:

-

GROUP BY分组聚合

- 机制:将相同键值的数据归为一组后配合聚合函数使用,典型用法如统计每个类别的数量:

SELECT category, COUNT() FROM products GROUP BY category;,这种方式不仅能去重,还能同步完成数据分析任务; - 扩展应用:结合HAVING子句过滤特定条件的分组结果,提升查询灵活性。

- 机制:将相同键值的数据归为一组后配合聚合函数使用,典型用法如统计每个类别的数量:

-

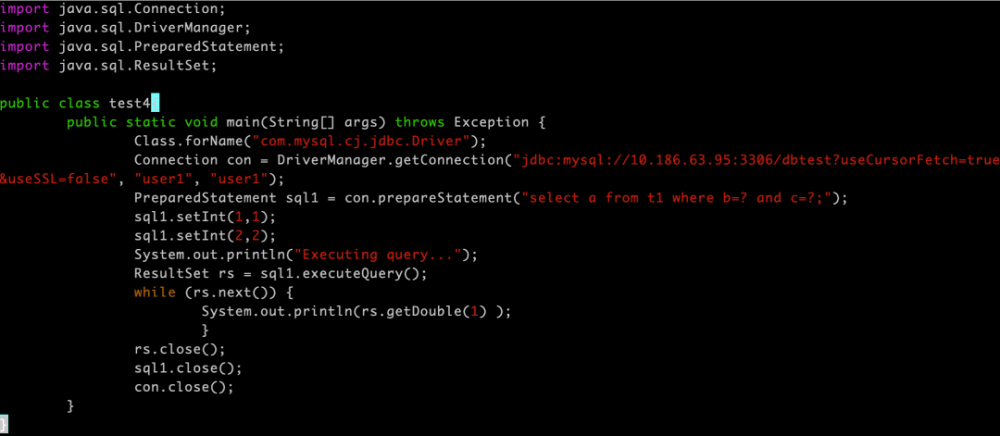

窗口函数ROW_NUMBER()

- 优势:通过为每行分配序号实现精准删重,具体步骤包括:①先按目标字段排序并编号;②筛选出序号为1的记录作为代表,示例代码如下:

WITH ranked AS ( SELECT , ROW_NUMBER() OVER (PARTITION BY duplicate_field ORDER BY id) AS rn FROM your_table ) DELETE FROM ranked WHERE rn > 1;

- 特点:特别适合需要保留完整数据集结构的同时删除冗余行的情况。

- 优势:通过为每行分配序号实现精准删重,具体步骤包括:①先按目标字段排序并编号;②筛选出序号为1的记录作为代表,示例代码如下:

索引与约束优化方案

| 技术手段 | 实现原理 | 适用场景 | 注意事项 |

|---|---|---|---|

| 唯一索引 | 在目标列上创建UNIQUE约束,阻止插入重复值 | 实时写入控制 | 已有重复数据会导致创建失败 |

| 联合主键 | 多个字段组合构成复合主键,强制这些字段的整体唯一性 | 复杂业务逻辑关联 | 设计时需谨慎规划字段顺序 |

| 外键引用检查 | 利用REFERENTIAL完整性约束间接保证相关表间数据的一致性 | 跨表级联更新保护 | 可能影响级联删除性能 |

唯一索引是最高效的事前防御机制,当尝试插入违反唯一性的记录时,数据库会立即抛出错误而非静默忽略,这为数据质量提供了强保障,但需注意,该方法不适用于事后清理已存在的脏数据。

高级处理策略

-

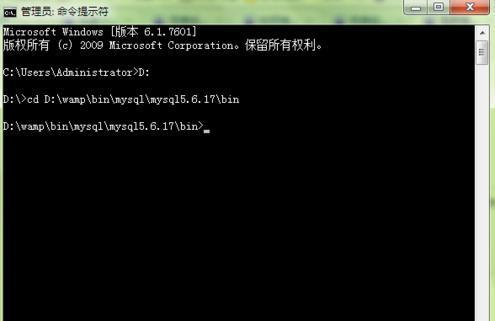

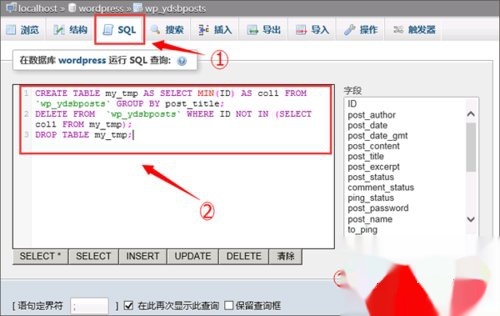

临时表置换法

- 操作流程:①创建新表结构→②导入去重后的干净数据→③重命名替换原表,这种方法在大数据量场景下尤为可靠,既能避免锁表风险,又能分阶段验证数据正确性。

CREATE TABLE temp_clean AS SELECT DISTINCT FROM original_table; DROP TABLE original_table; RENAME TABLE temp_clean TO original_table;

- 操作流程:①创建新表结构→②导入去重后的干净数据→③重命名替换原表,这种方法在大数据量场景下尤为可靠,既能避免锁表风险,又能分阶段验证数据正确性。

-

批量删除脚本

- 针对历史遗留问题严重的系统,可采用分批次删除策略,每次处理少量数据并提交事务,既能减少日志增长过快的问题,又能降低回滚代价,伪代码框架如下:

WHILE (EXISTS (SELECT 1 FROM table WHERE dup_flag = 1)) DO BEGIN TRANSACTION; DELETE TOP(1000) FROM table WHERE dup_flag = 1; COMMIT; END WHILE;

- 针对历史遗留问题严重的系统,可采用分批次删除策略,每次处理少量数据并提交事务,既能减少日志增长过快的问题,又能降低回滚代价,伪代码框架如下:

-

ETL工具集成

在数据仓库建设过程中,可通过Kettle等工具设置去重转换组件,这类可视化平台支持正则表达式匹配、模糊清洗等高级功能,适合异构数据源整合场景。

注意事项与最佳实践

- 备份先行原则:任何破坏性操作前必须全量备份原始数据,建议采用冷热备结合的方式,确保应急恢复能力;

- 事务管理规范:涉及DML语句的操作应包裹在显式事务中,便于错误回溯;

- 性能监控指标:重点关注执行计划中的索引使用情况、锁竞争程度及I/O吞吐量变化;

- 灰度测试策略:先在测试环境模拟生产负载压力,验证方案可行性后再上线实施。

FAQs

Q1: 如果表中已经存在大量重复数据,如何高效清理?

A: 推荐使用窗口函数标记重复项后批量删除,先运行SELECT , COUNT() OVER (PARTITION BY key_col) AS cnt FROM table;定位重复区域,再通过DELETE FROM table WHERE rowid NOT IN (SELECT MIN(rowid) FROM table GROUP BY key_col);安全移除多余副本,此方法比直接DELETE更可控且效率高。

Q2: 设置唯一索引失败怎么办?

A: 通常由现存重复数据导致,此时应分两步处理:①执行SELECT duplicate_field, COUNT() FROM table GROUP BY duplicate_field HAVING COUNT() > 1;查明冲突点;②手动修正或删除违规记录后重新创建索引,对于无法修改的历史数据,可考虑改用忽略重复项的加载模式(如MySQL的