上一篇

mysql大数据怎么导出导入数据库

- 数据库

- 2025-08-19

- 20

SQL大数据导出可用

mysqldump命令或工具如MySQL Workbench;导入则用

LOAD DATA INFILE或

mysql命令高效加载

是关于MySQL大数据导出与导入数据库的详细操作指南,涵盖多种方法及注意事项:

数据导出方法

-

使用

mysqldump工具- 适用场景:适用于全量备份或结构+数据的完整迁移,支持按库/表粒度导出,可自定义过滤条件。

- 基本语法:

mysqldump -u用户名 -p密码 数据库名 > 目标文件.sql,若需仅导出结构(无数据),添加--no-data;若仅导出数据则用--no-create-info,对于多线程压缩传输,可结合| gzip > backup.sql.gz减少I/O消耗。 - 优点:跨平台兼容性强,生成的逻辑SQL脚本包含建表语句和插入操作,适合异地恢复。

- 限制:超大表导出时可能较慢,建议分批次处理。

-

SELECT INTO OUTFILE

- 原理:通过SQL语句将查询结果直接写入服务器本地文件系统。

SELECT FROM table_name INTO OUTFILE '/path/data.csv' FIELDS TERMINATED BY ',' ENCLOSED BY '"';,需注意文件路径必须位于MySQL进程有写入权限的目录(如/tmp)。 - 配置依赖:需提前设置

secure_file_priv参数允许的目录范围,否则会报错,此方法适合结构化文本格式(CSV/TSV),便于后续ETL处理。 - 风险点:字段类型转换可能导致精度丢失,建议验证头部几行数据的完整性。

- 原理:通过SQL语句将查询结果直接写入服务器本地文件系统。

-

物理拷贝存储引擎文件(InnoDB/MyISAM)

- 操作步骤:停库→复制数据目录下对应表的 .ibd(InnoDB)或 .MYD/.MYI(MyISAM)文件至目标环境→启动库并执行

ALTER TABLE ... DISCARD/IMPORT TABLESPACE;快速挂载。 - 优势:速度最快,无需解析SQL逻辑,但要求源与目标实例的页大小、字符集等参数完全一致,版本差异可能导致兼容性问题。

- 警告:跨架构迁移失败率高,仅推荐同构环境使用。

- 操作步骤:停库→复制数据目录下对应表的 .ibd(InnoDB)或 .MYD/.MYI(MyISAM)文件至目标环境→启动库并执行

数据导入方法

-

LOAD DATA INFILE命令- 高性能实现:直接从文件批量加载数据到表中,语法示例:

LOAD DATA LOCAL INFILE 'data.csv' INTO TABLE tb_name FIELDS TERMINATED BY ',' IGNORE 1 LINES (col1,col2...);,关键字段包括:LOCAL:客户端本地文件上传(受secure_file_priv限制);IGNORE n LINES:跳过头部注释行;SET col=DEFAULT:处理默认值赋值。

- 性能对比:相比逐条

INSERT,吞吐量提升,尤其配合主键顺序预排序时效果更佳,但需确保数据类型严格匹配,否则会因隐式转换出错。

- 高性能实现:直接从文件批量加载数据到表中,语法示例:

-

mysqlimport实用程序- 自动化批量导入:本质是封装好的

LOAD DATA INFILE,支持并行处理多个文件,典型用法:mysqlimport -u user -p db_name --fields-terminated-by=, path/to/directory/,可通过--ignore-lines=1忽略首行表头。 - 适用性:适合标准化结构的CSV批量上架,如日志分析后的结构化数据集回灌,缺点是无法处理复杂约束(如外键级联更新)。

- 自动化批量导入:本质是封装好的

-

Binlog归放(增量同步)

- 实时同步方案:开启二进制日志后,使用

mysqlbinlog program_time.start --stop-position=... | mysql -u user -p实现时间点精准恢复,常用于主从复制故障切换后的增量补偿。 - 技术细节:需记录原主库的File+Position坐标,适用于灾难恢复场景下的最小数据丢失需求,但存在锁表风险,应避免在高峰时段操作。

- 实时同步方案:开启二进制日志后,使用

-

第三方工具增强

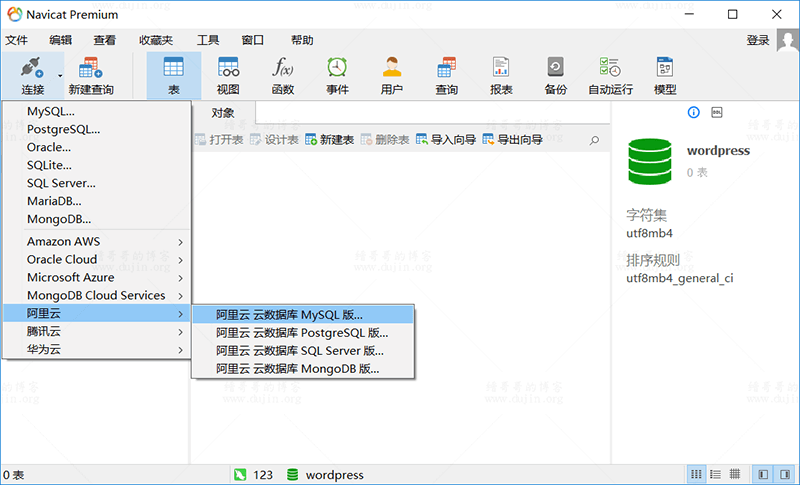

- 可视化界面工具:如Navicat、DBeaver提供向导式导入导出功能,支持进度监控和错误预览,适合非技术人员快速试错。

- 云厂商解决方案:AWS DMS、阿里云Data Transmission Service可实现异构数据库间实时同步,内置断点续传机制应对网络波动。

常见错误及优化策略

| 问题类型 | 根本原因 | 解决方案 |

|---|---|---|

| 字符集乱码 | 源端与目标端编码不一致 | 统一使用UTF8MB4,导出时加 --default-character-set=utf8mb4 |

| 主键冲突 | 目标表已存在相同ID记录 | 导入前执行 TRUNCATE TABLE 或启用 IGNORE 模式 |

| 内存溢出 | sort_buffer_size过小 | 调整my.cnf中的 sort_buffer_size=64M |

| IOPS瓶颈 | 磁盘写入竞争 | 采用SSD存储,分散大文件到多分区 |

相关问答FAQs

-

Q: 为什么用mysqldump导出的文件在导入时提示中文乱码?

- A: 这是由于导出和导入时的字符集设置不一致导致的,解决方法是在执行mysqldump时指定统一的字符集参数,例如添加

--default-character-set=utf8mb4,并且在导入时也确保目标数据库使用相同的字符集(最好是utf8mb4),同时检查终端或命令行的编码是否匹配。

- A: 这是由于导出和导入时的字符集设置不一致导致的,解决方法是在执行mysqldump时指定统一的字符集参数,例如添加

-

Q: 使用LOAD DATA INFILE导入大量数据时报“Errno 13: Permission denied”怎么办?

A: 此错误通常是因为MySQL服务进程没有权限读取你要导入的文件,解决步骤包括:①确认文件的实际路径是否在MySQL配置的secure_file_priv允许范围内(可通过SHOW VARIABLES LIKE ‘secure_file_priv’;查看);②将文件放置在/tmp目录下(通常默认允许);③修改文件权限为属主为mysql用户(chown mysql:mysql your_file.csv);④若使用LOCAL关键字仍失败,尝试移除LOCAL