java oom怎么解决

- 后端开发

- 2025-08-13

- 19

增大JVM堆内存;通过MAT等工具定位内存泄漏;优化代码逻辑,减少不必要对象创建;及时关闭流/

Java OutOfMemoryError(简称OOM)是开发及生产环境中常见的严重性能瓶颈,其本质是程序向JVM申请内存时超出可用内存限制,该问题可能由代码缺陷、配置不当或系统资源不足引发,需结合多维度手段进行系统性排查与修复,以下从核心概念解析、典型诱因分析、分级解决方案、实战操作指南、预防性优化策略五个层面展开深度阐述,并提供配套工具链与案例参考。

OOM基础认知体系化构建

1 JVM内存区域划分与OOM映射关系

| 内存区域 | 主要功能 | 常见OOM表现 | 典型触发场景 |

|---|---|---|---|

| 堆区(Heap) | 存储对象实例 | java.lang.OutOfMemoryError: Java heap space |

大对象频繁创建/集合类无限增长 |

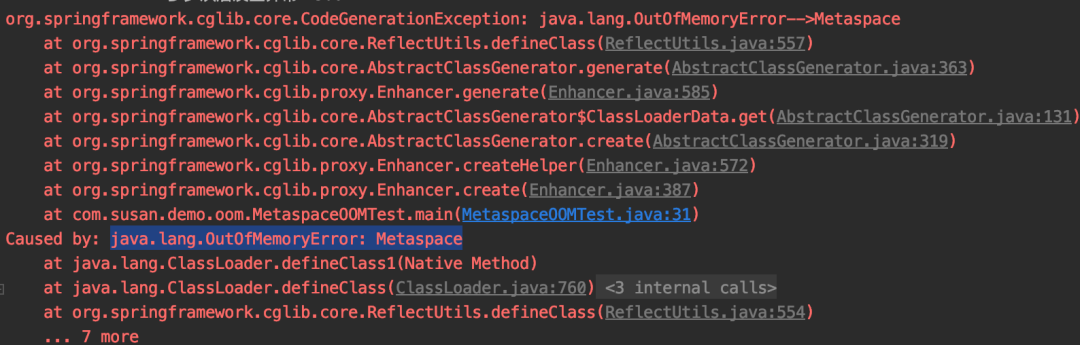

| 方法区(Method Area) | 存储类元信息、静态变量 | java.lang.OutOfMemoryError: Metaspace |

动态代理/CGLIB代理滥用 |

| 栈区(Stack) | 方法调用帧/局部变量 | StackOverflowError |

递归未终止/深层嵌套调用 |

| 直接内存(Direct Memory) | NIO DirectByteBuffer分配 | OutOfMemoryError: Direct buffer memory |

大数据流处理未释放资源 |

2 OOM本质特征提炼

动态性:并非固定阈值触发,取决于GC回收效率与对象存活周期;

隐蔽性:部分场景表现为CPU飙升(频繁Full GC)、响应延迟而非直接崩溃;

连锁反应:一次OOM可能导致级联故障(如缓存击穿→数据库连接池耗尽)。

四阶递进式解决方案矩阵

▶ 第一阶段:紧急止血(线上环境优先)

| 操作 | 实施要点 | 风险提示 |

|---|---|---|

| 重启应用 | 立即终止异常进程,采用蓝绿部署恢复服务 | 临时方案,未解决根本问题 |

| 强制Dump堆快照 | jmap -dump:format=b,file=heapdump.bin <pid> |

高负载下可能加剧卡顿 |

| 动态扩容 | 容器环境上调-Xmx参数(建议不超过物理内存的80%) |

治标不治本,需后续容量规划 |

▶ 第二阶段:精准诊断(基于Heap Dump)

工具链组合拳:

- MAT/JVisualVM:识别TOP5大对象占用者(重点关注ArrayList/HashMap等容器);

- OQL查询:

select count(s) from java.util.HashMap$Entry s统计可疑集合规模; - 支配树分析:定位对象引用链起点(判断是否存在循环引用);

- GC日志解析:开启

-XX:+PrintGCDetails -XX:+PrintGCDateStamps追踪GC频率。

典型案例:某电商系统促销期间出现Young Gen Eden Space OOM,经MAT分析发现ConcurrentHashMap存储了百万级未过期的优惠券记录,实际业务逻辑应设置TTL自动清理。

▶ 第三阶段:代码级重构(根源治理)

| 问题类型 | 优化策略 | 技术选型建议 |

|---|---|---|

| 内存泄漏 | 改用弱引用(WeakReference)、软引用(SoftReference)管理缓存 | Guava Cache替代原始Map实现LRU |

| 大对象滥用 | 拆分超大对象为多个小对象,避免跨代晋升 | FastUtil替代Apache Commons工具类 |

| 线程池失控 | 使用ThreadPoolExecutor替代无界队列,设置合理corePoolSize/maximumPoolSize |

HikariCP连接池默认值优于DBCP |

| 流式数据处理不当 | 采用Reactor/Publisher模式背压机制,限制并发消费速率 | Project Reactor框架集成 |

代码改造示例:

// 反例:无界队列导致Old Gen膨胀

BlockingQueue<Order> queue = new LinkedBlockingQueue<>();

while(true){ queue.put(new Order()); }

// 正例:设置最大容量+拒绝策略

new LinkedBlockingQueue<>(10000, new AbortPolicy());

▶ 第四阶段:架构级调优(长期稳定)

| 维度 | 优化方向 | 效果预期 |

|---|---|---|

| JVM参数调优 | 根据GC日志调整新生代/老年代比例(-XX:NewRatio=2),启用G1收集器 | Young GC耗时降低40%+ |

| 分布式改造 | 将单体应用拆分为微服务,通过RPC调用解耦内存压力 | 单节点内存需求下降60%-70% |

| 异步化设计 | 将非实时任务转入消息队列(Kafka/RocketMQ),主流程快速释放内存 | TPS提升3-5倍 |

| 数据分片 | 采用ShardingSphere对数据库/Redis进行水平分片,避免单节点全量加载 | 内存占用减少至1/N |

生产环境实战操作手册

1 应急响应SOP

- 黄金1分钟:执行

kill -9 <pid>强制终止进程,启动备用节点; - 保留现场证据:同步保存以下文件:

/proc/<pid>/maps→ 查看内存映射关系/var/log/java/.gc.log→ 获取最新GC日志core dump文件(需提前配置ulimit -c unlimited)

- 滚动回滚:若新版本发布后出现OOM,立即回退至上一稳定版本。

2 Heap Dump深度分析流程

graph TD

A[获取Heap Dump] --> B{文件大小>5GB?}

B -->|是| C[使用Eclipse MAT分段加载]

B -->|否| D[完整加载至MAT]

D --> E[执行Dominator Tree分析]

E --> F{存在可疑对象?}

F -->|是| G[查看GC Roots追溯来源]

F -->|否| H[检查线程栈状态]

H --> I[定位死锁/长耗时线程]

G --> J[修改代码打破引用链]

3 JVM参数模板推荐

| 场景 | 关键参数组合 | 适用场景 |

|---|---|---|

| 高并发读写 | -Xms4g -Xmx4g -XX:MaxDirectMemorySize=2g -XX:+UseG1GC |

电商瞬秒、金融交易系统 |

| 大数据批处理 | -Xms8g -Xmx8g -XX:InitiatingHeapOccupancyPercent=40 |

Spark/Flink计算任务 |

| 微服务网关 | -Xms2g -Xmx2g -XX:SurvivorRatio=8 -XX:TargetSurvivorRatio=50% |

Spring Cloud Gateway |

长效预防机制建设

1 监控告警体系

| 指标 | 阈值 | 检测工具 | 处置动作 |

|---|---|---|---|

| Heap Used % | >85%持续5min | Prometheus+Grafana | 触发扩容+发送钉钉告警 |

| Young GC频率 | >2次/分钟 | Micrometer+Arthas | 自动dump堆快照 |

| Metaspace Used % | >90% | JMX+Zabbix | 禁止新类加载+紧急扩容 |

2 代码评审规范

制定《内存敏感操作清单》:

- 禁止在静态变量中存储可变集合;

- 所有缓存必须设置过期时间;

- ️ 慎用

Arrays.asList()返回的固定大小列表; - 推荐使用

Collections.emptyList()代替新建空集合。

3 压力测试方法论

采用阶梯式加压策略:

- 初始负载:日常峰值的120%;

- 每阶段递增20%流量,持续30分钟;

- 重点观察指标:Young GC间隔时间、FGC持续时间、Heap Growth Rate;

- 当出现首次OOM时,记录当时的请求量作为警戒线。

相关问答FAQs

Q1: 为什么我增加了物理内存仍然报OOM?

A: 新增物理内存仅扩大了JVM可申请的理论上限,若存在以下情况仍会触发OOM:①对象存活周期过长导致Old Gen填满;②线程栈空间未单独限制(-Xss参数);③本地缓存未设置淘汰策略,建议同步检查GC日志中的”Promotion Failed”事件,这表示年轻代晋升失败导致提前触发Full GC。

Q2: 如何快速定位是哪个类导致的OOM?

A: 使用jstat -gc <pid>实时监控各代内存变化,结合jstack <pid>获取线程快照,若发现某类对象持续增长,可通过以下命令精确统计其实例数量:jmap -histo:live <pid> | grep YourClassName,更高效的方法是使用Async Profiler进行火焰图分析,能直观显示CPU热点与