数据库存在的问题怎么解决

- 数据库

- 2025-08-13

- 25

数据库作为现代信息系统的核心组件,其稳定性和效率直接影响业务运行质量,然而在实际运维中,数据库常面临性能衰退、数据不一致、安全破绽、扩展困难等问题,以下从典型问题表现、根本原因分析、针对性解决方案三个维度展开详述,辅以技术对比表格帮助理解,最后附上高频问答环节。

性能瓶颈类问题及解决方案

1 查询响应迟缓

现象特征:复杂关联查询执行时间超过预期,简单条件筛选也出现明显卡顿,CPU利用率持续高位运行。

核心成因:

缺少有效索引或索引设计不合理(如过度创建非必要索引)

执行计划未走最优路径(统计信息过时导致优化器误判)

单次查询返回海量数据造成网络拥堵

表结构设计缺陷(冗余字段过多/反规范化不足)

解决方案矩阵:

| 问题类型 | 诊断工具 | 优化手段 | 效果验证方式 |

|—————-|————————-|————————————————————————–|————————–|

| 索引失效 | EXPLAIN执行计划 | 添加复合索引、覆盖索引、删除重复索引 | 对比执行前后的扫描行数 |

| 统计信息滞后 | ANALYZE命令 | 定期更新表/索引统计信息(MySQL可通过ANALYZE TABLE手动触发) | 观察执行计划是否改变 |

| 大数据量传输 | 分页查询 | 使用LIMIT+OFFSET配合游标分页,或基于唯一键的范围查询替代物理偏移 | 监控网络带宽占用率 |

| 表设计不合理 | 慢查询日志 | 拆分宽表为子表、引入中间表解耦多对多关系、采用垂直分区减少单行体积 | 检查磁盘I/O等待时间 |

进阶实践:对于OLAP场景,可考虑列式存储引擎(如ClickHouse);若存在大量文本搜索需求,集成Elasticsearch建立倒排索引。

2 写入吞吐量不足

现象特征:批量插入时事务提交缓慢,并发写入导致死锁频发,磁盘空间快速增长。

核心成因:

事务粒度过大(单个事务包含数百条记录)

未启用批量写入接口(逐条INSERT代替BULK LOAD)

日志同步机制拖慢性能(如MySQL的binlog同步)

存储引擎特性限制(MyISAM不支持事务但易引发崩溃恢复)

优化策略:

- 批处理改造:将

INSERT INTO ... VALUES (...)改为批量插入语法,利用预写日志批量提交特性。 - 异步写入:通过消息队列缓冲写请求,由消费者异步落库,牺牲一定实时性换取吞吐量提升。

- 存储引擎切换:对纯写入负载可选择TokuDB/RocksDB等专为高速写入设计的引擎。

- 硬件加速:配置SSD硬盘提升随机写性能,增加RAID卡缓存容量分散I/O压力。

数据一致性风险及应对

1 事务隔离引发的脏读/幻读

典型场景:金融转账系统中未提交的余额变动被其他事务读取,导致双重支付破绽。

根源剖析:默认的READ COMMITTED隔离级别无法阻止不可重复读现象,REPEATABLE READ虽能规避但仍存在间隙锁竞争。

解决方案对比表:

| 隔离级别 | 适用场景 | 优点 | 缺点 |

|——————-|————————|————————–|————————–|

| SERIALIZABLE | 资金结算等关键业务 | 完全串行化保证绝对一致 | 性能损耗极大 |

| REPEATABLE READ | 库存扣减等准实时系统 | 锁定事务期间的数据快照 | 长事务易引发锁等待 |

| READ COMMITTED | 日志记录等非敏感场景 | 最小化锁冲突概率 | 可能出现不可重复读 |

| READ UNCOMMITTED | 内部调试环境 | 无锁读取最快响应 | 存在脏读风险 |

最佳实践:结合乐观锁机制,在业务层通过版本号校验控制并发修改冲突,减少数据库锁竞争。

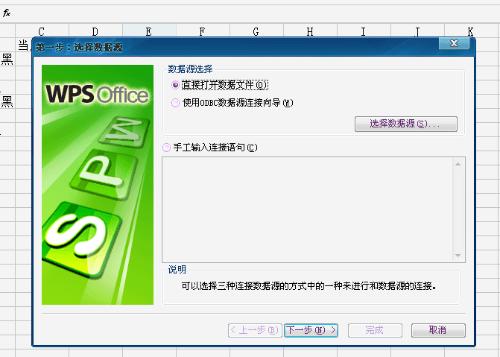

2 分布式事务一致性难题

挑战点:跨数据中心的交易需要满足CAP理论中的C(一致性)与A(可用性)平衡。

主流方案选型:

- 两阶段提交(XA):强一致性保障但单点故障会导致全局阻塞,适合传统金融核心系统。

- TCC模式:通过Try-Confirm-Cancel三阶段实现柔性事务,需业务代码改造支持空回滚。

- 本地消息表:将事务操作封装为消息事件,通过轮询机制确保最终一致性,适用于微服务架构。

- Saga模式:长事务拆分为多个短事务,通过补偿机制应对失败场景,电商订单流程常用此方案。

安全防护体系构建

1 权限滥用防控

风险案例:开发人员账号拥有生产环境DROP权限,误操作导致整库删除。

防御体系:

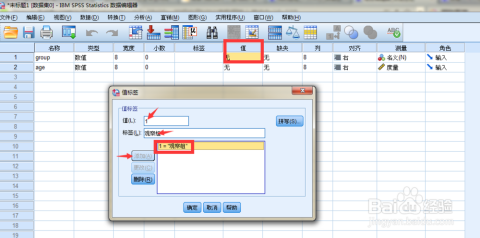

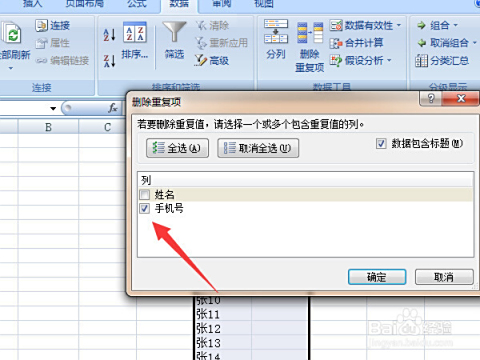

- 最小权限原则:按角色分配权限(RBAC),开发/测试/运维环境独立授权。

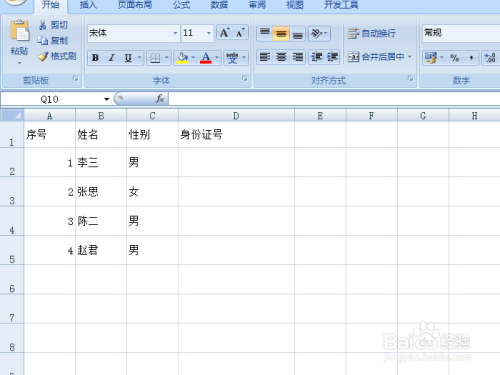

- 动态脱敏:对敏感字段(手机号、身份证号)实施掩码展示,审计日志记录完整明文。

- SQL防火墙:拦截未经授权的DDL操作,限制超级用户仅能通过跳板机登录。

2 SQL注入防护

攻击原理:反面构造的输入参数改动SQL语义,绕过身份验证获取非规数据。

防御组合拳:

- 预编译语句:强制使用PreparedStatement绑定参数,彻底隔离SQL逻辑与用户输入。

- 正则校验:对输入内容进行格式白名单校验(如邮箱必须符合RFC标准)。

- Web应用防火墙(WAF):部署ModSecurity等工具实时阻断可疑请求特征。

扩展性瓶颈突破

1 纵向扩展VS横向扩展

| 指标 | 纵向扩展(Scale Up) | 横向扩展(Scale Out) |

|---|---|---|

| 实施难度 | 硬件替换停机时间长 | 新增节点无缝扩容 |

| 成本曲线 | 指数级增长(高端服务器昂贵) | 线性增长(普通PC服务器堆叠) |

| 最大容量 | 受单机硬件上限制约 | 理论上无限扩展 |

| 适用场景 | QPS<1万的小中型应用 | QPS>10万的高并发互联网业务 |

分片策略选择:

- 范围分片:按时间戳或自增ID区间划分,适合热点数据集中的场景。

- 哈希分片:对关键字段取模运算分散数据,避免单节点过热。

- 目录分片:按业务维度切分(如用户ID末两位决定所属分片),便于局部迁移维护。

2 读写分离架构优化

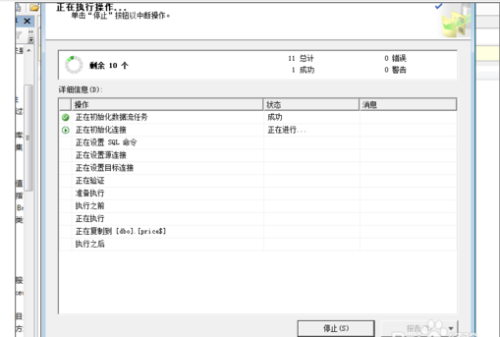

经典三层架构:主库负责写操作+实时读,从库集群承担历史读请求,通过Canal或Debezium实现增量数据同步。

延迟容忍度设计:根据业务需求设定读写延迟阈值(如报表查询允许5分钟延迟),超出阈值则强制路由回主库。

备份与恢复体系建设

灾难恢复目标(RPO/RTO)对照表:

| 业务等级 | RPO(可容忍数据丢失量) | RTO(恢复时间目标) | 实施方案 |

|———-|————————-|———————|———————————–|

| 核心交易 | <1秒 | <5分钟 | 主从热备+异地灾备+秒级快照 |

| 普通业务 | <5分钟 | <1小时 | 每日全备+每小时增量+日志归档 |

| 归档数据 | >24小时 | >24小时 | 磁带库冷备+对象存储低成本留存 |

验证方法论:每月模拟故障演练,记录从灾难发生到业务恢复的全流程耗时,重点测试备份文件完整性和恢复脚本执行成功率。

相关问答FAQs

Q1: 为什么加了索引之后某些查询反而变慢?

A: 这是典型的”过度索引”副作用,当单表索引数量超过5个时,每次INSERT/UPDATE/DELETE都需要额外维护所有相关索引,导致写性能下降,建议通过SHOW INDEX FROM table_name查看现有索引,删除重复的前缀索引,并对频繁更新的字段慎用唯一索引。

Q2: 主从复制出现延迟应该怎么处理?

A: 根本原因是主库产生二进制日志的速度超过从库执行速度,应急处理可临时提高slave_parallel_workers参数开启并行复制,长期方案包括:①升级网络带宽至万兆;②选用更高配置的从库服务器;③关闭非必要的binlog_format=ROW模式;④对大