sql 怎么同步数据库数据库

- 数据库

- 2025-08-11

- 22

数据库同步的核心目标与挑战

核心目标:确保多个数据库实例间的数据一致性,支持高可用性、读写分离、灾备等需求。

常见挑战:

数据量级差异导致的同步延迟

异构数据库间的兼容性问题(如MySQL→Oracle)

事务一致性保障(ACID特性)

网络带宽与性能损耗平衡

冲突解决机制设计(乐观锁/悲观锁)

主流同步方案分类及对比

| 方案类型 | 原理简述 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|---|

| 主从复制 | 基于二进制日志(Binlog)传输 | 同构数据库高可用架构 | 延迟低、原生支持 | 仅单向同步、拓扑复杂 |

| 逻辑订阅 | 解析SQL语句并重放 | 异构数据库迁移 | 跨平台灵活 | 性能开销大 |

| 触发器+队列 | 通过INSERT/UPDATE/DELETE触发器捕获变更 | 微服务解耦场景 | 自定义逻辑扩展性强 | 开发维护成本高 |

| CDC(Change Data Capture) | 监控存储层修改记录 | 大数据量实时同步 | 非侵入式、支持回溯 | 依赖底层API稳定性 |

| ETL工具 | 定时抽取-转换-加载 | 离线数据分析场景 | 可视化配置便捷 | 实时性差 |

具体实施方案详解

▶ 方案1:MySQL主从复制(经典生产级方案)

适用场景:构建主备集群、读写分离架构

实施步骤:

- 主库配置 (

my.cnf):server-id=1 log_bin=mysql-bin binlog_format=ROW # 推荐混合格式MIXED expire_logs_days=7 # 自动清理旧日志

- 创建同步用户:

CREATE USER 'repl'@'%' IDENTIFIED BY 'password'; GRANT REPLICATION SLAVE ON . TO 'repl'@'%'; FLUSH PRIVILEGES;

- 获取主库坐标:

SHOW MASTER STATUS; -记录File/Position值

- 从库配置 (

my.cnf):server-id=2 relay-log=mysql-relay-bin

- 启动从库同步:

CHANGE MASTER TO MASTER_HOST='主库IP', MASTER_USER='repl', MASTER_PASSWORD='password', MASTER_LOG_FILE='mysql-bin.000001', MASTER_LOG_POS=1234; START SLAVE;

- 验证状态:

SHOW SLAVE STATUSG; -Seconds_Behind_Master应接近0

关键参数调优:

| 参数 | 默认值 | 推荐值 | 作用 |

|———————|——–|————–|————————–|

| slave-parallel-type| none | logical_clock | 并行应用事务 |

| read_only | off | on | 禁止从库写入 |

| sync_binlog | off | on | 确保崩溃时数据不丢失 |

▶ 方案2:PostgreSQL逻辑解码(跨版本同步)

适用场景:不同PG版本的数据迁移、云原生架构

核心组件:pg_logical扩展 + pg_receivewal工具

操作流程:

- 发布端配置 (

postgresql.conf):wal_level=logical max_wal_senders=5

- 创建发布规则:

CREATE PUBLICATION mypub FOR ALL TABLES IN NONE; -可选指定表/模式

- 订阅端连接:

pg_receivewal -D /data/standby -U replicator --publisher=mypub --node=primary --host=主库IP port=5432

- 高级特性:

- 使用

pg_createsubscriber创建物理订阅 - 配合

pg_stat_replication监控同步状态

- 使用

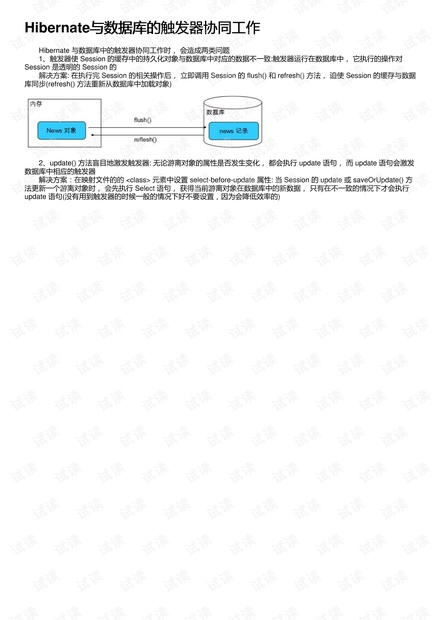

▶ 方案3:基于触发器的异步同步(通用型方案)

适用场景:异构数据库同步、第三方系统对接

实现原理:在源表定义触发器,将变更记录写入消息队列(Kafka/RabbitMQ),消费者程序读取后写入目标库。

示例代码片段(MySQL):

DELIMITER //

CREATE TRIGGER after_user_insert AFTER INSERT ON users

FOR EACH ROW BEGIN

INSERT INTO sync_queue (table_name, operation, data)

VALUES('users', 'INSERT', JSON_OBJECT(

'id', NEW.id,

'name', NEW.name,

'email', NEW.email,

'ts', NOW()

));

END//

DELIMITER ;

消费者程序逻辑(Python伪代码):

import psycopg2

from kafka import KafkaConsumer

consumer = KafkaConsumer('db_sync')

for msg in consumer:

data = json.loads(msg.value)

conn = psycopg2.connect(target_db_dsn)

with conn.cursor() as cur:

if data['operation'] == 'INSERT':

cur.execute(f"""INSERT INTO {data['table_name']} ...""") # 根据字段动态生成SQL

conn.commit()

关键注意事项清单

️ 数据一致性风险:

- 半同步复制(Semi-Sync)可降低主库宕机时的数据丢失风险

- 使用全局事务ID(GTID)替代传统基于文件位置的复制

- 定期执行

pt-table-checksum校验数据完整性

️ 性能优化建议:

| 维度 | 优化措施 | 效果提升 |

|————–|———————————–|—————-|

| 网络传输 | 启用压缩协议(gzip) | 减少70%流量 |

| CPU利用率 | 调整slave_preserve_commit_order | 避免死锁 |

| 磁盘IO | 单独挂载日志分区 | IOPS提升3倍 |

| 并发控制 | 设置slave_parallel_workers | QPS提高50% |

️ 异常处理机制:

- 自动重试策略(指数退避算法)

- 死信队列(Dead Message Queue)保存失败记录

- 告警阈值设置(连续5次同步失败触发短信通知)

典型应用场景选型指南

| 业务需求 | 推荐方案 | 补充说明 |

|---|---|---|

| 同城机房高可用 | MySQL半同步复制 | 配合MHA实现故障自动切换 |

| 异地容灾备份 | PostgreSQL流复制+延迟槽 | 设置hot_standby_feedback参数 |

| 电商订单系统扩容 | 分片+触发器异步同步 | 按用户ID哈希取模分散到多个从库 |

| 大数据平台数据采集 | CDC+Kafka+Flink | 实现Exactly Once语义 |

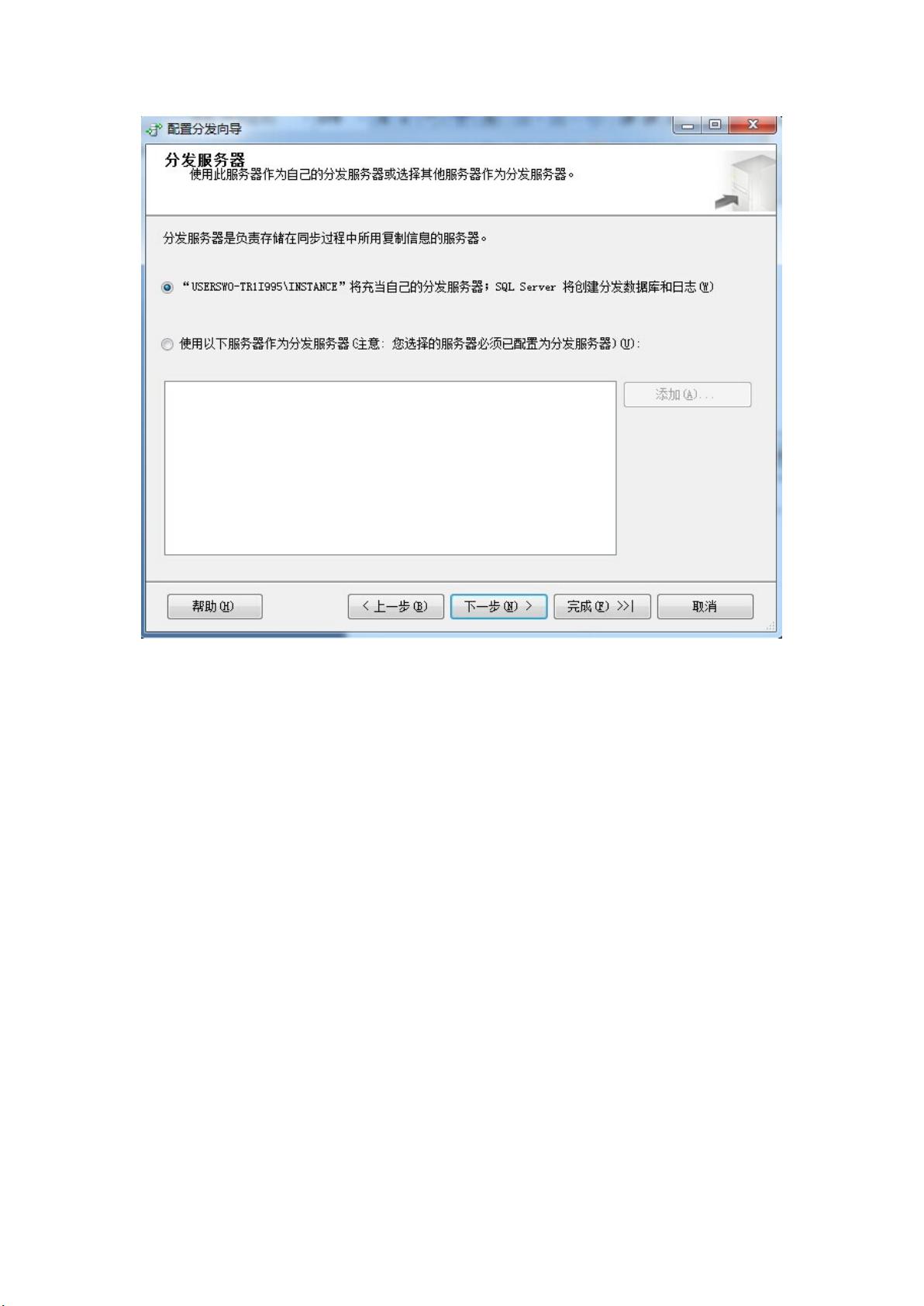

| 财务系统审计追踪 | SQL Server事务复制+LSN | 满足等保三级合规要求 |

FAQs(常见问题解答)

Q1: 主从复制出现”Seconds_Behind_Master”持续增大怎么办?

A: 这是典型的同步延迟问题,可采取以下措施逐级排查:

- 检查网络质量:使用

ping和iperf测试主从节点间带宽 - 优化大事务:将单个大事务拆分为多个小事务(控制在1秒内完成)

- 调整缓冲池:增大

innodb_buffer_pool_size至物理内存的80% - 启用并行复制:设置

slave_parallel_type=LOGICAL_CLOCK并分配足够工作线程 - 升级硬件:若持续出现延迟,考虑使用NVMe SSD加速IO性能

Q2: 如何实现MySQL到MongoDB的实时同步?

A: 推荐采用以下两种方案之一:

① 中间件方案:使用阿里Canal或MaxWell,通过解析MySQL Binlog生成MongoDB文档

② 应用层双写:在业务代码中同时写入MySQL和MongoDB,通过分布式事务保证一致性(需注意CAP理论权衡)

③ 定时校对:每小时执行全量比对,修正差异数据(适用于非关键业务)