上一篇

多台物理机虚拟化

- 物理机

- 2025-08-11

- 34

通过虚拟化技术将多台物理机整合为统一资源池,实现计算、存储与网络资源的灵活调度及

技术原理与核心组件

| 层级 | 功能描述 | 代表技术/工具 |

|---|---|---|

| 硬件层 | 多台x86架构物理服务器(支持Intel VT-x/AMD-V虚拟化指令集) | Dell R750、HPE ProLiant系列 |

| 虚拟化层 | Hypervisor(VMM)直接运行于裸金属上,创建虚拟机并管理CPU/内存/I/O资源 | VMware ESXi、Linux KVM、Microsoft Hyper-V |

| 资源池层 | 聚合多台物理机的计算/存储/网络资源,形成可弹性扩展的逻辑资源池 | vCenter Server、OpenStack Nova |

| 管理层 | 提供图形化控制台,实现跨物理机的虚拟机生命周期管理、负载均衡与故障恢复 | vSphere Client、Horizon View |

| 数据平面 | 基于SDN(软件定义网络)实现跨物理机的虚拟机通信与流量管控 | NSX-T、OVS(Open vSwitch) |

关键机制:

实时迁移(Live Migration):借助高速局域网络,可在不中断服务的前提下将运行中的虚拟机从一台物理机迁移至另一台,需满足:①源/目标主机使用相同版本Hypervisor;②共享存储可见性;③网络延迟<5ms。

分布式资源调度(DRS):根据预设规则(如CPU利用率阈值)自动平衡虚拟机负载,避免某台物理机过载。

高可用性(HA):当物理机发生硬件故障时,其承载的虚拟机会在预设时间内(3分钟)在其他物理机上重启。

架构设计与实施要点

硬件选型与组网

| 考量因素 | 推荐方案 | 避坑指南 |

|---|---|---|

| CPU兼容性 | 同一集群内选用同代际处理器(如均为Intel第3代至第4代),避免微码差异导致迁移失败 | 混用不同品牌/制程可能导致性能损耗 |

| 内存配置 | 每台物理机至少256GB DDR4 ECC内存,预留30%冗余给热迁移缓冲区 | 禁用NUMA优化可能引发内存访问延迟 |

| 存储方案 | 采用FC/SAS直连存储或分布式块存储(Ceph/GlusterFS),RAID级别≥10 | 避免NAS挂载作为启动盘(IOPS不足) |

| 网络架构 | 万兆电口绑定+VLAN隔离,管理/业务/存储三网分离 | 未划分VLAN易导致广播风暴 |

| 电源冗余 | 双路PDU供电+UPS后备,单台物理机功耗控制在800W以内 | 忽视散热会导致频繁降频 |

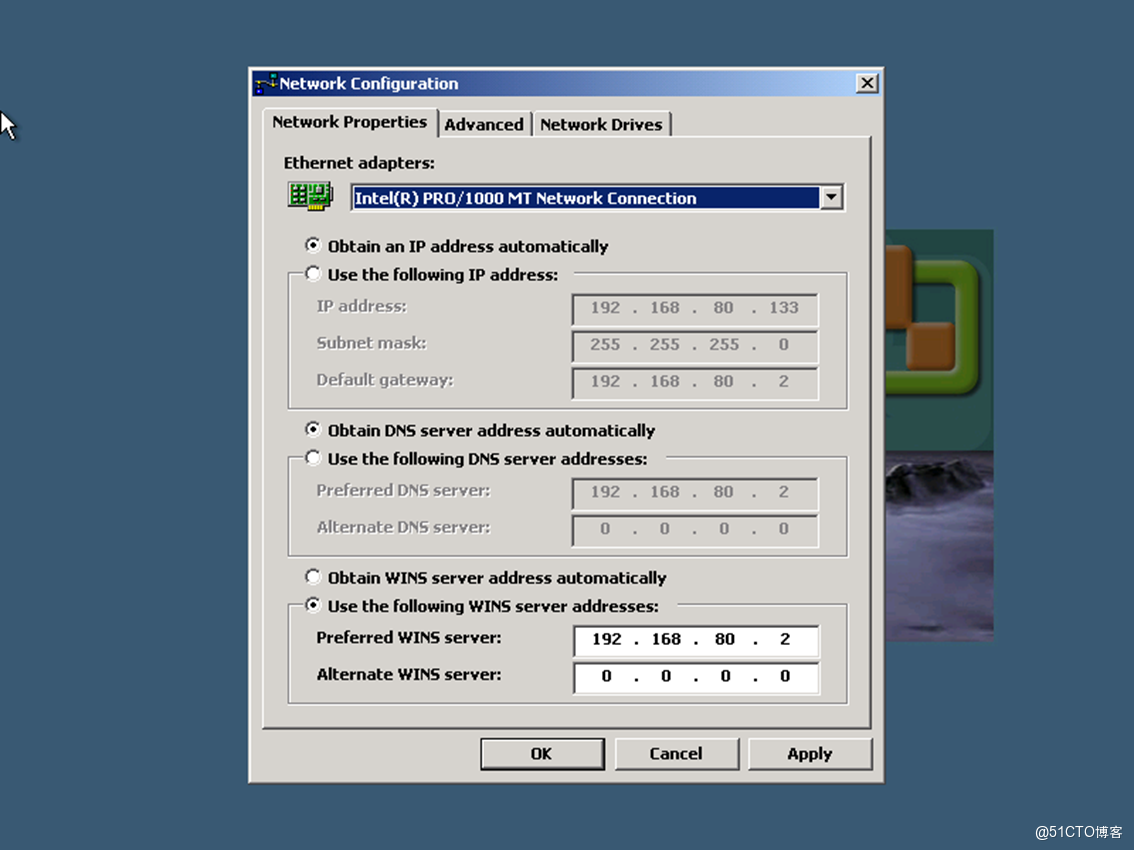

软件部署流程

graph TD

A[环境准备] --> B{物理机初始化}

B --> C[安装ESXi/KVM]

C --> D[配置NTP时间同步]

D --> E[创建分布式交换机]

E --> F[构建共享存储卷]

F --> G[启用DRS/HA]

G --> H[部署管理平台]

H --> I[验证跨主机迁移]

关键步骤说明:

- 时间同步:所有物理机NTP误差需<1秒,否则可能引发脑裂(Split Brain)。

- 存储格式化:若使用本地磁盘,必须启用厚置备延迟零(Thick Provision Lazy Zeroed);分布式存储需开启副本机制。

- 防火墙策略:开放管理端口(ESXi默认443)、VMotion端口(8000)及存储心跳端口。

典型应用场景与价值体现

场景1:研发测试环境快速交付

| 痛点 | 虚拟化方案优势 | ROI提升 |

|---|---|---|

| 新项目需频繁重建系统环境 | 克隆模板可在5分钟内生成百台标准化虚拟机 | 人力成本降低70% |

| 不同开发阶段环境隔离难 | DRS可根据负载自动扩缩容,避免资源浪费 | 硬件采购延迟6个月 |

| 夜间批量测试耗时长 | 设置定时任务自动启停测试集群,结合快照实现状态回滚 | 电力支出减少45% |

场景2:生产系统混合云延伸

某电商企业在本地数据中心部署3台物理机组成的私有云,通过vCloud Director对接公有云:

- 波峰应对:大促期间将非核心业务虚拟机溢出至阿里云,本地保留数据库等关键负载。

- 灾备演练:每月自动将生产虚拟机备份至异地物理机,RTO<15分钟。

- 合规审计:通过vRealize Operations监控多物理机的资源使用率,满足等保2.0要求。

常见挑战与优化策略

| 问题类型 | 现象特征 | 根本原因 | 解决方案 |

|---|---|---|---|

| 性能抖动 | 虚拟机响应时间突增,尤其体现在数据库操作 | 跨物理机存储访问路径不稳定 | ①启用IOPS限额控制;②升级至全闪存阵列;③调整虚拟机亲和性策略 |

| 迁移失败 | VMotion过程中断,报错”Storage unavailable” | 目标主机存储链路中断或带宽不足 | ①检查光纤交换机端口状态;②临时禁用存储精简配置;③分批次迁移大型虚拟机 |

| 安全风险 | 某台物理机被载入导致整个集群沦陷 | 缺乏东西向流量隔离 | ①部署微分段防火墙;②启用VMware NSX分布式防火墙;③定期扫描镜像破绽 |

| 许可证超支 | vSphere企业版授权费用随CPU核心数线性增长 | 未合理规划资源分区 | ①按业务优先级划分资源池;②关闭闲置虚拟机;③评估改用订阅制授权模式 |

运维管理最佳实践

- 监控体系搭建:

- 使用Zabbix+Prometheus监控物理机健康状态(温度/电压/风扇转速)。

- 通过vRealize Log Insight分析日志,预警潜在故障(如内存泄漏)。

- 补丁管理:

- 建立基线镜像库,每次更新前快照备份。

- 滚动更新物理机(每次下线1台),避免集群级停机。

- 容量规划:

- 根据历史数据预测未来6个月需求,保留20%空闲资源应对突发流量。

- 淘汰连续3个月利用率<10%的老旧物理机。

相关问答FAQs

Q1: 现有5台老旧物理机能否改造成虚拟化集群?

A: 需满足三个前提:①CPU支持虚拟化扩展(可通过lscpu | grep Virtualization命令验证);②单台内存≥64GB;③配备至少2块网卡用于管理/业务分离,建议先进行压力测试:在满载情况下运行72小时,观察是否出现蓝屏或性能衰减,若硬件条件达标,可采用KVM+Ceph方案逐步替换旧设备。

Q2: 跨物理机的虚拟机备份如何解决一致性问题?

A: 推荐两种方案:①使用VMware Fault Tolerance(FT)配合SAN存储快照,适用于Oracle数据库等强一致性场景;②采用应用层静默机制(Quiesce),在备份前暂停I/O操作(如MySQL的FLUSH TABLES WITH READ LOCK),注意:普通文件级备份无法保证事务一致性,需结合业务特性