物理机迁移到阿里云

- 物理机

- 2025-08-11

- 36

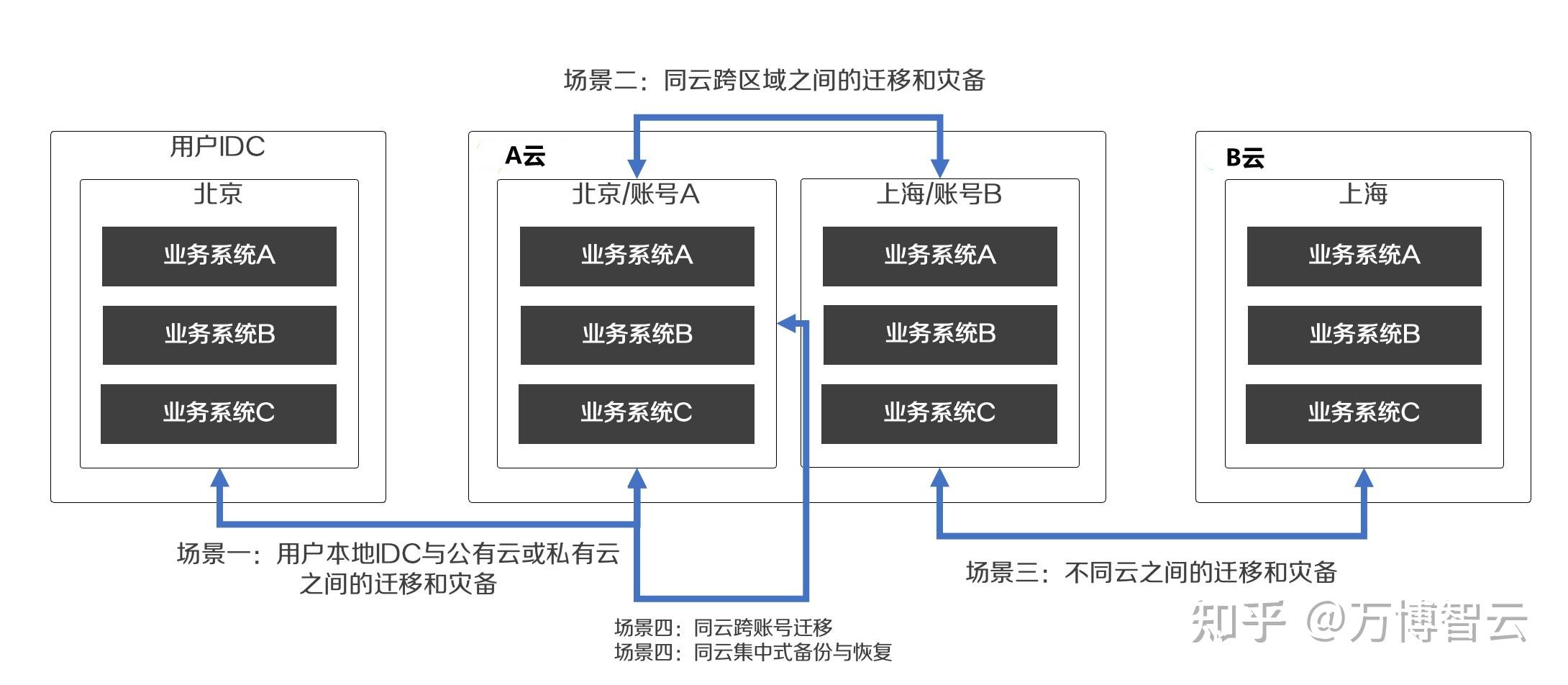

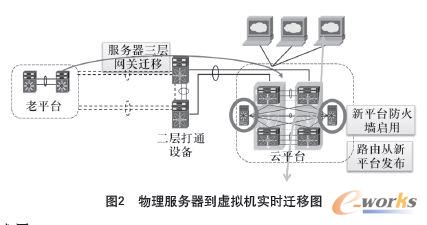

物理机迁移至阿里云是一项涉及技术架构重构、数据完整性保障及业务连续性维护的系统性工程,以下从前期准备、迁移实施、验证优化、运维衔接四大核心环节展开全流程解析,并附关键操作要点与风险控制策略。

迁移前深度准备

现状全面调研

| 调研维度 | 输出成果 | |

|---|---|---|

| 硬件信息 | CPU型号/核数、内存容量、磁盘类型(SAS/SATA)、RAID级别、网卡速率 | 硬件拓扑图 |

| 操作系统 | 版本号、补丁级别、内核参数、SSH/远程桌面访问方式 | OS兼容性分析报告 |

| 应用依赖 | 运行端口、数据库类型(MySQL/Oracle等)、中间件版本、自定义脚本路径 | 依赖关系图谱 |

| 网络架构 | IP段分配、子网掩码、默认网关、DNS服务器、防火墙规则 | 网络映射表 |

| 数据量统计 | 系统盘/数据盘总容量、增量变化率、敏感数据分类(需特殊处理的数据) | 存储需求评估报告 |

️ 重点提示:若原物理机采用非标硬件(如老旧IBM小型机),需提前确认阿里云ECS实例是否支持对应指令集(x86_64/ARM)。

目标平台选型

根据负载特征匹配阿里云产品矩阵:

| 场景 | 推荐方案 | 优势说明 |

|———————|———————————–|——————————|

| 通用型业务 | ECS突发性能实例t6/c6系列 | 成本最优,适合轻载波动场景 |

| 高并发计算 | ECS计算型c7/g7系列+ESSD云盘 | 单核性能强劲,IOPS达百万级 |

| 大数据处理 | ECS内存型r7系列+PMEM内存加速 | 内存带宽提升50%,延迟降低30% |

| 灾备容灾需求 | 跨可用区部署+OSS冷备 | RPO<1秒,RTO<5分钟 |

迁移方案设计

三种主流迁移模式对比:

| 模式 | 适用场景 | 优点 | 缺点 |

|—————|——————————|——————————-|——————————-|

| P2V冷迁移 | 允许停机窗口≥4小时 | 完整保留原系统状态 | 停机时间长,需重建引导 |

| P2V热迁移 | 业务需持续运行 | 停机时间短(约30分钟) | 需安装代理程序,部分驱动需适配|

| 新建+同步 | 对停机时间无严格要求 | 零停机风险,可渐进式切换 | 初期双轨运行增加运维复杂度 |

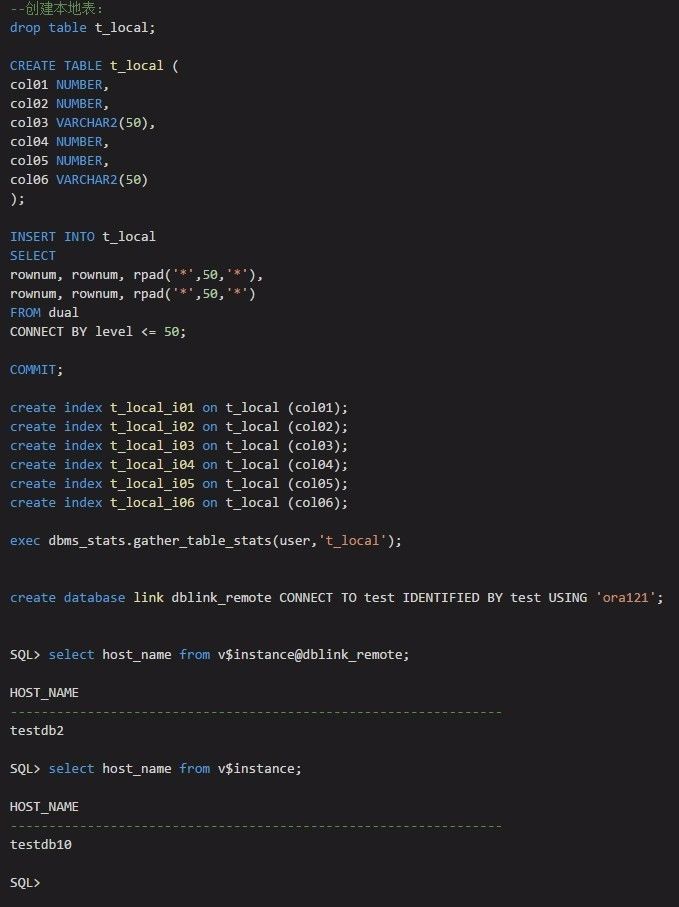

决策建议:生产环境优先采用”新建+同步”模式,通过阿里云DTS(数据传输服务)实现数据库实时同步,结合文件级增量同步工具完成最终切换。

迁移实施关键步骤

镜像制作与导入

- 工具链组合:使用阿里云提供的

aliyun ecs import-image命令行工具+第三方工具(如Veeam)生成原始磁盘镜像。 - 格式转换:将物理机的VMDK/VHD格式转换为阿里云支持的RAW/QCOW2格式,注意对齐扇区大小(推荐4KB对齐)。

- 元数据注入:通过OpenStack Nova API修改镜像属性,添加

aliyun_migration=true标签以便后续识别。

网络打通与安全组配置

| 配置项 | 操作要点 | 典型错误案例 |

|---|---|---|

| VPC规划 | 创建与原内网同网段的专有网络 | 跨网段导致ARP冲突 |

| 弹性IP绑定 | 为主网卡分配固定私网IP+公网EIP | 未释放原物理机公网导致冲突 |

| 安全组规则 | 开放原物理机所需端口(如3389/22/80) | 遗漏UDP协议导致视频流中断 |

| NAT网关设置 | 若需互联网访问,配置SNAT规则 | 源IP未转换导致连接被阻断 |

数据一致性校验

- 块设备校验:使用

dd if=/dev/sda of=/tmp/checksum.md5 bs=4M生成校验和,迁移后比对哈希值。 - 文件系统检测:执行

fsck -y /dev/vda1修复潜在文件系统错误。 - 数据库一致性:对MySQL执行

pt-table-checksum --nocheck-replication验证表数据完整性。

迁移后验证与优化

全链路压力测试

构建模拟生产环境的JMeter测试场景,重点监控:

- CPU利用率曲线:观察是否存在突发性降频(Turbo Boost失效)

- 内存交换行为:通过

vmstat 1监测si/so值,超过5MB/s需扩容 - 磁盘IOPS性能:使用fio工具测试随机读写延迟,ESSD云盘应稳定在1ms以内

性能调优实践

| 优化方向 | 具体措施 | 预期效果 |

|---|---|---|

| CPU亲和性 | taskset -c 0-7 ./app绑定物理核心 |

减少上下文切换开销 |

| NUMA架构适配 | 设置numactl --interleave=all ./app |

提升多线程程序效率 |

| 页面缓存策略 | 调整vm.swappiness=10减少无效换页 |

Swap使用率下降至10%以下 |

| 网络吞吐提升 | 启用SR-IOV技术,绑定队列到vCPU | 单流吞吐量突破10Gbps |

监控体系搭建

部署阿里云ARMS(应用实时监控)+ CloudMonitor组合方案:

- 基础监控:设置CPU>85%、内存>90%、磁盘空间>80%三级告警阈值

- 日志采集:通过Logtail收集/var/log目录下的关键日志

- 自定义指标:接入Prometheus exporter暴露业务层指标(如QPS、RT)

常见问题解决方案

Q1: 迁移后应用启动失败,报错”libc.so.6找不到”?

根本原因:新环境缺少旧系统的动态链接库版本。

解决方法:

- 在ECS实例中执行

ldconfig -p | grep libc定位缺失库文件; - 从原物理机拷贝

/lib64/libc.so.6到新系统同名路径; - 运行

ldd <可执行文件>验证依赖关系; - 更新LD_LIBRARY_PATH环境变量指向正确路径。

Q2: 数据库连接池频繁报”Too many connections”?

诊断思路:

- 检查max_connections参数是否低于业务峰值;

- 分析慢查询日志定位长事务;

- 确认连接池未关闭导致的僵尸连接累积。

优化方案:

- 调整MySQL的

wait_timeout=300和interactive_timeout=600; - 启用连接池预占机制(如HikariCP的minimumIdle=5);

- 对慢查询添加索引或拆分大事务。

归纳与建议

物理机迁移本质是基础设施的数字孪生过程,需遵循”评估-设计-测试-迁移-验证”五步法,建议采用分阶段迁移策略:首期迁移非核心模块验证方案可行性,二期逐步扩展至全业务系统,阿里云提供的迁移中心控制台可可视化管理整个迁移流程,配合专家团队远程协助,可将整体迁移风险降低70%以上,对于大型集群迁移,推荐使用阿里云混合云管理平台(HCMP)实现自动化编排