上一篇

openstack物理机管理

- 物理机

- 2025-08-07

- 22

OpenStack通过Ironic组件实现物理机管理,支持裸金属服务器纳管,提供生命周期管理、远程控制及资源调度,助力构建

OpenStack作为开源云计算平台,其核心价值之一在于通过统一接口实现对异构资源的抽象化管理,在传统虚拟化资源(VM)之外,物理机管理能力是企业级混合云部署的关键需求,尤其适用于大数据、AI训练、数据库等对性能敏感且需直接访问硬件的场景,以下从技术原理、核心组件、操作实践、运维要点四个维度展开深度解析。

物理机管理的技术定位与价值

| 特性 | 虚拟化方案 | OpenStack物理机管理 |

|---|---|---|

| 资源隔离性 | 依赖Hypervisor模拟 | 完全独占物理CPU/内存/存储 |

| 性能损耗 | 存在约5%-20%开销 | 零损耗,直接调用硬件能力 |

| 适用场景 | 通用业务负载 | 高性能计算、实时数据分析等 |

| 管理复杂度 | 标准化模板化部署 | 需适配多厂商硬件差异 |

| 故障恢复机制 | 快照+迁移 | 依赖底层RAID/HBA卡冗余 |

该功能通过Ironic项目实现,其设计目标是将物理服务器纳入OpenStack的统一资源池,提供与虚拟机一致的生命周期管理能力(创建/启动/停止/销毁),同时保留物理设备的完整性能优势。

核心组件与交互流程

关键服务模块

| 组件名称 | 功能描述 | 依赖关系 |

|---|---|---|

| Ironic API | 接收Nova调度器的请求,执行物理机实例化操作 | 必须前置部署 |

| Conductor | 协调各节点间的操作,生成配置文件并下发至目标节点 | 单点故障风险,建议集群化部署 |

| Provisioner | 实际执行PXE引导、RAID配置、操作系统安装等底层操作 | 需预装对应厂商的工具包 |

| Inspector | 硬件健康检查,收集CPU/内存/磁盘/网卡等信息生成库存清单 | 决定节点是否可加入资源池 |

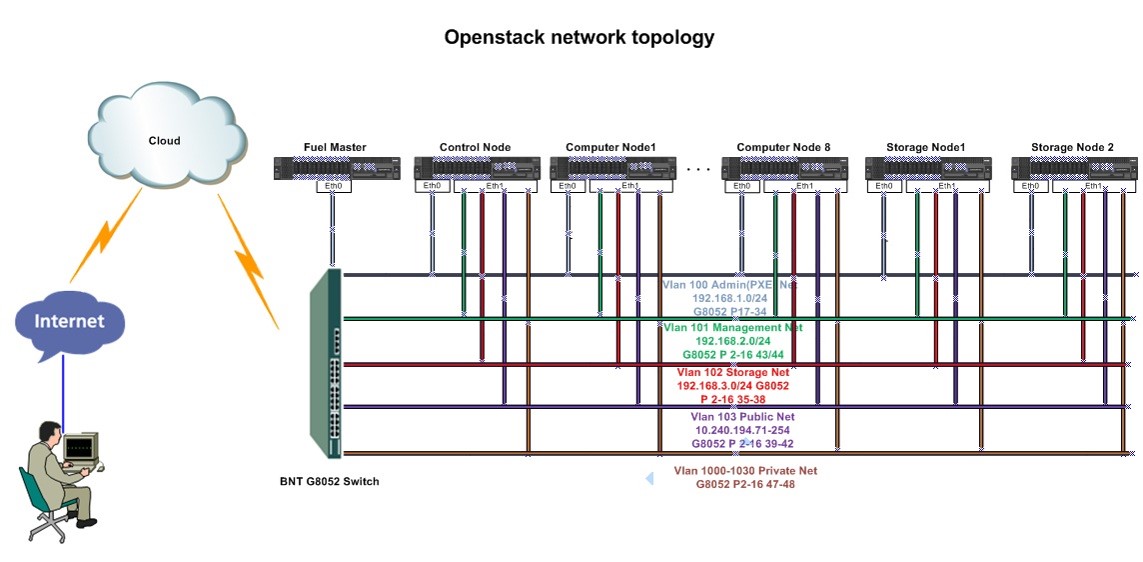

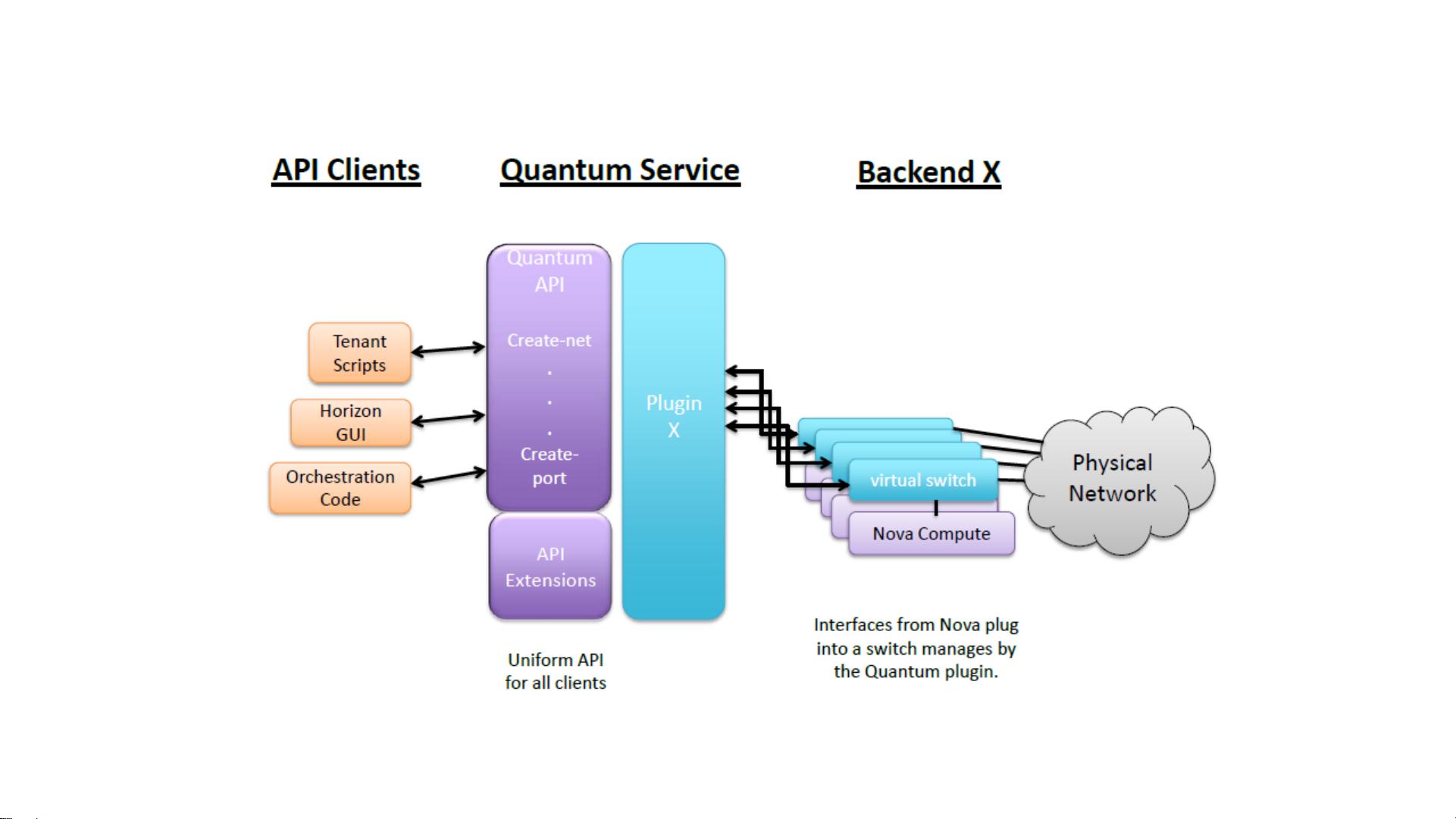

| Neutron ML2 | 为物理机分配VLAN/IP地址,实现与虚拟网络的互通 | 需配合OpenDaylight插件 |

典型交互流程

- 节点纳管:管理员通过

baremetal node create命令注册物理服务器,触发Inspector自动采集硬件信息; - 画像匹配:根据收集的硬件特征(如BMC IP、固件版本)匹配预定义的Driver配置文件;

- 实例化准备:Conductor生成定制化部署脚本,包含RAID划分策略、镜像URL、网络配置等;

- PXE启动:Provisioner唤醒目标节点,通过TFTP加载内核+initrd,执行自动化安装;

- 接入网络:Neutron为物理机分配端口,完成与虚拟网络的互通;

- 状态同步:最终状态更新至Heat Orchestration Service,供Nova调度器调用。

实施关键步骤详解

环境准备阶段

- 硬件要求:支持IPMI/iDRAC/Redfish等带外管理接口,BIOS开启PXE启动;

- 存储规划:推荐使用LVM逻辑卷管理,避免直接操作物理磁盘;

- 镜像准备:需制作专用部署镜像(含Cloud-Init配置),支持UEFI/BIOS双模式;

- 驱动适配:针对不同厂商(Dell/HPE/Lenovo)加载相应Out-of-Band Management驱动。

节点注册示例(命令行)

# 查看可用节点

openstack baremetal node list

# 创建新节点(指定MAC地址和BMC凭证)

openstack baremetal node create --driver <vendor>

--pmaddress <bmc_ip> --pmusername admin --pmpassword password

--pxe-enabled true my-physical-node

# 验证节点状态

openstack baremetal node show my-physical-node

特殊配置场景

| 场景 | 解决方案 |

|---|---|

| 多块磁盘合并 | 使用disk-mode=mergero参数,将多块磁盘合并为单个逻辑设备 |

| 保留原有RAID配置 | 在Driver配置中设置preserve_raid=true,跳过自动RAID初始化 |

| 自定义Partition Table | 通过root_gb=50, swap_mb=8192等参数精确控制分区大小 |

| 安全启动(Secure Boot) | 启用secure_boot=true并上传签名过的Shim/Mokern文件至Glance |

运维管理要点

日常监控指标

| 监控项 | 阈值建议 | 异常处理建议 |

|---|---|---|

| CPU温度 | >85℃持续5分钟 | 检查散热系统,必要时降频运行 |

| BMC会话数 | 同时连接>3个客户端 | 限制非规访问,启用双因素认证 |

| 磁盘SMART状态 | 出现Reallocated Sectors | 立即更换故障盘,重建RAID阵列 |

| PDU功率 | 超过额定80% | 优化负载分布,避免过载保护触发 |

故障排查工具链

- 日志分析:

/var/log/ironic/目录下存放详细日志,重点关注conductor.log; - 串口调试:通过

ironic console log命令获取实时输出; - 硬件自检:执行

racadm getsyssel(Dell)/hponcfg -i(HPE)查看硬件日志; - 网络连通性测试:使用

neutron port-list确认端口绑定状态。

版本升级注意事项

- 兼容性矩阵:严格对照OpenStack官方文档,确认Ironic版本与Nova/Neutron的兼容关系;

- 回滚方案:升级前创建完整备份(包括数据库和配置文件);

- 功能验证:重点测试PXE启动、RAID重组、固件升级等关键功能。

最佳实践建议

- 硬件同质化:尽量选择同一厂商的服务器型号,减少驱动适配工作量;

- 带外管理独立组网:将BMC接口划入专用VLAN,与业务网络物理隔离;

- 自动化巡检:结合Ansible Playbook定期执行硬件健康检查;

- 容量规划:预留20%的物理机资源用于应急扩容;

- 灾备方案:重要物理机采用主备双活架构,避免单点故障。

相关问答FAQs

Q1: 物理机无法通过PXE启动如何处理?

A: 按以下顺序排查:①确认BIOS已启用PXE且设置为第一启动项;②检查DHCP服务是否正常分配临时IP;③验证TFTP服务器能否成功传输引导文件;④查看/var/log/ironic/provisioner.log中的详细错误日志,常见原因是防火墙阻断了TFTP端口(默认69)或MTU设置不匹配。

Q2: 如何实现物理机的动态迁移?

A: OpenStack原生不支持物理机的热迁移,但可通过以下变通方案实现:①使用共享存储(如Ceph RBD)将数据盘挂载到不同节点;②结合Liveness Probe定期检测服务状态;③手动执行停机→迁移→启动流程,对于真正的无缝迁移需求,建议采用KVM虚拟