物流数据库怎么做

- 数据库

- 2025-08-07

- 20

物流数据库的建设是支撑现代供应链高效运转的核心基础设施,其设计需兼顾业务复杂性、数据实时性和系统扩展性,以下从需求分析→概念建模→逻辑设计→物理实现→安全与优化五大环节展开详细阐述,并提供完整实施方案。

需求分析:明确业务场景与数据边界

物流业务涉及多主体协同(货主/承运商/仓储方)、多环节流转(采购→入库→分拣→运输→配送→签收),需重点解决以下痛点:

| 业务场景 | 数据需求 | 典型查询示例 |

|——————-|————————————————————————–|———————————-|

| 订单全流程追踪 | 订单号、商品SKU、发货/到货时间、地理位置坐标、运输状态 | “查询某订单当前所在位置及预计送达时间” |

| 库存动态管理 | 仓库编码、库区/货架位、库存数量、效期、出入库流水号 | “统计A仓库近7天红酒类商品的出库量” |

| 运输资源调度 | 车辆牌照、司机信息、载重/容积限制、当前任务状态、历史行驶里程 | “筛选可用且距离最近的3辆冷藏车执行紧急订单” |

| 费用结算 | 运费单价、附加费规则(超区/夜间)、实际重量/体积、付款周期 | “计算某笔运输订单的总费用明细” |

| 异常事件追溯 | 破损记录、延误原因、责任方判定依据、理赔进度 | “调取上周所有因交通堵塞导致的延误记录” |

关键上文归纳:需建立跨时空维度的数据关联能力,支持从单笔订单到全局网络的多层级分析。

概念模型设计:构建实体关系图谱

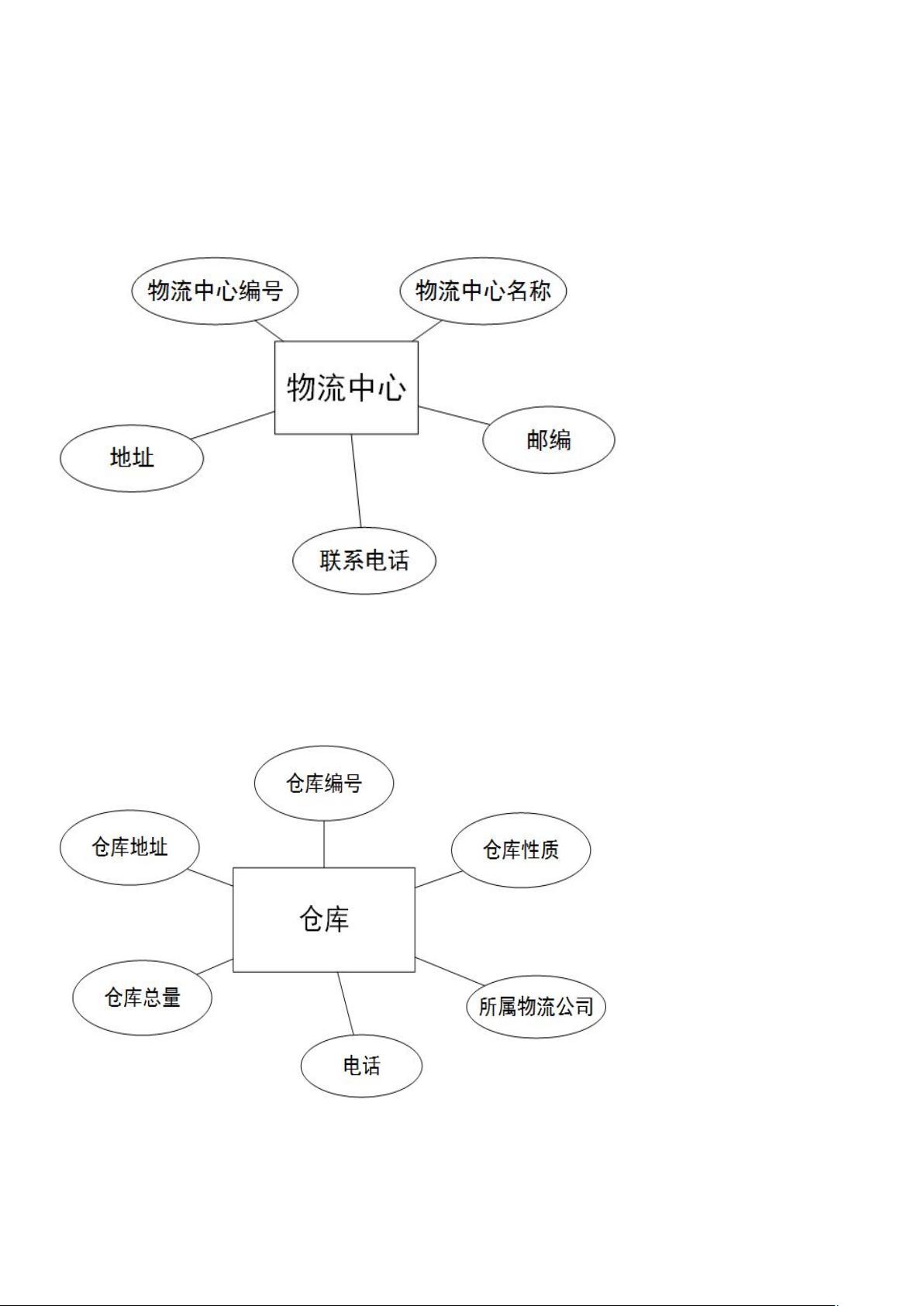

基于上述需求,提炼出以下核心实体及关系:

实体清单与属性示例

| 实体名称 | 核心属性 | 备注 |

|---|---|---|

| 客户 | 客户ID(PK), 企业名称, 联系人, 信用等级, 结算方式 | 区分B端/C端客户 |

| 订单 | 订单ID(PK), 客户ID(FK), 下单时间, 总金额, 订单状态, 优先级 | 状态枚举:待处理/已分配/运输中/已完成/取消 |

| 货物 | 货物ID(PK), 订单ID(FK), SKU编码, 名称, 数量, 重量, 体积, 特殊要求 | 支持拆分合并操作 |

| 仓库 | 仓库ID(PK), 地址, 负责人, 存储类型(常温/冷链/危险品), 最大容量 | 关联GIS坐标系 |

| 运输任务 | 任务ID(PK), 订单ID(FK), 车辆ID(FK), 司机ID(FK), 出发地, 目的地, 计划时间, 实际时间 | 记录路径规划结果 |

| 车辆 | 车辆ID(PK), 车牌号, 车型, 载重, 容积, 购置日期, 维保记录 | 绑定GPS设备编号 |

| 司机 | 司机ID(PK), 姓名, 驾驶证号, 联系方式, 服务评分, 排班表 | 关联人脸识别信息 |

| 费用规则 | 规则ID(PK), 计费类型(按吨/按件/阶梯价), 基础费率, 生效日期 | 支持动态调价策略 |

关键关系说明

- 一对多:1个客户可创建N个订单 →

客户.客户ID↔订单.客户ID - 多对一:N个货物属于1个订单 →

货物.订单ID↔订单.订单ID - 多对多:1个仓库可存放多种货物,1种货物可存入多个仓库 → 需通过中间表

库存明细实现 - 强约束:运输任务必须关联有效车辆+持相应驾照的司机 →

运输任务.车辆ID+运输任务.司机ID需满足资质校验

逻辑设计:规范化表结构与约束

遵循第三范式(3NF)消除数据冗余,以下是部分关键表的DDL示例:

表1:订单主表

CREATE TABLE `orders` (

order_id BIGINT PRIMARY KEY AUTO_INCREMENT,

customer_id BIGINT NOT NULL,

order_date TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

total_amount DECIMAL(18,2) NOT NULL,

status ENUM('pending','assigned','in_transit','completed','cancelled') DEFAULT 'pending',

priority TINYINT UNSIGNED, -1-5级,数字越小优先级越高

FOREIGN KEY (customer_id) REFERENCES customers(customer_id) ON DELETE RESTRICT,

INDEX idx_status (status),

INDEX idx_priority (priority)

) ENGINE=InnoDB;

表2:货物明细表(含拆分逻辑)

CREATE TABLE `cargo_items` (

item_id BIGINT PRIMARY KEY AUTO_INCREMENT,

order_id BIGINT NOT NULL,

sku_code VARCHAR(50) NOT NULL,

product_name VARCHAR(255) NOT NULL,

quantity INT NOT NULL,

unit_weight DECIMAL(10,3) NOT NULL, -单件重量(kg)

unit_volume DECIMAL(10,3) NOT NULL, -单件体积(m³)

special_requirements JSON, -存储温度/防震等要求

FOREIGN KEY (order_id) REFERENCES orders(order_id) ON DELETE CASCADE,

CHECK (quantity > 0),

CHECK (unit_weight > 0),

CHECK (unit_volume > 0)

) ENGINE=InnoDB;

表3:运输任务表(时空关联)

CREATE TABLE `transport_tasks` (

task_id BIGINT PRIMARY KEY AUTO_INCREMENT,

order_id BIGINT NOT NULL,

vehicle_id BIGINT NOT NULL,

driver_id BIGINT NOT NULL,

departure_location POINT NOT NULL, -GEOMETRY类型存储起点坐标

destination_location POINT NOT NULL, -GEOMETRY类型存储终点坐标

planned_departure TIMESTAMP NOT NULL,

actual_departure TIMESTAMP,

planned_arrival TIMESTAMP NOT NULL,

actual_arrival TIMESTAMP,

route_path LINESTRING, -存储实际行驶路径

FOREIGN KEY (order_id) REFERENCES orders(order_id) ON DELETE CASCADE,

FOREIGN KEY (vehicle_id) REFERENCES vehicles(vehicle_id) ON DELETE RESTRICT,

FOREIGN KEY (driver_id) REFERENCES drivers(driver_id) ON DELETE RESTRICT,

SPATIAL INDEX idx_route (route_path) -空间索引加速路径查询

) ENGINE=InnoDB;

设计要点:

- 时间戳精度:所有时间字段使用

TIMESTAMP而非DATE,精确到秒级记录操作时序 - 地理空间支持:采用MySQL的

SPATIAL扩展或PostGIS,实现路径规划、距离计算等空间查询 - 软删除机制:对敏感数据(如客户信息)增加

is_deleted标记而非物理删除,保留审计痕迹 - 枚举类型约束:使用

ENUM限制状态字段取值范围,避免脏数据 - JSON字段扩展:将非结构化的特殊要求(如温控参数)存入JSON列,保持灵活性

物理实现:高性能存储方案

数据库选型建议

| 场景特征 | 推荐方案 | 优势说明 |

|---|---|---|

| 高并发写操作 | TiDB/OceanBase | 分布式架构,水平扩展能力强,适合瞬秒/抢单场景 |

| 复杂事务处理 | PostgreSQL | 支持事务完整性,JSON函数丰富,适合财务对账等场景 |

| 海量历史数据分析 | ClickHouse | 列式存储,OLAP分析性能优异,适合月度经营报表生成 |

| 混合负载(TP+AP) | PolarDB/Greenplum | 一栈式处理OLTP+OLAP,减少ETL同步延迟 |

核心优化策略

- 分库分表:按

customer_id % N进行哈希分库,按order_date范围分表(如每月一张表) - 索引策略:

- 组合索引:

(order_id, status)→ 快速定位特定订单的状态变更历史 - 覆盖索引:对频繁查询的

SELECT order_id, customer_id, total_amount FROM orders建立复合索引 - 反向索引:为

driver_id建立倒排索引,快速查找某司机的所有任务

- 组合索引:

- 冷热分离:将超过3个月的冷数据迁移至低成本存储(如OSS+Parquet格式),热数据保留在SSD阵列

- 读写分离:主库处理写入,从库承担读取请求,通过Canal实现毫秒级延迟同步

数据同步机制

- 实时同步:使用Debezium监听MySQL Binlog,将变更推送至Kafka,供下游系统(WMS/TMS)消费

- 批量同步:每日定时通过DataX将增量数据同步至数据仓库,用于BI分析

- 冲突解决:采用乐观锁机制,通过

version字段检测并发修改,返回”数据已更新,请重新提交”提示

安全与运维保障

权限管理体系

| 角色 | 可访问资源 | 操作权限 |

|---|---|---|

| 普通员工 | 本人负责的订单/任务 | CRUD(仅限自己创建的数据) |

| 部门主管 | 本部门所有数据 | R+U(审核/驳回权限) |

| 系统管理员 | 全量数据 | R+U+D(禁止删除核心元数据) |

| 审计员 | 所有日志记录 | R(仅查看,不可修改) |

数据安全措施

- 加密传输:TLS 1.3协议保障客户端-数据库通信安全

- 脱敏处理:对手机号显示

1381234,银行卡号显示6228123 - 备份策略:每日全量备份+每小时增量备份,异地容灾备份保留30天

- 审计日志:记录所有DML操作的用户IP、时间戳、旧值/新值对比,保留180天

监控告警体系

- 性能指标:QPS>1000时触发扩容预警,慢查询日志(>500ms)实时推送至钉钉群

- 健康检查:每分钟检测主从库同步延迟,超过3秒自动切换至备库

- 容量规划:当磁盘使用率>80%时,提前7天发送扩容通知

实施路线图

| 阶段 | 时间周期 | 主要任务 | 交付物 |

|---|---|---|---|

| 需求调研 | 2周 | 访谈业务部门收集痛点,绘制AS-IS流程图 | 《需求规格说明书》 |

| 概念设计 | 3周 | 输出ER图、实体关系矩阵、关键业务流程图 | 《概念数据模型报告》 |

| 逻辑设计 | 4周 | 编写DDL脚本、建立数据字典、设计接口文档 | 《逻辑设计文档》《API手册》 |

| 开发测试 | 8周 | 搭建开发环境、编写单元测试用例、完成联调测试 | 《测试报告》《部署手册》 |

| 上线部署 | 1周 | 灰度发布、压力测试、用户培训 | 《上线验收报告》 |

| 运维优化 | 持续 | 监控调优、版本迭代、应急演练 | 《运维SOP》《优化记录》 |

相关问答FAQs

Q1: 如何处理物流过程中产生的海量实时数据?

A: 采用”边缘计算+中心云”架构:①在车载终端部署轻量化数据库(如SQLite),暂存GPS坐标、温湿度等实时数据;②通过MQTT协议将数据批量上传至云端Kafka集群;③使用Flink进行流式处理,实时更新运输状态并触发异常告警;④最终持久化至主数据库,该方案可将单日千万级数据写入延迟控制在200ms以内。

Q2: 当出现跨仓库调拨时,如何保证库存数据的一致性?

A: 实施分布式事务解决方案:①通过Seata框架管理跨库事务;②调拨单创建时锁定涉及仓库的库存记录;③执行库存扣减/增加操作;④若任一环节失败则整体回滚;⑤最终通过异步补偿机制确保最终一致性,同时建立库存校验规则:调拨前后各仓库库存总和必须相等,差异超过阈值