java开发完成后怎么测试

- 后端开发

- 2025-08-07

- 18

在Java项目开发完成后,全面而系统的测试是保障软件质量、稳定性和可靠性的核心环节,以下从测试阶段划分、具体实施方法、工具链整合、关键注意事项四个维度进行详细说明,并提供可落地的操作指南。

测试阶段分层与核心目标

| 测试类型 | 核心目标 | 典型执行者 | 触发条件 |

|---|---|---|---|

| 单元测试 | 验证最小代码单元的正确性 | 开发人员 | 编码完成后立即执行 |

| 集成测试 | 检测模块间交互逻辑的正确性 | 开发人员/测试人员 | 单元测试通过后 |

| 系统测试 | 验证完整系统的功能与需求一致性 | 专职测试人员 | 集成测试通过后 |

| 验收测试 | 确认系统满足业务方预期 | 产品经理/客户代表 | 系统测试通过后 |

| 回归测试 | 确保新增功能未破坏原有功能 | 自动化测试工程师 | 每次代码变更后 |

| 性能/压力测试 | 评估系统在极端负载下的表现 | 性能测试专家 | 版本冻结前 |

| 安全测试 | 发现潜在破绽与风险点 | 安全工程师 | 上线前必测 |

分阶段深度解析与操作实践

单元测试(Unit Testing)——地基工程

核心价值:以最低成本捕捉70%以上的缺陷,强制开发者编写高质量代码。

实施要点:

- 粒度控制:针对单个方法或类编写测试用例,避免跨模块依赖,例如对

UserService.login()方法单独测试,而非整个登录流程。 - 断言策略:使用

assertEquals(expected, actual)时注意类型匹配,推荐优先使用assertTrue(condition)等显式断言。 - 异常分支覆盖:必须包含参数校验失败、数据库连接中断等异常场景的测试。

- 覆盖率要求:主业务逻辑代码行覆盖率≥80%,关键算法需达到100%。

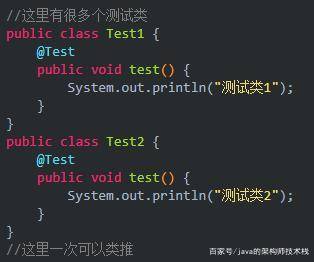

工具组合方案:

| 工具名称 | 用途 | 优势特点 |

|—————-|—————————–|——————————|

| JUnit 5 | 基础测试框架 | 支持重复执行、参数化测试 |

| Mockito | 模拟外部依赖 | 轻松mock静态方法/私有成员 |

| PowerMock | 增强型mock框架 | 处理final类/静态构造函数 |

| JaCoCo | 代码覆盖率统计 | 生成HTML格式详细报告 |

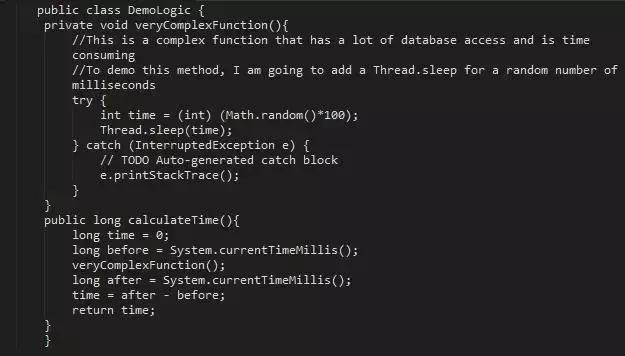

示例代码片段:

@ExtendWith(MockitoExtension.class)

class OrderServiceTest {

@Mock private PaymentGateway paymentGateway;

@InjectMocks private OrderService orderService;

@Test

void processPayment_Success() throws Exception {

// 准备测试数据

OrderDTO order = new OrderDTO();

order.setAmount(100.0);

// 配置mock行为

when(paymentGateway.charge(any())).thenReturn(new ChargeResult(true));

// 执行被测方法

ProcessResult result = orderService.processPayment(order);

// 验证结果

assertTrue(result.isSuccess());

verify(paymentGateway).charge(eq(100.0)); // 验证精确调用参数

}

}

集成测试(Integration Testing)——管道联通

️ 常见误区:仅关注接口是否正常调用,忽视数据流完整性验证。

️ 有效做法:

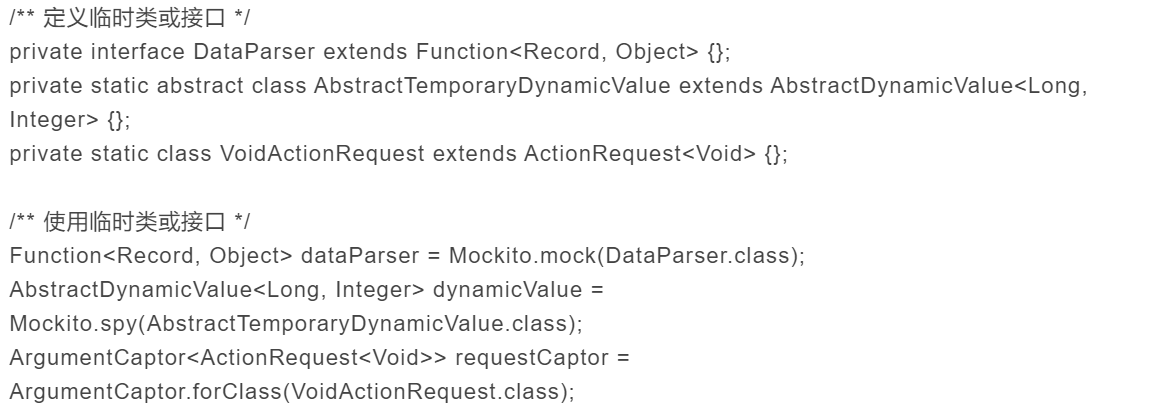

- 契约测试:使用Pact框架定义服务间API契约,确保前后端数据格式完全一致。

- 文件系统交互:当涉及本地文件读写时,使用

TemporaryFolder规则创建临时目录进行真实文件操作测试。 - 数据库集成:采用内存数据库H2替代生产库,通过

@DataJpaTest注解实现Spring Data JPA的快速集成测试。 - 消息队列验证:对于Kafka/RabbitMQ等异步通信,需验证消息发送顺序、重试机制及死信队列处理。

系统测试(System Testing)——全景扫描

重点考察维度:

- 功能完整性:对照需求文档逐条验证,特别关注边界值处理(如最大订单数、最小金额等)。

- 跨浏览器兼容:使用BrowserStack平台测试主流浏览器(Chrome/Firefox/Edge)的不同版本。

- 移动端适配:通过Appium自动化测试Android/iOS真机,验证响应式布局和触摸事件。

- 国际化支持:检查多语言字符编码、日期格式转换、货币符号显示是否正确。

性能测试(Performance Testing)——压力极限

️ 标准流程:

- 基线测定:使用JMeter录制正常业务流作为基准脚本。

- 并发加压:逐步增加虚拟用户数(建议从100→500→1000递增),监控TPS(每秒事务数)变化曲线。

- 瓶颈定位:结合VisualVM分析CPU热点方法,用Arthas进行线上Profiler排查慢SQL。

- 调优验证:优化缓存策略后重新压测,对比响应时间缩短比例。

关键指标参考表:

| 指标类型 | 金融系统要求 | 电商系统要求 | 普通后台系统 |

|—————-|————-|————-|————-|

| 平均响应时间 | <2s | <3s | <5s |

| 峰值QPS | ≥1000 | ≥2000 | ≥500 |

| 错误率 | <0.1% | <0.5% | <1% |

安全测试(Security Testing)——攻防演练

必查项清单:

- 注入攻击防护:SQL注入(如

' OR 1=1--)、XSS跨站脚本(<script>alert(1)</script>)。 - 权限控制:越权访问测试(普通用户尝试访问管理员接口)、水平越权(修改URL参数查看他人数据)。

- 加密传输:强制HTTPS,禁用弱加密套件(TLSv1.3+)。

- 日志审计:敏感操作(删除/修改)必须记录操作人IP、时间戳及具体内容。

自动化测试体系构建

持续集成流水线配置示例(基于GitLab CI):

stages:

test

performance

security

unit_test:

stage: test

script:

mvn test -Dmaven.test.failure.ignore=false # 不允许测试失败

jacoco:report # 生成覆盖率报告

integration_test:

stage: test

script:

mvn verify -Pintegration-tests # 执行集成测试Profile

performance_test:

stage: performance

script:

jmeter -n -t load_test.jmx -l results.jtl # 执行JMeter脚本

taurus -v results.jtl # 生成可视化报告

security_scan:

stage: security

script:

trivy image --format json --output security_report.json your-image:latest # 容器镜像扫描

bandit -r src/main/java/ # Python风格安全检查(适用于混合栈项目)

容易被忽视的关键细节

- 环境一致性:Docker容器化部署测试环境,消除”在我机器上能跑”的问题。

- 测试数据管理:使用Faker库生成真实感强的测试数据,避免硬编码敏感信息。

- 日志分级:DEBUG级别日志仅在本地开启,生产环境关闭以避免日志轰炸。

- 滚动快照:每次构建生成唯一版本号,便于快速回溯问题版本。

- 探索性测试:预留10%-15%时间进行无脚本的自由测试,往往能发现意外缺陷。

相关问答FAQs

Q1: 为什么明明通过了所有单元测试,系统上线后还是出现严重BUG?

A: 主要原因包括:① 单元测试未覆盖复杂业务逻辑分支(如促销活动叠加规则);② 集成测试缺失导致模块间数据不一致;③ 环境差异(开发环境与生产环境配置不同),解决方案:建立分层测试体系,强制要求集成测试覆盖率≥60%,并引入混沌工程(Chaos Monkey)主动制造故障验证系统健壮性。

Q2: 如何处理大量重复性的回归测试工作?

A: 推荐采用Page Object模式构建UI自动化测试框架,配合Selenium Grid实现分布式执行,对于API测试,使用Postman Collection转Newman命令行工具,集成到CI/CD流水线中自动执行,某电商平台实践表明,通过自动化回归测试可将迭代周期从7天缩短至2天,人力投入减少