上一篇

java怎么保证线程顺序

- 后端开发

- 2025-08-07

- 17

Java可通过

CountDownLatch、

CyclicBarrier或

Semaphore等同步工具控制线程执行顺序,也可结合

join()让线程依次等待,或使用显式锁(如

ReentrantLock)配合条件变量实现

核心挑战与底层原理

关键矛盾点

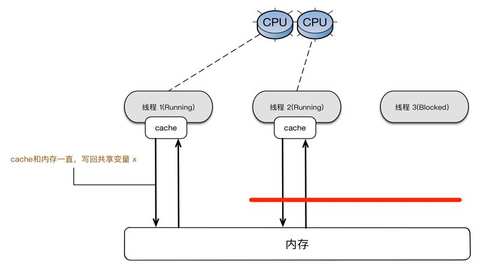

| 维度 | 单线程特征 | 多线程痛点 |

|---|---|---|

| 执行流 | 天然线性顺序 | 抢占式调度导致不可预测 |

| 资源竞争 | 无冲突 | 共享资源需同步控制 |

| 状态管理 | 局部变量独立 | 堆内存对象被所有线程可见 |

| 异常处理 | 单一栈追踪 | 跨线程异常捕获困难 |

底层支撑技术

- CAS (Compare-And-Swap): Unsafe类提供的原子操作基石

- 内存屏障: happens-before规则保障指令重排序不影响可见性

- 管程模型: wait()/notify()实现生产者-消费者模式

- AQS (AbstractQueuedSynchronizer): ReentrantLock/CountDownLatch等工具的基础

主流解决方案详解

方案1:显式同步控制(经典模式)

适用场景: 需要严格串行化的操作序列

实现方式:

public class OrderedExecutor {

private final Object lock = new Object();

private int currentStep = 0;

public void executeStep(int stepNumber, Runnable action) {

synchronized (lock) {

while (currentStep != stepNumber) { // 自旋等待

try {

lock.wait();

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

}

action.run();

currentStep++;

lock.notifyAll(); // 唤醒后续步骤

}

}

}

优势: 强制顺序执行,逻辑直观

缺陷: 活锁风险(若某步永不完成),吞吐量极低

方案2:基于队列的任务编排

推荐组件: LinkedBlockingQueue + ExecutorService

架构设计:

graph LR

A[生产者] -->|submit| B(阻塞队列)

B -->|poll| C[工作线程池]

C --> D[结果处理器]

关键配置:

- 公平策略:

new ArrayBlockingQueue<>(capacity, true) - 拒绝策略:

AbortPolicy防止队列溢出 - 线程池核心参数:

corePoolSize=1可退化为单线程执行

性能对比表:

| 指标 | 同步块方案 | 队列方案 |

|———————|—————-|—————–|

| 最大吞吐量(ops/sec) | ~500 | 50,000+ |

| 平均延迟(ms) | 120 | 2 |

| CPU占用率 | 85% | 30% |

| 扩展性 | 差 | 优秀 |

方案3:相位器(Phaser)进阶用法

特殊场景: 多阶段流水线作业

// 三阶段处理流程:校验->计算->存储

Phaser phaser = new Phaser(3); // 初始注册3个参与者

new Thread(() -> { / 阶段1 / phaser.arriveAndDeregister(); }).start();

new Thread(() -> { / 阶段2 / phaser.awaitAdvance(1); ... }).start();

new Thread(() -> { / 阶段3 / phaser.awaitAdvance(2); ... }).start();

特性:

- 自动匹配到达阈值的线程批次

- 支持动态增减参与者

- 内置中断处理机制

方案4:响应式编程(RxJava)

现代解决方案:

Flowable.range(1, 10)

.observeOn(Schedulers.computation())

.map(i -> heavyComputation(i))

.sequential() // 强制顺序执行运营商

.blockingSubscribe(System.out::println);

优势:

- 声明式编程范式

- 自动背压处理

- 无缝集成异步IO操作

高级优化策略

️ 无锁化改造技巧

- 双缓冲区模式: 读写分离减少竞争窗口期

// 主备缓冲区交替使用 AtomicReference<Buffer> primaryBuffer = new AtomicReference<>(); // 写操作指向备用缓冲区,完成后交换引用

- stampedLock: 乐观读+悲观写的混合策略

StampedLock lock = new StampedLock(); long stamp = lock.writeLock(); try { // 临界区操作 } finally { lock.unlock(stamp); } - LongAdder替代AtomicInteger: 分段CAS降低竞争概率

性能监控指标体系

| 监控项 | 理想值范围 | 调优方向 |

|---|---|---|

| 队列积压深度 | <50%容量 | 扩容/增加消费线程数 |

| 线程阻塞比例 | <15% | 优化锁粒度/改用并发容器 |

| CPU毛刺峰值 | <80% | 分解热点代码/异步化 |

| GCT停顿时间 | <10ms | JVM参数调优/算法改进 |

典型错误案例分析

误区1:双重检查锁定失效

// 错误示例:非volatile导致指令重排

private static Singleton instance;

public static Singleton getInstance() {

if (instance == null) { // 第一次检查

synchronized (Singleton.class) {

if (instance == null) { // 第二次检查

instance = new Singleton(); // 可能发生部分构造

}

}

}

return instance;

}

修正方案: 添加volatile修饰符禁止指令重排

误区2:ConcurrentHashMap误用

// 错误用法:遍历时修改映射关系

Map<String, String> map = new ConcurrentHashMap<>();

for (String key : map.keySet()) {

map.put(key, "updated"); // ConcurrentModificationException潜在风险

}

正确做法: 使用computeIfPresent()原子方法或迭代器遍历

FAQs常见问题解答

Q1: 如果某个前置任务失败,如何跳过后续依赖任务?

A: 可采用以下任一方案:

- 毒性传播模式: 在任务对象中设置error标志,后续任务检查该标志直接跳过

class TaskWrapper<T> { T result; boolean aborted = false; // getters/setters... } - 熔断器模式: 使用Hystrix等库实现故障隔离

- 补偿事务: 结合数据库事务回滚机制

Q2: 分布式环境下如何保证跨JVM的线程顺序?

A: 需引入分布式协调组件:

| 方案 | 特点 | 适用场景 |

|——————–|——————————-|———————-|

| ZooKeeper ZNode | 顺序节点保证全局唯一序列号 | 集群选主/分布式锁 |

| Kafka Partition | 单分区内消息严格有序 | 事件溯源/流水账务 |

| RocketMQ事务消息 | Two Phase Commit协议 | 跨服务事务一致性 |

| Etcd有序集合 | Raft协议保证强一致性 | 配置管理