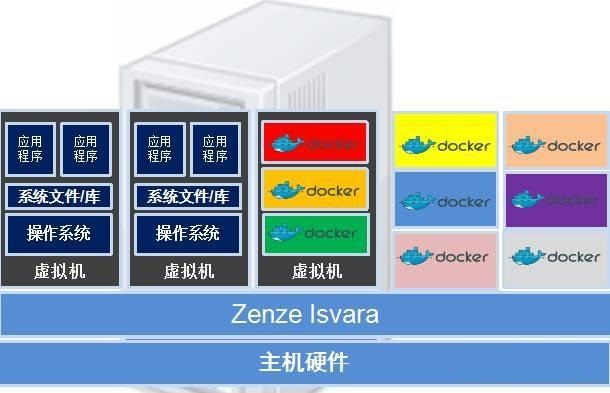

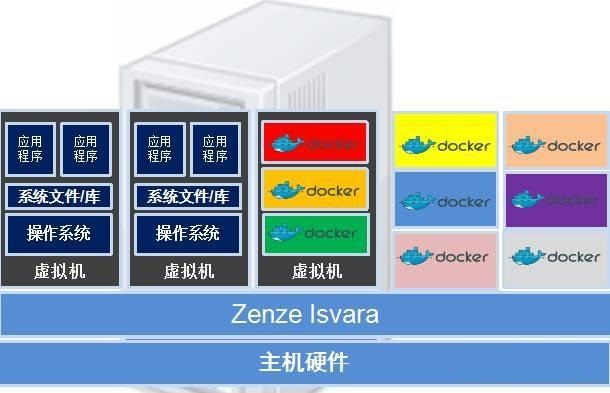

共享主机内核,轻量高效;虚拟主机具独立操作系统,资源隔离强,适合不同应用场景。

架构原理差异

| 特性 |

容器 |

虚拟主机(虚拟机) |

| 底层技术 |

基于命名空间(Namespaces)和控制组(cgroups)实现资源隔离 |

依赖Hypervisor层模拟完整硬件环境(如CPU、内存、网卡等) |

| OS内核共享性 |

所有容器共用宿主机的同一个Linux内核 |

每个VM拥有独立的Guest OS内核,完全独立运行 |

| 启动速度 |

秒级启动(仅需加载应用及依赖库) |

分钟级启动(需初始化整个操作系统) |

| 镜像大小 |

通常几MB到几百MB(仅包含必要组件) |

普遍数GB以上(含完整操作系统基础架构) |

资源利用率对比

| 指标 |

容器 |

虚拟主机 |

| CPU开销 |

接近原生性能损耗(≈1%-3%) |

因Hypervisor调度产生额外延迟 |

| 内存占用 |

无冗余OS进程,直接映射宿主机物理内存 |

每个VM需预留独立内存给Guest OS |

| 存储效率 |

分层叠加的文件系统支持快速部署与更新 |

全盘镜像复制导致存储冗余度高 |

| 并发密度 |

单台物理机可承载成百上千个轻量级容器实例 |

受限于硬件规格,一般部署几十台VM |

隔离性与安全性

| 维度 |

容器 |

虚拟主机 |

| 进程隔离 |

PID命名空间隔离,但存在内核级突破风险 |

MMU硬件级分页保护,进程间完全沙箱化 |

| 网络栈模拟 |

veth虚拟网卡实现桥接模式 |

Tap设备直连虚拟交换机,支持复杂路由策略 |

| 安全加固成本 |

需配合Seccomp/AppArmor等策略限制危险系统调用 |

天然具备强隔离特性,适合多租户环境 |

| 破绽影响范围 |

单个容器逃逸可能危及整个宿主机 |

VM间的攻击面局限于特定端口暴露 |

移植性与标准化

| 场景 |

容器 |

虚拟主机 |

| 跨云迁移 |

OCI标准镜像可在任意支持Docker的环境无缝运行 |

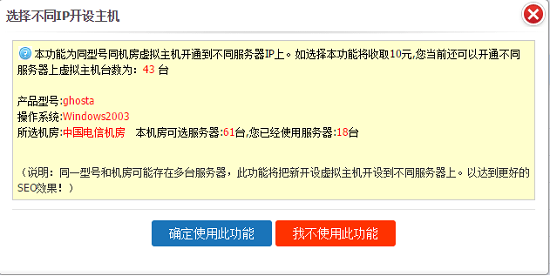

需适配不同云平台的虚拟化规范(如VMware/KVM差异) |

| 混合云部署 |

通过Kubernetes实现统一编排管理 |

依赖厂商特定的管理工具(vCenter/OpenStack) |

| CI/CD集成度 |

天生适合持续交付流水线,支持原子化部署 |

需要额外工具链完成镜像构建与推送 |

| 环境一致性 |

“一次构建到处运行”的承诺实际取决于基础镜像配置 |

不同Hypervisor版本的细微差异可能导致兼容性问题 |

典型应用场景匹配

| 业务类型 |

推荐方案 |

原因解析 |

| 微服务架构 |

容器 |

轻量化、快速扩缩容,适合无状态服务的动态调度 |

| HPC计算集群 |

️ 慎用容器 |

资源争抢敏感型任务更适合VM的资源独占模式 |

| DevOps测试环境 |

容器 |

版本控制精确到依赖库级别,环境重建成本低 |

| 遗留系统迁移 |

逐步向容器转型 |

先通过VM维持原有架构稳定性,再分阶段容器化改造 |

| 数据库服务 |

️ 根据负载选择 |

高并发写入场景建议VM保证IO确定性;只读副本可用容器实现水平扩展 |

运维复杂度对照表

| 操作项 |

容器平台 |

传统虚拟化平台 |

| 监控告警 |

Prometheus+Grafana可视化指标采集 |

vRealize Operations Manager企业级监控 |

| 日志聚合 |

Fluentd/Logstash侧车模式收集 |

Syslog中心化存储分析 |

| 配置管理 |

Ansible/Chef基于声明式模板 |

Puppet Master-Agent主动推送模式 |

| 灾备方案 |

etcd分布式KV存储状态同步 |

SRM存储资源管理组件实现快照备份 |

| 权限管控 |

Kubernetes RBAC细粒度授权 |

Active Directory域控集成 |

相关问题与解答

Q1:为什么金融核心交易系统很少采用容器化部署?

A:主要顾虑包括①进程级隔离不如VM彻底,存在内核提权攻击风险;②网络延迟抖动可能影响高频交易的稳定性;③监管合规要求物理资源可见性,而容器的资源超卖特性难以满足审计需求,不过近年通过Kata Containers等安全沙箱技术已开始试点应用。

Q2:如何判断某个应用是否适合从VM迁移到容器?

A:关键评估维度:①是否有状态管理需求(无状态优先);②是否需要特定硬件直通(如GPU/FPGA);③依赖的系统调用是否超出默认Seccomp策略范围;④业务峰值波动幅度(突发流量越大越适合容器弹性伸缩),建议使用PCP(Performance Characterization Tool)