上一篇

物理机 支持虚拟机个数

- 物理机

- 2025-08-01

- 24

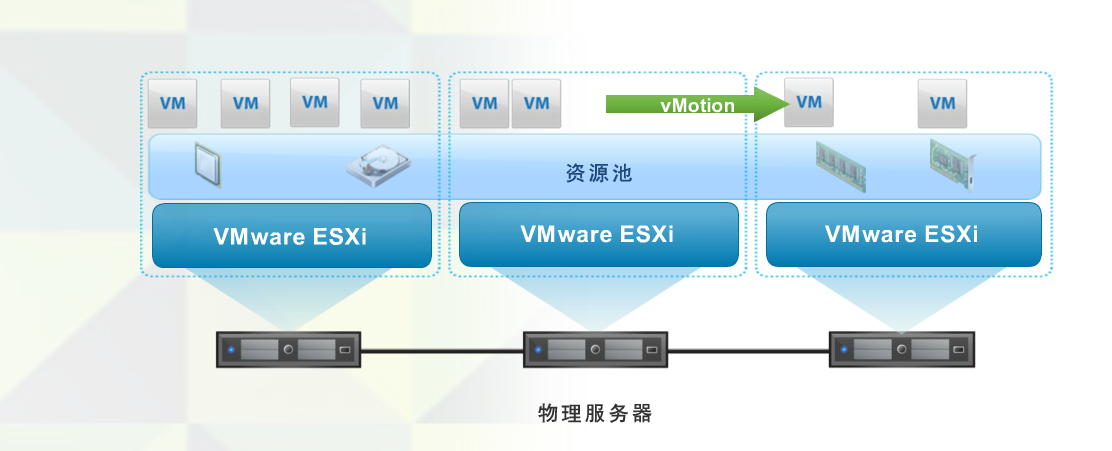

物理机可支持多个虚拟机,具体数量受其CPU、内存等硬件资源限制,借助虚拟化软件实现资源的灵活分配与管理。

机支持的虚拟机个数是一个动态范围,受多种因素影响,包括硬件配置、虚拟化技术类型、资源分配策略及工作负载需求等,以下是详细分析:

-

核心限制因素

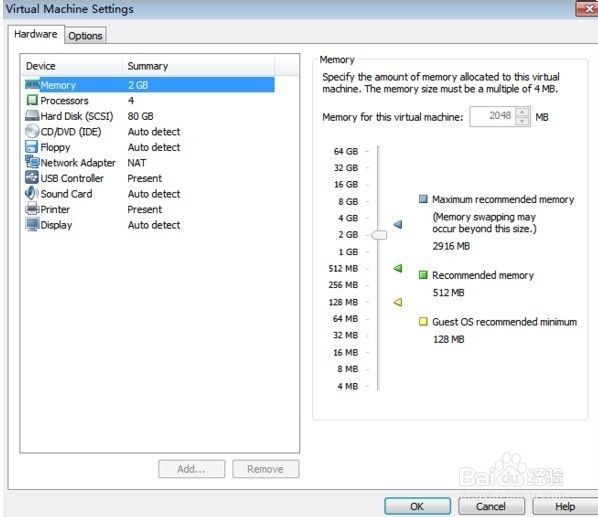

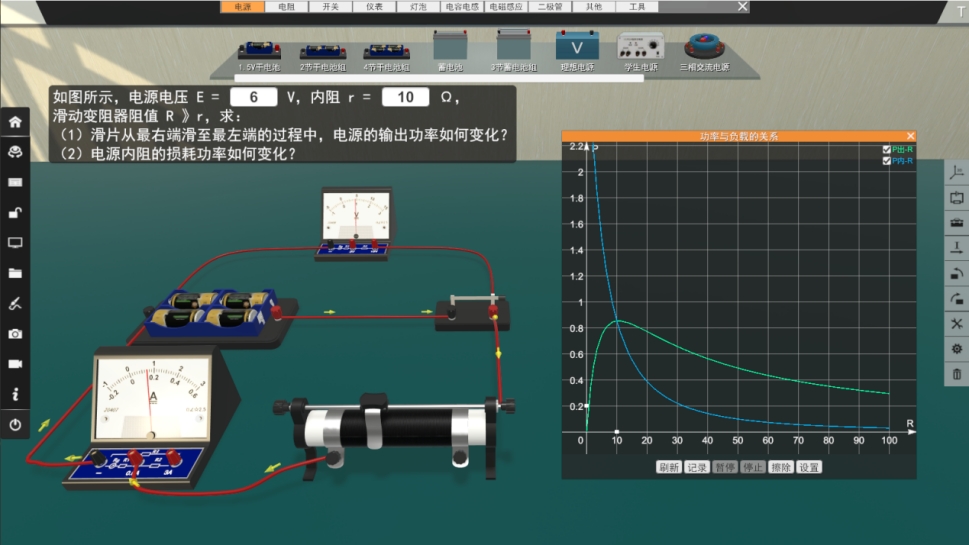

- CPU核心数:物理机的处理器核心数量直接决定了可分配给每个虚拟机的计算能力,若物理机为8核,通常建议每个虚拟机分配2–4个核心(保留50%给宿主机系统及其他任务),中等负载场景下可创建约2–4个虚拟机;如果是16核或更多,则能支持更高密度的部署,超线程技术虽能提升逻辑核心总数,但实际分配仍需基于物理核心数以避免性能下降。

- 内存容量:这是硬性约束条件,假设一台服务器总内存为8GB,扣除Hypervisor自身占用的512MB后剩余约7.5GB,按每个虚拟机最低需求1GB计算,理论上最多只能运行7个实例,不过现代Hypervisor支持内存超配(overcommit),如设置50%的超额比例时,同一配置下可扩展到11个虚拟机,但需注意稳定性风险,在生产环境中,通常建议将超配比例控制在20%以内以保障关键业务连续性。

- 存储空间与I/O性能:磁盘读写速度和容量也会影响规模上限,本地SSD阵列比网络存储(如iSCSI)能提供更高的吞吐量,适合承载更多活跃虚拟机,动态调整磁盘配额工具可以帮助优化利用率。

-

不同场景下的典型实践

- 桌面开发环境:普通PC用户使用VMware Workstation或VirtualBox这类Type 2 hypervisor时,受限于消费级硬件(如4核CPU+16GB RAM),同时运行5–10个低负载虚拟机较为常见,主要用于测试不同操作系统或软件栈;此时应优先保证宿主机的响应速度,避免因资源争夺导致卡顿。

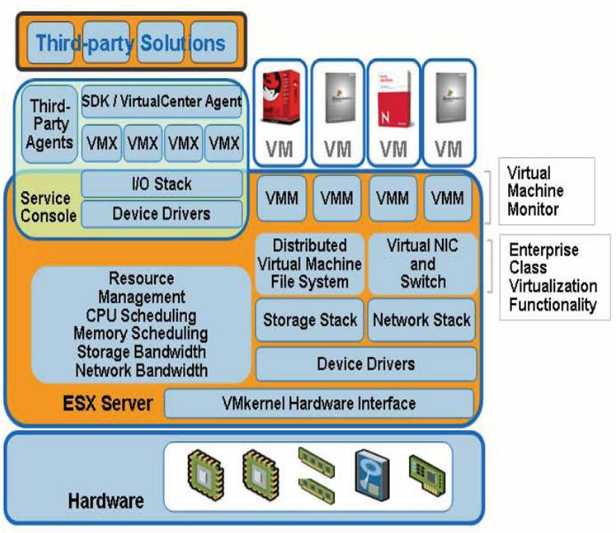

- 数据中心服务器集群:采用ESXi等企业级Type 1 hypervisor的解决方案中,通过压力测试确定单主机承载量,某企业规划一年内部署100台虚拟机,会选择每主机托管25个实例,配合256GB内存和双路12核Intel处理器实现高效调度,此类架构还会结合HA集群进行故障转移,预留冗余资源应对突发流量。

-

优化策略与权衡要点

- 资源隔离机制:通过设置CPU亲和性、内存上限及存储QoS策略,确保关键业务虚拟机优先获得资源,数据库服务可绑定特定物理核心,而Web前端应用则允许共享剩余计算力。

- 动态调整能力:监控工具实时采集各虚拟机的CPU/内存使用率,当检测到某个实例长期处于高负载状态时,管理员可在线增加其资源配额或迁移至空闲节点,这种弹性扩展能力显著提升了整体基础设施的投资回报率。

- 网络带宽分配:多虚拟机共用同一物理网卡可能导致带宽争抢,尤其在进行大规模数据传输时,通过VLAN划分和流量整形技术可以缓解这一问题,确保关键应用的网络延迟稳定在可接受范围内。

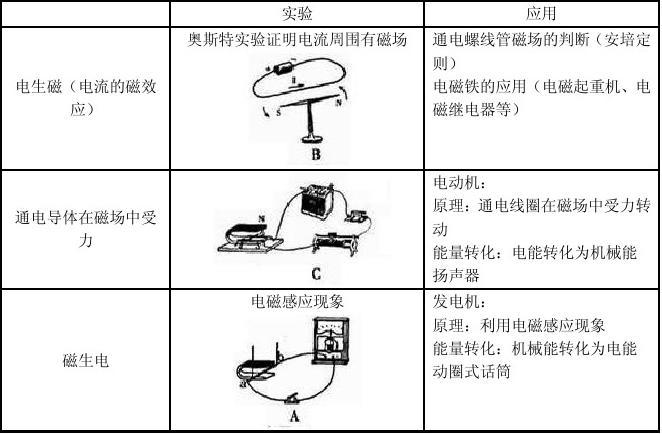

| 硬件参数 | 入门级配置示例 | 高端服务器示例 | 最大潜在支持量 |

|---|---|---|---|

| CPU | 4核 | 2×12核 | 取决于核心利用率 |

| 内存 | 8GB | 256GB | 受超配比例影响 |

| 存储类型 | HDD机械硬盘 | NVMe SSD全闪存阵列 | IOPS决定并发处理能力 |

| 典型部署数量 | 2–5个 | 25–50个 | 理论无上限 |

注:“理论无上限”指通过分布式架构横向扩展,但单节点的性能边界依然存在。

FAQs:

-

问:为什么同样的物理机在不同场景下支持的虚拟机数量差异很大?

- 答:主要原因在于工作负载特性不同,轻量级办公应用可能仅需单个vCPU和少量内存,而数据库服务则需要大量专用资源,虚拟化平台的调度算法、是否启用内存压缩/去重技术,以及底层存储系统的响应速度都会影响最终承载量,使用重复数据删除功能的存储系统可在相同物理空间内存放更多镜像文件。

-

问:如何判断当前物理机是否已达到最佳密度?

- 答:关键指标包括:持续超过85%的CPU利用率表明计算资源紧张;内存交换区频繁被调用说明内存不足;存储延迟激增反映磁盘I/O瓶颈,建议定期进行压力测试,模拟峰值业务场景下的系统表现,并保持至少20%的资源余量以应对突发流量,对于启用了HA集群的环境,还需验证