上一篇

多台服务器共用一个ip

- 数据库

- 2025-07-19

- 3656

多台服务器可通过NAT或反向代理共享IP,结合负载均衡技术实现请求分发,优化资源利用并提升服务高可用性

多台服务器共用一个IP的实现与解析

核心概念

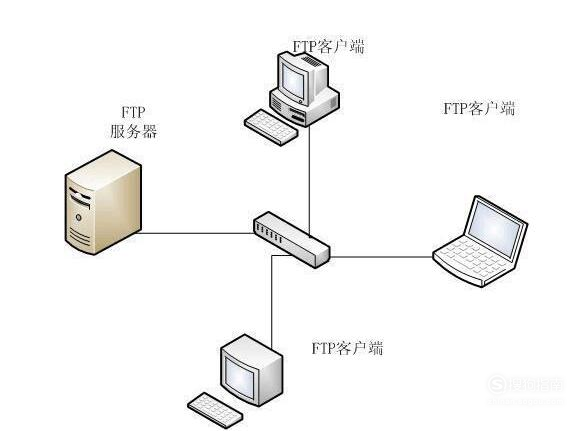

多台服务器共用一个IP(即多个服务器节点共享同一个公网IP或内网IP),通常通过反向代理、负载均衡或网络地址转换(NAT)等技术实现,其核心目的是:

- 隐藏后端服务器细节,统一入口;

- 分担流量压力,提升并发处理能力;

- 节约公网IP资源(尤其在云环境或IP稀缺场景)。

常见实现方式

| 技术方案 | 原理 | 适用场景 |

|---|---|---|

| 反向代理 | 通过Nginx、HAProxy等代理服务器接收请求,转发至后端多台服务器 | 中小型网站、API网关 |

| 四层负载均衡 | 基于TCP/UDP协议(如LVS、F5硬件负载均衡器)分发流量至后端服务器 | 高并发业务、数据库集群 |

| 七层负载均衡 | 基于HTTP/HTTPS协议(如云厂商SLB、Traefik)解析请求后转发 | Web服务、微服务架构 |

| NAT端口映射 | 通过路由器/防火墙将同一IP的不同端口映射到不同服务器(如IP:80→服务器A) | 低成本实验环境、小型企业网络 |

优缺点分析

优势:

- 资源节约:减少公网IP消耗,降低运维成本;

- 扩展灵活:新增服务器无需分配新IP,直接加入集群;

- 统一入口:简化客户端配置(如域名解析只需指向单一IP);

- 负载分担:提升系统吞吐量和容错能力。

劣势:

- 单点瓶颈:代理/负载均衡器可能成为性能瓶颈;

- 安全风险:若代理被攻击,可能影响整个后端集群;

- 会话保持复杂:需额外配置粘性session或分布式存储;

- SSL终止开销:若代理处理SSL加密,可能增加CPU负载。

典型应用场景

-

Web服务集群

- 多台Tomcat服务器共享一个IP,通过Nginx反向代理实现负载均衡;

- 用户访问

http://example.com,实际由Nginx分发请求至后端服务器。

-

数据库读写分离

- 主库(写)与从库(读)共用同一个IP,通过代理(如ProxySQL)路由请求;

- 客户端只需连接单一IP,自动实现读写分离。

-

云服务器弹性扩展

- 在阿里云/AWS中,SLB(负载均衡)绑定单个EIP,后端挂载多台ECS实例;

- 支持自动扩缩容,无需手动管理IP。

注意事项

- 健康检查:需配置负载均衡器定期检测后端服务器状态(如TCP探针、HTTP状态码);

- 会话保持:对需要持续连接的场景(如WebSocket),需启用

ip_hash或cookie粘性会话; - SSL证书:若代理服务器处理SSL终止,需在代理层部署证书,而非后端服务器;

- 安全策略:限制代理层的开放端口,避免暴露多余服务(如RDP、SSH)。

相关问题与解答

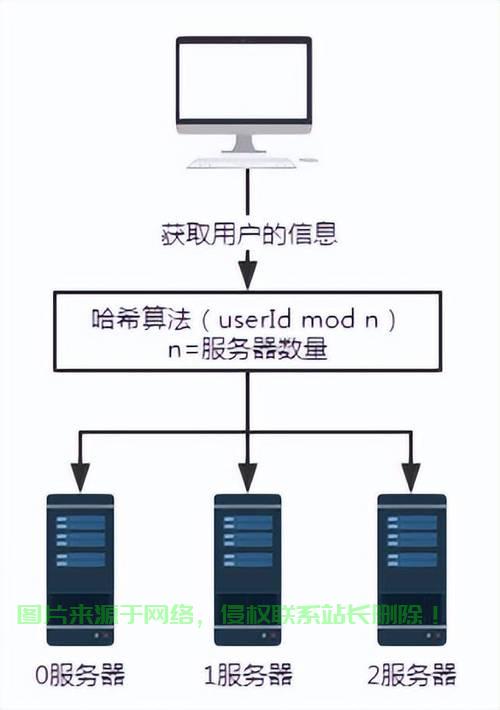

问题1:如何实现多台服务器共用一个IP的会话保持?

解答:

可通过以下方式实现会话粘性:

- IP哈希法:根据客户端IP地址分配固定后端服务器(如Nginx的

ip_hash指令); - Cookie插入:在代理层生成唯一标识,将请求绑定到特定服务器(如HAProxy的

cookie策略); - URL参数:通过URL携带会话ID,后端服务器根据参数识别上下文。

问题2:共用IP时,如何优化SSL性能?

解答:

- SSL终止在代理层:在Nginx/HAProxy等代理服务器完成SSL解密,减少后端服务器的加密开销;

- 启用OCSP Stapling:代理服务器预先获取证书状态,避免客户端重复验证;

- 使用硬件加速:在负载均衡器(如F5、A10)开启SSL硬件卸载功能;

- Session复用:配置`sslsession