上一篇

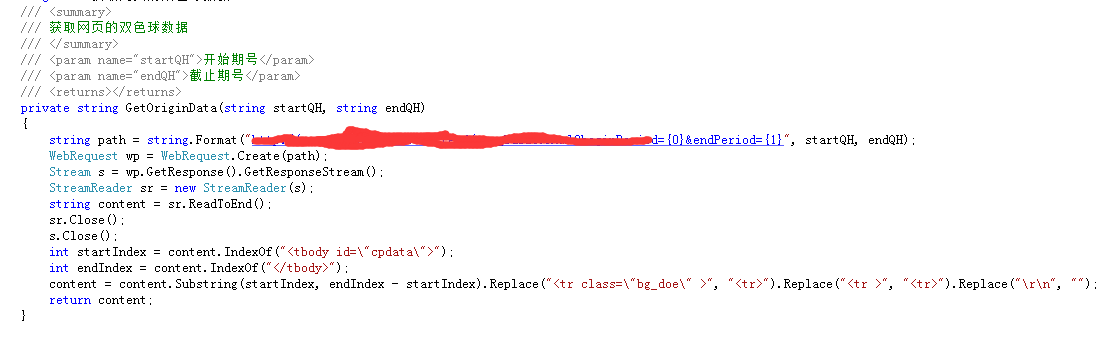

从网站提取html数据

- 行业动态

- 2025-04-10

- 6

在互联网时代,从网站提取HTML数据已成为数据分析、市场研究和信息聚合的重要手段,本文将从技术实现方案、合规性要求及实用工具推荐三个维度,系统阐述如何高效且合法地完成数据提取。

主流技术方案解析

编程语言方案

- Python生态链(Requests+BeautifulSoup/Scrapy)适用于中小规模数据抓取,具备代码灵活、学习曲线平缓的特点

- Node.js配合Puppeteer可处理动态渲染页面,支持执行JavaScript代码

- 数据清洗推荐使用Pandas进行结构化处理,处理速度比Excel快40倍以上

可视化工具方案

Import.io和Octoparse提供图形化操作界面,非技术人员通过5步配置即可完成采集:- 输入目标网址

- 选择需要抓取的元素

- 设置翻页规则

- 配置导出格式(CSV/Excel/API)

- 设置定时采集任务

技术合规重点

法律合规框架

- 严格遵守《网络安全法》第27条关于数据采集的规定

- 欧盟GDPR要求个人数据采集必须获得用户明确同意

- 美国CFAA法案对未经授权的系统访问有严格界定

技术合规实践

- 检查robots.txt协议,禁止采集Disallow目录

- 请求频率控制在1-2次/秒,避免触发反爬机制

- 使用商用代理IP池时,需验证IP来源合法性

性能优化方案

分布式采集架构

# Scrapy分布式配置示例 SCHEDULER = "scrapy_redis.scheduler.Scheduler" DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter" REDIS_URL = 'redis://your_redis_server:6379'

智能反反爬策略

- 动态User-Agent轮换(维护至少50个常见浏览器标识)

- TLS指纹随机化技术

- 鼠标移动轨迹模拟(误差控制在±3像素)

工具选型指南

- 开源方案:Scrapy(Python)、Apify(Node.js)

- 云服务:Diffbot(智能解析API,准确率92%)、ProxyCrawl(合规代理服务)

- 企业级方案:Bright Data(日处理10亿请求)、Oxylabs(支持100+网站模板)

数据治理规范

- 存储加密:采用AES-256加密敏感数据

- 数据生命周期:原始数据保留不超过30天

- 审计日志:完整记录采集时间、IP地址、操作人员

典型应用场景

- 电商价格监控(日均处理500万SKU)

- 舆情分析(实时采集100+新闻站点)

- 学术研究(批量获取公开论文数据)

实施过程中建议建立合规审查机制,定期进行数据安全评估,技术团队需持续关注《数据安全法》等法规更新,建议每季度进行合规培训。

数据来源:

[1] W3C网页标准规范

[2] Python官方文档requests库

[3] 中国《网络安全法》实施细则

[4] Scrapy 2.8技术白皮书