bp神经网络怎么训练

- 行业动态

- 2025-04-10

- 5

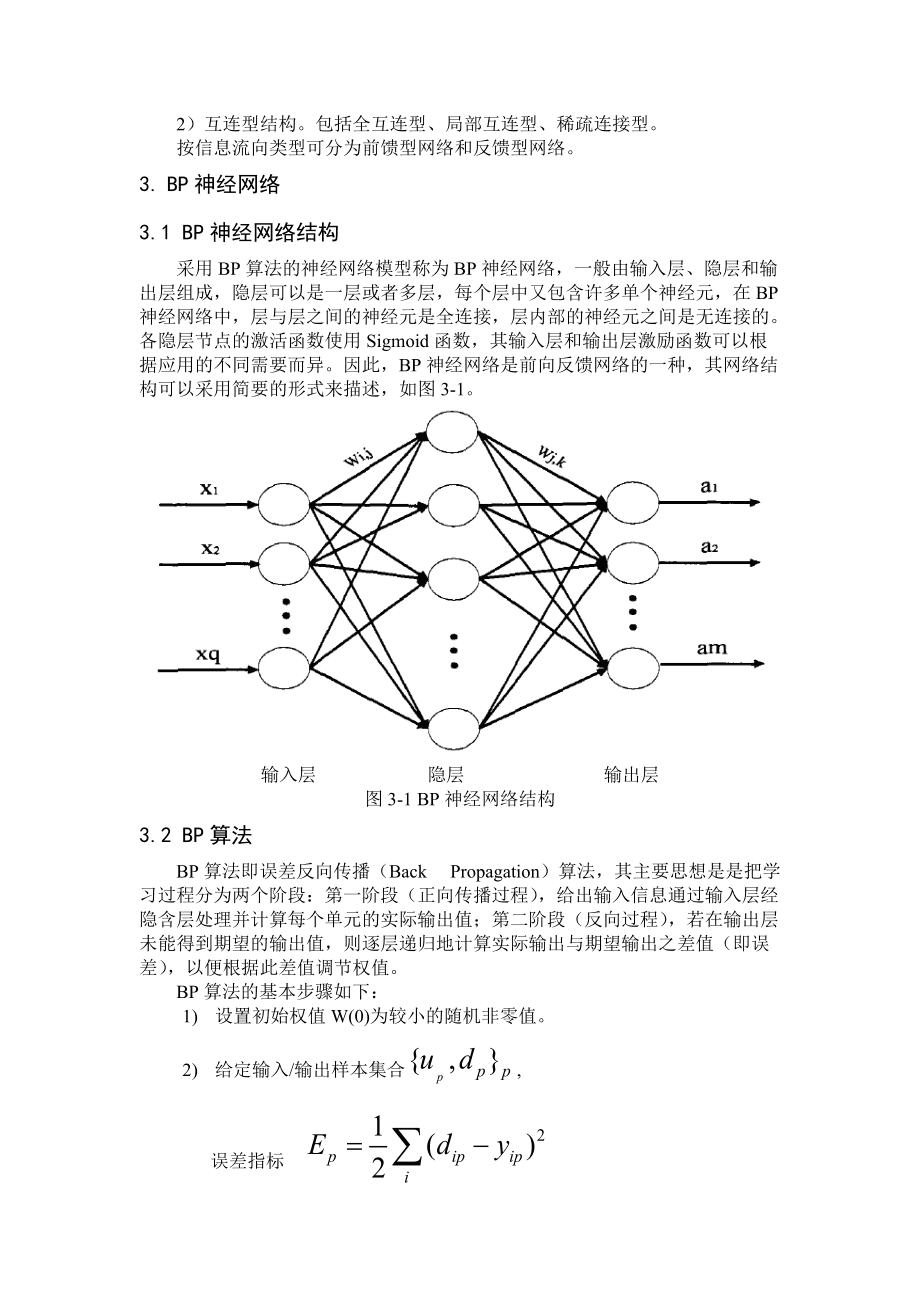

神经网络作为人工智能领域的重要技术之一,其训练过程直接影响模型的最终表现,BP神经网络(误差反向传播神经网络)凭借其清晰的数学原理和稳定的训练效果,成为最基础且应用最广泛的前馈神经网络模型,以下是经过工程验证的标准训练流程与技术细节:

网络初始化阶段

确定网络拓扑结构

- 输入层节点数=数据特征维度(如房价预测包含5个特征则设置5个节点)

- 输出层节点数=预测目标维度(分类任务对应类别数量,回归任务为1)

- 隐藏层设置建议:

- 浅层网络:1-2个隐藏层

- 深层网络:3层以上(需配合批量归一化等技巧)

- 节点数量经验公式:输入节点数+输出节点数的2/3

参数初始化

- Xavier初始化:权重矩阵W~U[-√(6/(n_in+n_out)), √(6/(n_in+n_out))]

- He初始化:适用于ReLU激活函数,W~N(0,√(2/n_in))

- 偏置项b通常初始化为0.01

前向传播计算

线性变换:Z=WX+b

- 矩阵维度验证:W^(l) ∈ R^{nl×n{l-1}}

- 数值稳定性检查:添加1e-8防止除零错误

激活函数选择

| 函数类型 | 表达式 | 适用场景 | 梯度特性 |

|————–|——————-|——————-|——————-|

| Sigmoid | 1/(1+e^{-x}) | 二分类输出层 | 0.25最大梯度 |

| Tanh | (e^x-e^{-x})/(..) | 隐藏层 | 1.0最大梯度 |

| ReLU | max(0,x) | 深层网络 | 分段常数梯度 |

| Leaky ReLU | max(0.01x,x) | 缓解神经元死亡问题| 保持负区间梯度 |

损失函数计算

- 回归任务:均方误差 MSE=1/(2m)Σ(y_pred-y_true)^2

- 分类任务:

- 二分类:二元交叉熵 -[ylogσ+(1-y)log(1-σ)]

- 多分类:交叉熵损失 -Σy_i log(softmax(z_i))

- 正则化项:L2正则化 λ/2m Σ||W||^2

反向传播核心算法

计算输出层误差:

δ^L = ∇_aC ⊙ σ'(z^L)

以交叉熵+Sigmoid为例:δ^L = a^L – y

反向传播误差:

δ^l = (W^{l+1}^T δ^{l+1}) ⊙ σ'(z^l)使用矩阵转置实现维度匹配

参数梯度计算:

∂C/∂W^l = δ^l (a^{l-1})^T

∂C/∂b^l = δ^l

参数优化策略

梯度下降变体对比

| 优化器 | 更新公式 | 动量项 | 自适应学习率 |

|————-|———————————–|——–|————–|

| SGD | θ = θ – η∇θ | × | × |

| Momentum | v=γv+η∇θ; θ=θ-v | √ | × |

| RMSprop | E[g²]t=ρE[g²]{t-1}+(1-ρ)g_t² | × | √ |

| Adam | 结合动量与自适应学习率 | √ | √ |学习率设置

- 初始值:0.001(Adam)、0.01(SGD)

- 衰减策略:指数衰减、余弦退火

- 热身机制:前500步线性增加学习率

训练终止条件

早停法(Early Stopping)

- 验证集损失连续10个epoch未下降时终止

- 保留最佳参数副本

收敛标准

- 训练损失变化率<1e-6

- 权重更新量<1e-5

模型评估与调优

评估指标选择

- 分类任务:准确率、F1-score、AUC-ROC

- 回归任务:MAE、R²系数

过拟合应对措施

- Dropout(丢弃率0.2-0.5)

- 数据增强(旋转、噪声添加)

- 权重约束(maxnorm=3)

技术要点说明

梯度检验:使用双侧差分验证反向传播正确性

grad_diff = |f(θ+ε)-f(θ-ε)|/(2ε) – backprop_grad批量归一化:在激活函数前添加BN层

x_hat = (x-μ)/√(σ²+ε)

y = γx_hat + β

常见问题解答

Q:训练时损失震荡不收敛?

A:检查学习率是否过大,尝试减小2-10倍

Q:模型在训练集表现好但测试集差?

A:增加L2正则化系数,或添加Dropout层

Q:隐藏层节点数如何确定?

A:使用网格搜索在16-256之间寻找最优值

Q:梯度消失如何解决?

A:改用ReLU激活函数,或使用残差连接

学术引用

[1] Rumelhart D E, Hinton G E, Williams R J. Learning representations by back-propagating errors[J]. Nature, 1986.(反向传播算法原始论文)

[2] Glorot X, Bengio Y. Understanding the difficulty of training deep feedforward neural networks[C]. AISTATS, 2010.(参数初始化研究)

[3] Kingma D P, Ba J. Adam: A method for stochastic optimization[J]. ICLR, 2015.(Adam优化器论文)