上一篇

从零入门深度学习

- 行业动态

- 2025-04-10

- 2

深度学习听起来像是只有科学家才能触碰的高深领域?别被这个词吓到!本文用最直白的方式,带你从“零基础”一步步走进深度学习的核心世界,无需数学公式轰炸,先建立清晰的思维框架,再动手实操,最后避开99%新手的坑,文末附上免费资源包,看完立刻上手!

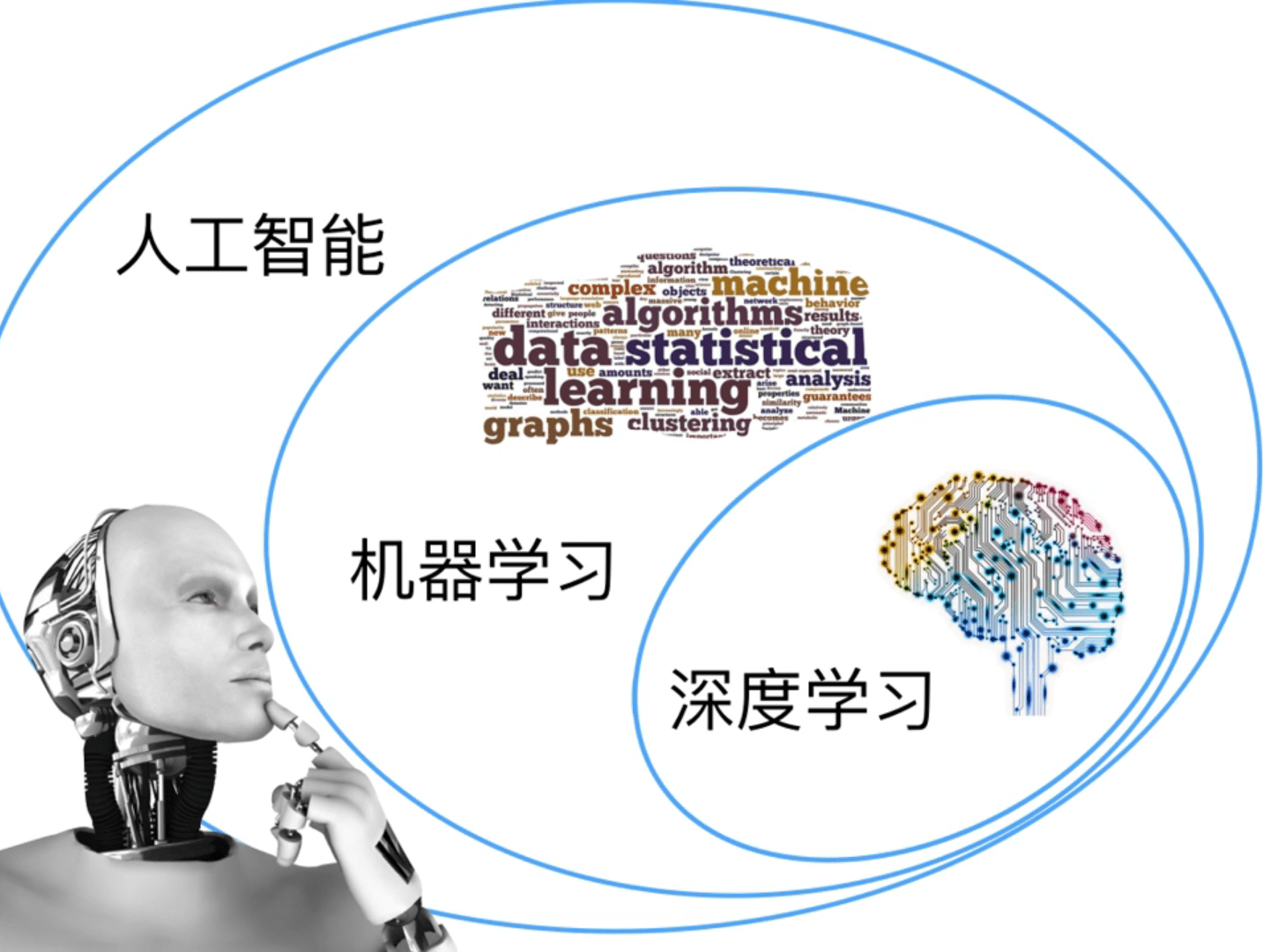

什么是深度学习?打破神秘面纱

想象教孩子认猫:先看图片,指出耳朵尖、眼睛圆、毛茸茸的特点,反复练习就能识别新图片,深度学习本质就是让计算机模仿这个过程,通过海量数据自动学习规律。

与传统编程的区别:

- 传统编程:人写规则 → 计算机执行(如:用代码判断数字奇偶)

- 深度学习:计算机从数据中自己找规则(如:看1000张猫狗图后自动识别新品种)

核心价值:处理非结构化数据(图片/语音/文本)的能力远超传统算法,人脸识别、语音助手、推荐系统背后都有它的身影。

入门必知的四大基础组件

▋ 1. 神经网络:深度学习的“大脑”

- 结构类比:像人类神经元网络,每个节点(神经元)接收信号→计算→传递结果

- 典型层级:输入层(接收数据)→ 隐藏层(加工特征)→ 输出层(给出预测)

▋ 2. 激活函数:决定神经元是否“启动”

- 作用:加入非线性因素,让网络能学习复杂模式(如ReLU函数:负数归零,正数保留)

- 常用类型:Sigmoid(输出0-1概率)、Tanh(输出-1到1)、ReLU(计算高效)

▋ 3. 损失函数:告诉模型“错在哪”

- 类比考试:得分越低表现越好(损失值越小模型越准)

- 常见类型:

- 均方误差(MSE):预测房价等回归问题

- 交叉熵损失(Cross-Entropy):图片分类等分类问题

▋ 4. 优化器:模型的“私人教练”

- 工作原理:通过反向传播调整参数,逐步降低损失值

- 明星算法:

- 随机梯度下降(SGD):基础但需精细调参

- Adam:自动调整学习率,新手友好

零基础学习路径(附时间规划)

第一阶段(1-2周):基础筑基

- 掌握Python基础语法(推荐《Python Crash Course》)

- 理解Numpy矩阵运算、Pandas数据处理

- 学习Matplotlib/Seaborn数据可视化

第二阶段(2-3周):框架入门

- TensorFlow/Keras:官方文档+Colab实战

- PyTorch(科研首选):动态图机制更灵活

- 必做项目:MNIST手写数字识别(准确率突破95%)

第三阶段(3-4周):实战升级

- 图像分类:CIFAR-10数据集(10类物体识别)

- 文本处理:IMDB电影评论情感分析

- 模型调优:学习使用早停法、数据增强

工具生态全景图

| 工具类型 | 代表工具 | 特点 |

|---|---|---|

| 开发框架 | TensorFlow, PyTorch | 工业界vs学术界双主流 |

| 数据预处理 | OpenCV, Scikit-learn | 图像处理/特征工程利器 |

| 模型可视化 | Netron, TensorBoard | 直观查看模型结构/训练过程 |

| 部署工具 | ONNX, TensorRT | 模型轻量化/加速推理 |

新手避坑指南(血泪经验!)

数据陷阱

- 直接跑模型不检查数据

- 先做数据分布分析(类别平衡/缺失值处理)

模型选择误区

- 一上来就用ResNet、Transformer

- 从全连接网络(FCN)开始,逐步增加复杂度

调参黑洞

- 盲目调整所有参数

- 优先调节学习率、批量大小(batch_size)

免费资源大礼包

入门课程:

- 吴恩达《深度学习专项课》(Coursera)

- fast.ai《面向程序员的深度学习》(实战导向)

代码库:

- GitHub搜索“pytorch-tutorial”获得5k星标项目

- Kaggle开放数据集+Notebook案例

社区支持:

- Stack Overflow标注“deep-learning”的热门问题

- Reddit的r/MachineLearning板块

现在就开始行动!

- 打开Google Colab(无需安装环境)

- 复制这段代码运行你的第一个神经网络:

from tensorflow.keras import layers model = tf.keras.Sequential([ layers.Dense(64, activation='relu', input_shape=(784,)), layers.Dense(10, activation='softmax') ]) model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy']) - 加载MNIST数据开始训练!

参考文献

[1] Goodfellow I, Bengio Y, Courville A. Deep learning. MIT press, 2016.

[2] PyTorch官方文档 https://pytorch.org/docs

[3] TensorFlow白皮书 https://arxiv.org/abs/1603.04467