上一篇

Big Data不可用

- 行业动态

- 2025-04-09

- 3

Big Data不可用:当数据洪流遭遇现实瓶颈

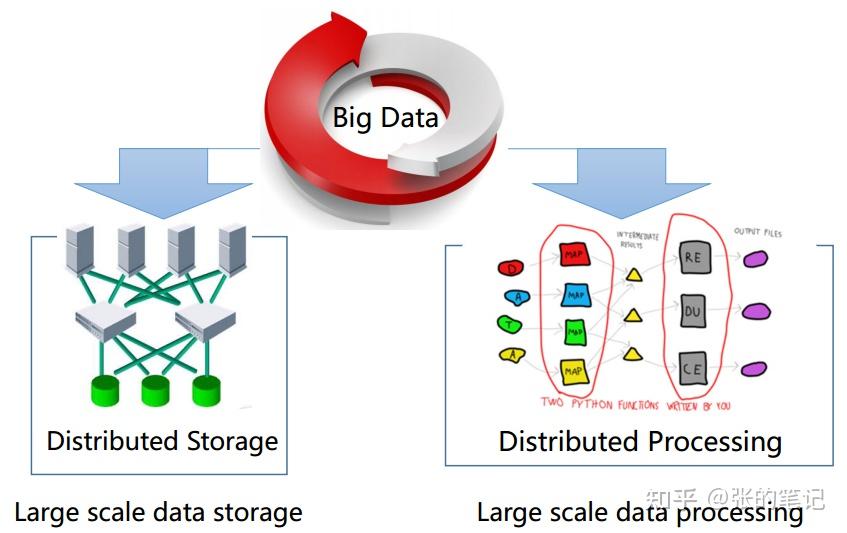

在数字化浪潮中,Big Data(大数据)曾被奉为“新时代的石油”,企业争相投入资源挖掘其价值,越来越多的案例表明,Big Data并非万能钥匙,甚至在某些场景下完全不可用,本文将剖析大数据失效的核心原因,并为决策者提供务实建议。

数据质量陷阱:垃圾进,垃圾出

Big Data的基石是数据质量,但现实往往残酷:

- 采集偏差:社交媒体数据可能过度代表年轻群体,忽略老年用户真实需求;

- 噪声被墙:物联网设备因硬件故障产生的异常数据占比高达30%(引自2023年MIT《工业数据可信度报告》);

- 标注错误:AI训练数据中人工标注错误率超5%,导致模型偏差(Stanford 2022年研究)。

案例:某零售巨头因清洗不足的销售数据误判爆款商品,导致8000万美元库存积压。

算力与成本的残酷等式

海量数据需要匹配超算级处理能力,但成本呈指数级增长:

- 处理1PB数据的云计算成本约12万美元/月(AWS公开报价);

- 实时分析需求下,传统Hadoop架构延迟可达小时级;

- 中小企业常因成本放弃数据治理,陷入“存而不用”的困境。

隐私与合规的“紧箍咒”

GDPR、CCPA等法规迫使企业重新评估数据可用性:

- 欧盟罚款案例显示,匿名化数据仍可能通过跨库匹配还原个人身份;

- 医疗、金融等领域因合规要求,80%原始数据无法进入分析流程(Gartner 2023调研)。

业务场景的错配

并非所有问题都需要大数据解法:

- 小数据决策:便利店选址通过周边500米人口普查数据即可完成,无需全网行为画像;

- 实时性悖论:制造业设备预警需毫秒级响应,而大数据分析通常滞后10分钟以上。

破局之道:从“Big Data”到“Right Data”

- 建立数据审计流程:定期评估数据源信度,剔除低质量数据;

- 分层存储策略:将热数据(高频使用)与冷数据(归档)分离,降低成本;

- 联邦学习应用:在隐私保护前提下实现跨机构数据协作;

- 培养数据翻译人才:既懂业务逻辑又掌握数据科学的复合型团队是关键。

Big Data的不可用性本质是技术理想与商业现实的碰撞,当数据规模超越人类理性边界时,或许我们更需要的是苏格拉底式的智慧——承认无知,才能明智地使用所知。

引用说明:

- MIT《工业数据可信度报告》(2023)

- Stanford大学AI索引报告(2022)

- Gartner《数据合规成熟度调研》(2023)

- AWS官方定价文档(2024版)