上一篇

bp神经网络矩阵归一化

- 行业动态

- 2025-04-09

- 3

BP神经网络矩阵归一化

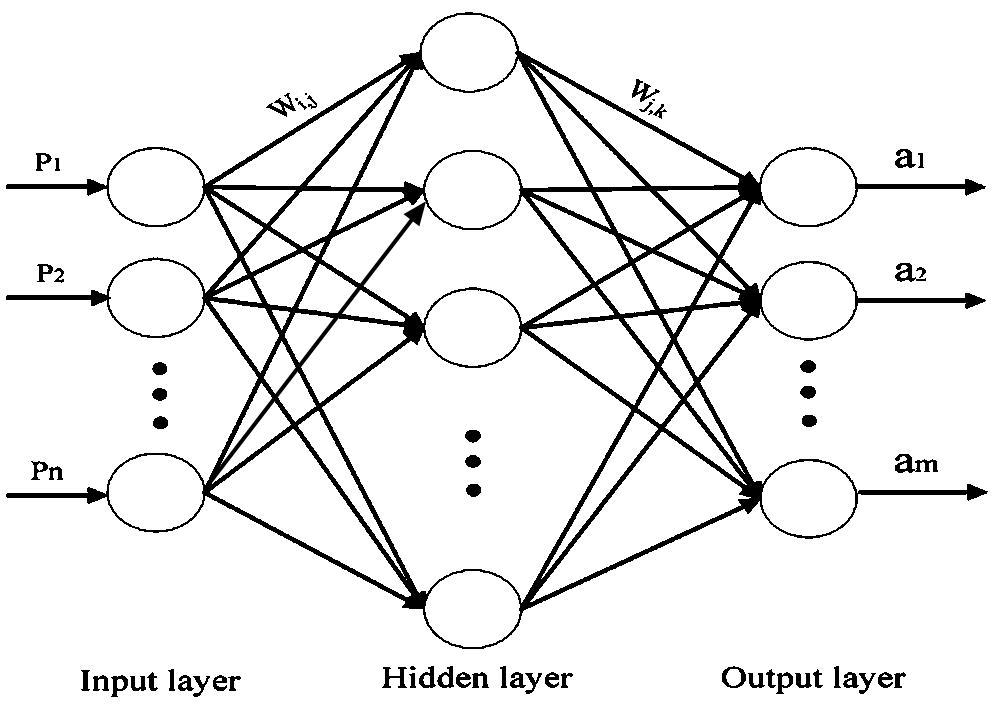

在BP神经网络中,矩阵归一化是数据预处理的关键步骤,直接影响模型的训练效率和泛化能力,本文将详细介绍归一化的原理、方法及实现技巧,帮助开发者优化神经网络性能。

为什么需要归一化?

BP神经网络的输入数据通常具有不同的量纲或范围(如年龄0-100,收入0-100000),直接输入会导致以下问题:

- 梯度更新不稳定:权重因输入值范围差异过大而收敛缓慢。

- 激活函数饱和:如Sigmoid函数在输入值较大时梯度接近0,引发“梯度消失”。

- 计算效率低:未归一化的数据需要更多迭代次数才能达到最优解。

常用归一化方法

Min-Max归一化

将数据线性映射到[0, 1]区间:

[

X{text{norm}} = frac{X – X{min}}{X{max} – X{min}}

]

适用场景:数据分布有明显边界(如图像像素值)。

Z-Score标准化

将数据转换为均值为0、标准差为1的分布:

[

X_{text{std}} = frac{X – mu}{sigma}

]

适用场景:数据存在异常值或服从近似高斯分布。

Robust Scaling(鲁棒归一化)

基于中位数和四分位数缩放,抗异常值干扰:

[

X_{text{robust}} = frac{X – text{Median}}{IQR}

]

适用场景:数据包含离群点。

BP神经网络中的实现步骤

- 训练阶段:

- 计算训练集的均值(μ)、标准差(σ)或最小/最大值。

- 对输入层数据应用归一化。

- 预测阶段:

使用训练集的统计量归一化新数据,避免数据泄露。

Python示例(Scikit-learn):

from sklearn.preprocessing import MinMaxScaler, StandardScaler # Min-Max归一化 scaler = MinMaxScaler() X_train_scaled = scaler.fit_transform(X_train) X_test_scaled = scaler.transform(X_test) # Z-Score标准化 scaler = StandardScaler() X_train_std = scaler.fit_transform(X_train) X_test_std = scaler.transform(X_test)

注意事项

- 避免数据泄露:归一化统计量必须仅从训练集计算,再应用到测试集。

- 输出层处理:若输出值需还原为原始范围(如回归问题),需保存逆变换参数。

- 稀疏数据慎用Min-Max:可能破坏数据的稀疏性。

矩阵归一化是BP神经网络高效训练的基础,根据数据分布选择合适方法(如Min-Max、Z-Score或鲁棒归一化),并严格区分训练/测试集的预处理流程,可显著提升模型性能。

参考文献:

- Bishop, C. M. (2006). Pattern Recognition and Machine Learning. Springer.

- Scikit-learn文档: Preprocessing Data.