bp神经网络特征提取

- 行业动态

- 2025-04-09

- 5

BP神经网络特征提取

在机器学习与模式识别领域,特征提取是构建高效模型的关键步骤,BP神经网络(反向传播神经网络)作为一种经典的人工神经网络结构,不仅能够用于分类和回归任务,还能有效完成特征提取工作,本文将深入探讨BP神经网络在特征提取中的应用原理、优势及实践方法。

BP神经网络基础

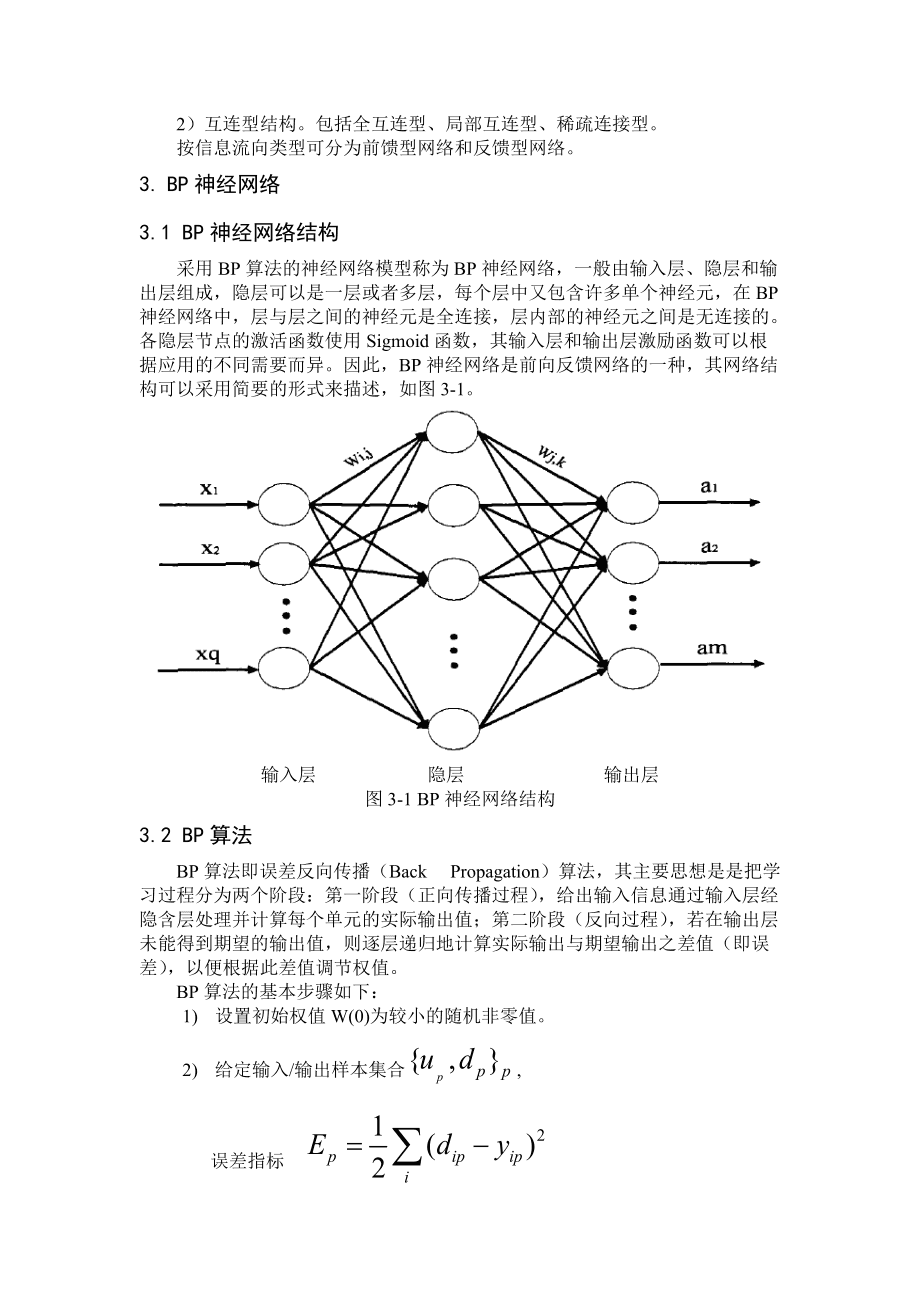

BP神经网络是一种多层前馈神经网络,由输入层、隐藏层(可多层)和输出层组成,其核心特点是通过反向传播算法调整网络权重,使网络输出尽可能接近期望输出。

网络训练过程分为两个阶段:

- 前向传播:输入数据从输入层经隐藏层传递至输出层

- 反向传播:根据输出误差反向调整各层权重参数

典型的BP神经网络结构包含:

- 输入层节点数 = 输入特征维度

- 隐藏层节点数需通过实验确定

- 输出层节点数 = 分类类别数或回归输出维度

特征提取原理

BP神经网络通过隐藏层实现对输入数据的非线性变换和特征提取:

逐层抽象机制:

- 低层隐藏层提取局部特征(如边缘、纹理)

- 高层隐藏层组合低层特征形成更抽象的表示

自动特征学习:

- 网络自动学习对任务最有用的特征表示

- 无需人工设计特征提取算法

降维能力:

- 当隐藏层节点数少于输入维度时,网络实现非线性降维

- 提取的特征保留了原始数据的主要信息

BP特征提取优势

与传统特征提取方法相比,BP神经网络具有以下优势:

- 非线性处理能力:能够捕捉数据中复杂的非线性关系

- 端到端学习:特征提取与分类/回归联合优化

- 自适应性强:针对不同任务自动调整特征提取策略

- 鲁棒性好:对噪声和缺失数据有一定容忍度

实验研究表明,在图像识别、语音处理等领域,BP神经网络提取的特征通常优于手工设计的特征。

实践方法与技巧

网络结构设计

隐藏层数:通常1-3层,过多易导致过拟合

节点数量:可通过交叉验证确定,一般遵循:

- 首隐藏层节点数 ≈ (输入维度+输出维度)/2

- 后续层节点数逐层减少

激活函数选择:

- 隐藏层:ReLU、Sigmoid、Tanh

- 输出层:根据任务选择(Softmax用于分类,Linear用于回归)

特征提取实现

提取隐藏层输出作为新特征的步骤:

# 伪代码示例

model = Sequential()

model.add(Dense(128, input_dim=input_dim, activation='relu')) # 特征提取层

model.add(Dense(num_classes, activation='softmax')) # 分类层

# 训练完整模型

model.compile(...)

model.fit(...)

# 创建特征提取模型

feature_extractor = Model(inputs=model.input,

outputs=model.layers[0].output)

# 提取特征

extracted_features = feature_extractor.predict(data)

参数调优建议

- 学习率:0.001-0.1,过大易震荡,过小收敛慢

- 批次大小:32-256,与数据规模相关

- 正则化:使用L2正则化或Dropout防止过拟合

- 归一化:输入数据标准化可加速收敛

应用案例分析

案例1:图像特征提取

在MNIST手写数字识别中:

- 将28×28图像展平为784维向量输入

- 设计单隐藏层(128节点)BP网络

- 提取隐藏层输出作为128维特征

- 新特征可应用于其他分类器或可视化

实验表明,这种特征在SVM等分类器上能达到95%+准确率。

案例2:文本情感分析

在影评情感分析中:

- 将文本转换为词频或TF-IDF向量

- 设计双隐藏层(256-128)BP网络

- 使用第二隐藏层输出作为文本特征

- 新特征维度远低于原始文本向量,但保留了情感信息

常见问题解答

Q:BP特征提取与PCA有何区别?

A:PCA是线性降维方法,BP可实现非线性降维;PCA保留方差最大方向,BP提取任务相关特征。

Q:如何确定最佳隐藏层节点数?

A:可通过网格搜索结合验证集性能确定,也可采用逐步增加节点法直至验证误差不再明显下降。

Q:提取的特征是否可解释?

A:BP提取的特征通常难以直接解释,但可通过可视化、敏感性分析等方法间接理解。

Q:小样本数据是否适用?

A:小样本时容易过拟合,建议减少网络规模或使用预训练网络进行迁移学习。

发展趋势

随着深度学习发展,BP神经网络在特征提取中的应用呈现新趋势:

- 与深度网络结合:作为深层网络的组成部分

- 自动结构搜索:利用NAS技术自动优化网络结构

- 注意力机制引入:增强重要特征的提取能力

- 多任务学习:提取可共享的通用特征表示

尽管新型网络结构不断涌现,BP神经网络因其简单有效,仍然是特征提取领域的基础工具,特别适合中小规模数据集和资源受限场景。

参考文献

- Rumelhart, D. E., Hinton, G. E., & Williams, R. J. (1986). Learning representations by back-propagating errors. Nature.

- Bishop, C. M. (1995). Neural networks for pattern recognition. Oxford university press.

- 周志华. (2016). 机器学习. 清华大学出版社.

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep learning. MIT press.