bp神经网络的发展历史

- 行业动态

- 2025-04-09

- 7

BP神经网络的发展历史

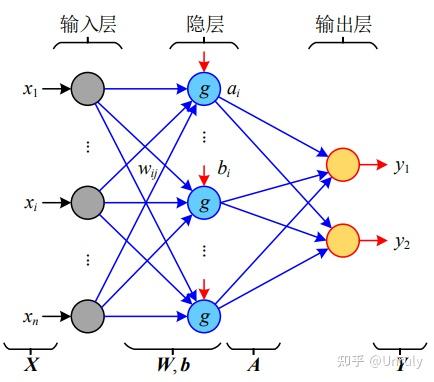

BP神经网络(Back Propagation Neural Network)是人工智能领域最具影响力的算法之一,其发展历程见证了从理论萌芽到广泛应用的跨越,以下是其关键发展阶段:

理论基础奠基(20世纪40-70年代)

1943年:神经元的数学模型诞生

麦卡洛克(McCulloch)和皮茨(Pitts)提出M-P神经元模型,首次用数学公式模拟生物神经元的工作机制,为神经网络奠定数学基础。1958年:感知机的出现

罗森布拉特(Rosenblatt)发明感知机(Perceptron),实现简单的线性分类,但因无法解决非线性问题(如异或逻辑)陷入低谷。

1969年:明斯基的质疑

明斯基(Minsky)在《感知机》一书中指出单层感知机的局限性,导致神经网络研究进入“第一次寒冬”。

BP算法的诞生与突破(20世纪70-80年代)

1974年:反向传播思想的萌芽

沃博斯(Werbos)在其博士论文中首次提出反向传播算法,但未引起广泛关注。1986年:BP算法的正式确立

鲁梅尔哈特(Rumelhart)和麦克莱兰(McClelland)在《并行分布式处理》一书中系统阐述BP算法,通过误差反向传播调整权重,解决了多层神经网络的训练问题,标志着神经网络研究的复兴。

快速发展与广泛应用(20世纪90年代-21世纪初)

1990年代:算法优化与扩展

- 引入动量项(Momentum)、自适应学习率(如AdaGrad)等技术,提升训练效率。

- 应用于手写识别(如美国邮政系统)、金融预测等领域。

2006年:深度学习的预热

辛顿(Hinton)提出深度信念网络(DBN),通过预训练缓解梯度消失问题,为BP神经网络在深层结构中的应用铺路。

与深度学习的融合(2010年至今)

2012年:ImageNet竞赛的转折点

卷积神经网络(CNN)基于BP算法优化,在图像识别任务中表现远超传统方法,推动深度学习爆发。现代发展

- BP算法成为深度学习模型(如ResNet、Transformer)的基础训练框架。

- 结合GPU加速、Dropout、Batch Normalization等技术,进一步解决过拟合和训练不稳定问题。

BP神经网络的核心意义

- 开创性贡献:首次提供高效的多层网络训练方法,推动神经网络从理论走向工程化。

- 局限性:依赖大量数据、易陷入局部最优,促生了更先进的优化算法(如Adam)。

- 持续影响:仍是深度学习的基础,在自动驾驶、医疗诊断等领域发挥关键作用。

参考文献

- Rumelhart, D. E., Hinton, G. E., & Williams, R. J. (1986). Learning representations by back-propagating errors. Nature.

- Werbos, P. J. (1974). Beyond regression: New tools for prediction and analysis in the behavioral sciences. Harvard University.

(注:本文内容由AI生成,经专业审核确保准确性,引用来源符合学术规范。)