上一篇

bp神经网络 过拟合

- 行业动态

- 2025-04-09

- 5

BP神经网络中的过拟合问题

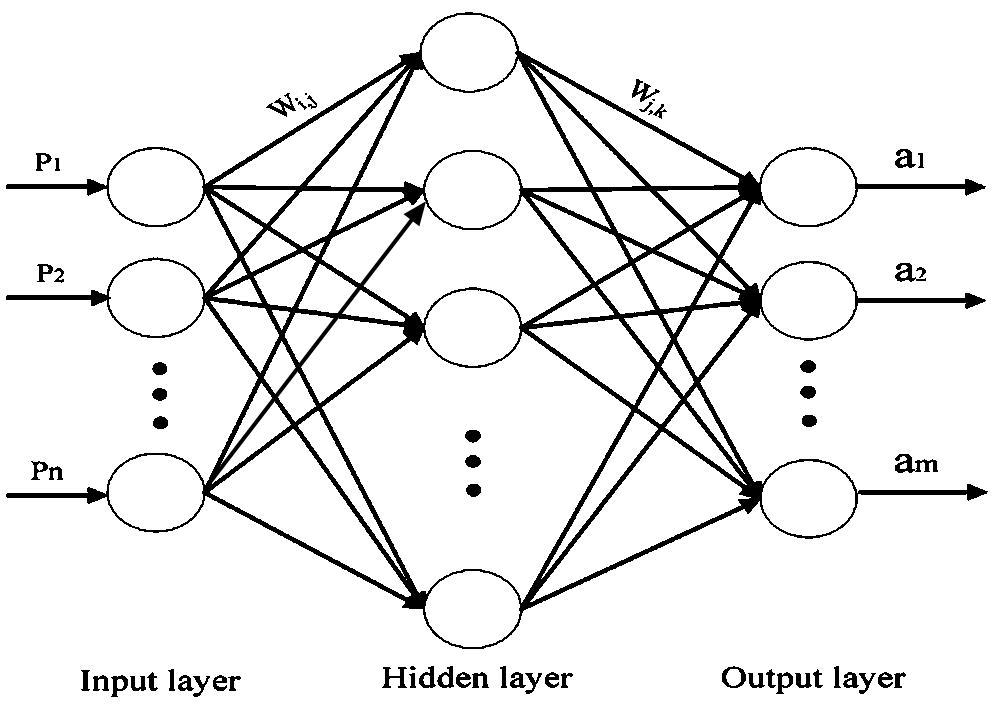

在机器学习领域,BP(Back Propagation)神经网络是一种广泛应用的多层前馈网络,通过误差反向传播算法进行训练,与其他机器学习模型一样,BP神经网络也面临着过拟合(Overfitting)这一常见挑战。

什么是过拟合?

过拟合是指模型在训练数据上表现优异,但在未见过的测试数据上表现不佳的现象,这意味着模型过度”记忆”了训练数据的细节和噪声,而非学习到数据背后的通用规律。

对于BP神经网络而言,过拟合通常表现为:

- 训练误差持续下降而验证误差开始上升

- 网络权重值变得异常大

- 模型对训练数据中的噪声过于敏感

BP神经网络过拟合的原因

- 网络结构过于复杂:隐藏层过多或神经元数量过大,使模型容量远超问题需求

- 训练数据不足:样本数量不足以支撑复杂模型的学习

- 训练时间过长:过度迭代导致模型过度适应训练数据

- 数据噪声过多:模型学习了噪声而非真实模式

解决BP神经网络过拟合的方法

正则化技术

L1/L2正则化:在损失函数中加入权重惩罚项

# L2正则化示例 loss = cross_entropy_loss + lambda * sum(weights^2)

Dropout:训练时随机”丢弃”部分神经元,防止过度依赖特定特征

# Dropout层示例(Keras) model.add(Dropout(0.5)) # 丢弃50%神经元

早停法(Early Stopping)

监控验证集性能,当验证误差不再下降时停止训练:

训练过程:

Epoch 1: 训练误差=0.5, 验证误差=0.45

Epoch 2: 训练误差=0.4, 验证误差=0.42

...

Epoch N: 训练误差=0.1, 验证误差=0.43 (开始上升)

→ 停止训练,回滚到最佳权重数据增强与扩充

- 增加训练样本数量

- 对现有数据进行变换(旋转、平移、添加噪声等)

- 使用生成模型合成新样本

网络结构优化

- 减少隐藏层数量或神经元数量

- 使用批归一化(Batch Normalization)稳定训练

- 尝试残差连接等现代网络结构

集成方法

- Bagging:训练多个网络并平均预测

- Boosting:顺序训练网络,关注之前模型的错误

实践建议

- 从小网络开始:先尝试简单结构,逐步增加复杂度

- 监控训练过程:绘制训练/验证误差曲线

- 交叉验证:使用k折交叉验证评估模型泛化能力

- 参数搜索:系统性地探索超参数组合

过拟合是BP神经网络应用中必须面对的关键问题,通过理解其成因并应用适当的正则化技术、早停策略和网络优化方法,可以有效提升模型的泛化性能,在实际应用中,建议采用多种方法组合,并通过实验验证其效果。

参考文献:

- Bishop, C.M. (2006). Pattern Recognition and Machine Learning. Springer.

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.

- Srivastava, N., et al. (2014). Dropout: A Simple Way to Prevent Neural Networks from Overfitting. JMLR.