bp神经网络 梯度消失

- 行业动态

- 2025-04-09

- 6

BP神经网络中的梯度消失问题

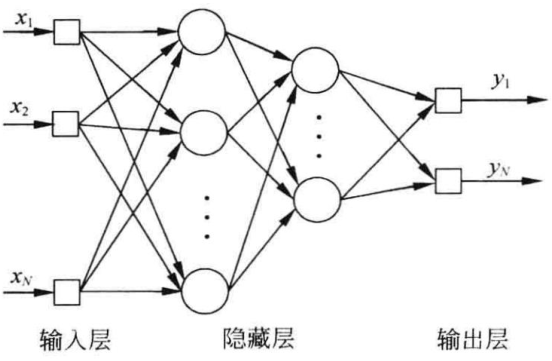

在深度学习领域,反向传播(BP)神经网络是最基础也是最重要的算法之一,随着网络层数的增加,BP神经网络常常会遇到一个棘手的问题——梯度消失(Vanishing Gradient),本文将深入探讨这一现象的原因、影响以及解决方案。

什么是梯度消失?

梯度消失是指在深度神经网络中,随着误差反向传播到更早的层时,梯度会呈指数级减小,导致网络权重更新变得极其缓慢甚至停止更新的现象,这种现象在深层网络中尤为明显,使得网络的深层部分难以得到有效的训练。

梯度消失的原因

激活函数的选择:传统的sigmoid和tanh激活函数的导数在大部分区域都非常小(小于1),当多个这样的导数相乘时,梯度会迅速趋近于零。

权重初始化不当:如果初始权重设置得过小,会导致每层的输出值范围缩小,进一步加剧梯度消失。

网络深度:网络层数越多,反向传播时需要相乘的导数项就越多,梯度消失的可能性越大。

梯度消失的影响

- 深层网络参数更新缓慢或停止更新

- 网络难以学习长期依赖关系

- 训练过程停滞不前,收敛速度极慢

- 网络性能下降,无法发挥深层结构的优势

解决方案

激活函数改进

使用ReLU(Rectified Linear Unit)及其变体(如Leaky ReLU、PReLU、ELU等)可以显著缓解梯度消失问题,因为它们的导数在正区间恒为1。

# ReLU激活函数示例

def relu(x):

return max(0, x)

权重初始化策略

采用Xavier初始化或He初始化等方法,根据激活函数的特性调整初始权重的分布范围。

# He初始化示例 weights = np.random.randn(n_input, n_output) * np.sqrt(2/n_input)

批量归一化(Batch Normalization)

在每层激活函数前加入批量归一化层,可以保持每层输入的分布稳定,减少内部协变量偏移。

残差连接(Residual Connection)

通过引入跳跃连接,使得梯度可以直接流向更早的层,避免了通过非线性变换导致的梯度衰减。

梯度裁剪(Gradient Clipping)

虽然主要用于解决梯度爆炸问题,但合理的梯度裁剪策略也能帮助训练过程更加稳定。

实践建议

- 对于深层网络,优先选择ReLU族激活函数

- 采用合适的权重初始化方法

- 考虑添加批量归一化层

- 对于极深层网络,使用残差结构

- 监控训练过程中各层的梯度变化

梯度消失问题是深度神经网络训练中的主要挑战之一,通过理解其成因并应用适当的解决方案,我们可以更有效地训练深层网络,充分发挥深度学习的潜力,随着研究的深入,新的技术如自注意力机制等也为解决这一问题提供了更多可能性。

参考文献:

- Hochreiter, S. (1991). Untersuchungen zu dynamischen neuronalen Netzen. Diploma thesis, Technische Universität München.

- Glorot, X., & Bengio, Y. (2010). Understanding the difficulty of training deep feedforward neural networks. AISTATS.

- He, K., et al. (2015). Delving deep into rectifiers: Surpassing human-level performance on imagenet classification. CVPR.