bp神经网络的学习率

- 行业动态

- 2025-04-09

- 8

BP神经网络的学习率

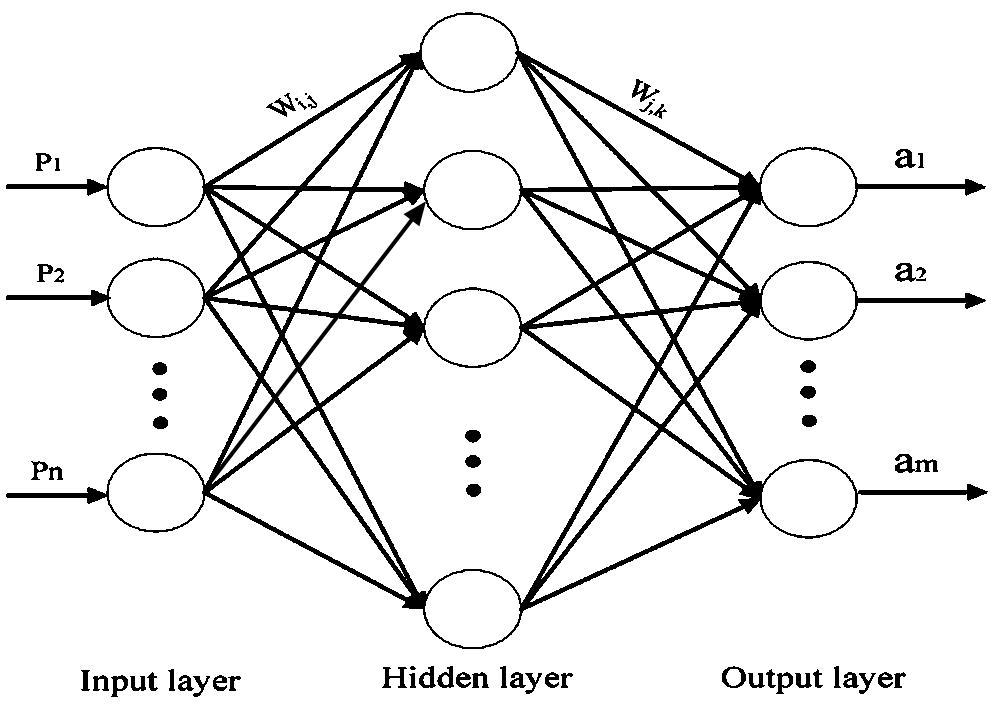

在深度学习领域,BP(反向传播)神经网络是最基础也是最重要的模型之一,学习率作为神经网络训练过程中的关键超参数,直接影响着模型的收敛速度和最终性能,本文将深入探讨BP神经网络中学习率的作用机制、选择策略以及常见问题。

学习率的基本概念

学习率(Learning Rate)是神经网络在反向传播过程中用于调整权重的步长大小,它决定了每次参数更新时,梯度下降算法沿着梯度方向移动的距离,数学表达式为:

θ = θ - η * ∇J(θ)- θ代表模型参数

- η代表学习率

- ∇J(θ)代表损失函数J关于θ的梯度

学习率的大小对训练过程有着决定性影响:

- 过大的学习率可能导致模型无法收敛,在最优解附近震荡甚至发散

- 过小的学习率会使训练过程非常缓慢,容易陷入局部最优

学习率的选择策略

固定学习率

最简单的学习率设置方式是使用一个固定值,常见范围为0.1到0.0001之间,选择固定学习率时需要考虑:

- 网络结构的复杂度

- 训练数据的规模和特征

- 优化器的选择

学习率衰减

随着训练的进行,逐渐减小学习率可以带来更好的收敛效果,常见的衰减策略包括:

- 时间衰减:η = η₀/(1+kt)

- 指数衰减:η = η₀ * e^(-kt)

- 阶梯衰减:每隔固定epoch将学习率乘以一个衰减因子

自适应学习率方法

现代优化算法通常采用自适应学习率机制:

- Momentum:引入动量项加速相关方向的梯度下降

- Adagrad:根据参数的历史梯度调整学习率

- RMSprop:改进Adagrad的激进衰减问题

- Adam:结合Momentum和RMSprop的优点

学习率调优实践

学习率测试

建议采用学习率范围测试(LR Range Test):

- 从一个极小值(如1e-7)开始

- 以指数方式增加学习率(如每batch乘以1.05)

- 记录损失变化,找到损失下降最快的区间

学习率预热

在训练初期使用较小的学习率,逐步增加到预设值,有助于:

- 避免初始梯度爆炸

- 使模型参数达到更稳定的区域

周期性学习率

采用周期性变化的学习率(如CLR)可以:

- 帮助跳出局部最优

- 加速模型收敛

- 减少调参工作量

常见问题与解决方案

损失值震荡

现象:损失函数值上下波动不收敛

原因:学习率过大

解决:减小学习率或使用学习率衰减

训练停滞

现象:损失值长时间不下降

原因:学习率过小或陷入局部最优

解决:适当增大学习率或尝试自适应方法

梯度爆炸

现象:模型参数变为NaN

原因:学习率过大导致梯度累积

解决:减小学习率、使用梯度裁剪或批归一化

学习率是BP神经网络训练中最为敏感的超参数之一,合理设置学习率不仅能加速模型收敛,还能提高最终性能,在实际应用中,建议:

- 先进行学习率范围测试确定合理区间

- 根据模型表现选择固定或自适应策略

- 配合其他优化技术如批归一化、权重初始化等

- 监控训练过程,及时调整学习率策略

随着深度学习框架的发展,许多优化器已经内置了智能的学习率调整机制,但理解其背后的原理仍然是调优模型的基础。

参考文献:

- Ruder, S. (2016). An overview of gradient descent optimization algorithms. arXiv preprint arXiv:1609.04747.

- Smith, L. N. (2017). Cyclical learning rates for training neural networks. 2017 IEEE Winter Conference on Applications of Computer Vision (WACV).

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep learning. MIT press.