上一篇

bp神经网络知识储存

- 行业动态

- 2025-04-08

- 3

BP神经网络知识储存

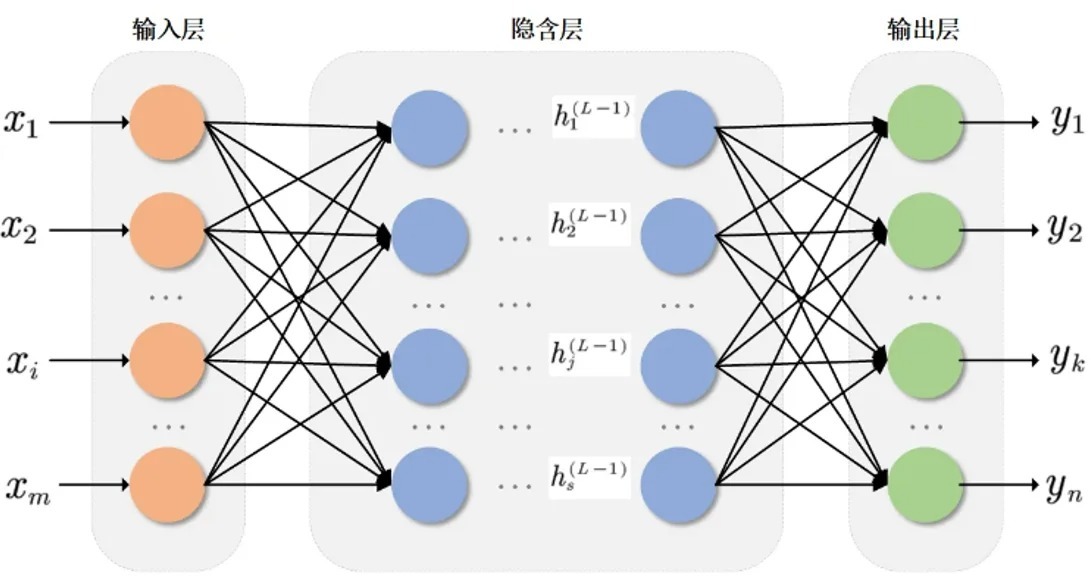

在人工智能和机器学习领域,BP(Back Propagation)神经网络是一种经典且广泛应用的多层前馈神经网络模型,它的核心优势在于通过误差反向传播算法(Back Propagation)实现高效的知识储存与学习,本文将深入解析BP神经网络的工作原理、知识储存机制及其实际应用,帮助读者理解其重要性。

BP神经网络的基本原理

BP神经网络由输入层、隐藏层和输出层组成,通过以下步骤实现知识储存与学习:

- 前向传播:输入数据从输入层逐层传递至输出层,每层神经元通过权重和激活函数计算输出值。

- 误差计算:输出层的实际值与期望值之间的误差通过损失函数(如均方误差)量化。

- 反向传播:误差从输出层反向传递至输入层,根据梯度下降法调整各层神经元的权重和偏置。

- 权重更新:通过优化算法(如随机梯度下降)迭代更新参数,逐步降低误差,完成知识储存。

知识储存的核心机制

BP神经网络的“知识”以权重和偏置的形式储存在网络中,其核心机制包括:

- 分布式储存:信息分散存储于大量神经元的连接权重中,而非单一节点,具备容错性和鲁棒性。

- 非线性映射:通过激活函数(如Sigmoid、ReLU)实现复杂非线性关系的拟合,增强表达能力。

- 泛化能力:通过训练数据学习规律后,可对未知数据做出合理预测,体现知识的迁移性。

BP神经网络的应用场景

BP神经网络的知识储存特性使其在以下领域表现卓越:

- 图像识别:如手写数字分类(MNIST数据集)。

- 自然语言处理:文本分类、情感分析。

- 金融预测:股票价格趋势预测、风险评估。

- 工业控制:故障诊断、参数优化。

优化知识储存的关键技术

为提高BP神经网络的效率和稳定性,常采用以下方法:

- 正则化:L1/L2正则化防止过拟合。

- 批归一化(Batch Normalization):加速训练过程。

- 自适应学习率:如Adam优化器动态调整学习率。

- Dropout:随机丢弃部分神经元,增强泛化能力。

BP神经网络的局限性

尽管BP神经网络功能强大,但仍存在以下问题:

- 梯度消失/爆炸:深层网络中梯度可能过小或过大,导致训练困难。

- 局部最优解:目标函数可能存在多个极小值,影响模型性能。

- 数据依赖:需大量标注数据,且对噪声敏感。

BP神经网络通过误差反向传播实现了高效的知识储存与学习,成为深度学习的基础模型之一,理解其原理和优化方法,有助于在实际项目中合理应用并解决复杂问题,结合新型网络结构(如ResNet、Transformer)和训练技术,BP神经网络的潜力将进一步释放。

引用说明:

本文参考了《神经网络与深度学习》(Michael Nielsen)、Stanford CS231n课程资料及Google AI技术博客。