bp 神经网络模型 epoch 4 iterations

- 行业动态

- 2025-04-08

- 3

BP神经网络模型:Epoch与Iterations的关系解析

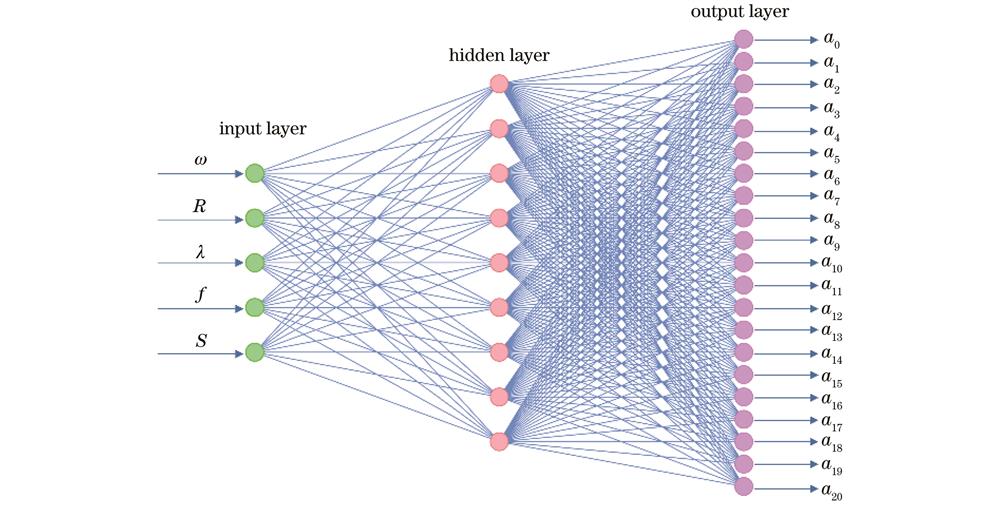

在深度学习领域,理解训练过程中的关键概念对于优化模型性能至关重要,本文将深入探讨BP神经网络中Epoch和Iterations这两个基本但容易混淆的概念,特别关注当Epoch设置为4时的训练行为。

基本概念解析

Epoch(周期):一个Epoch表示整个训练数据集完整通过神经网络一次(前向传播+反向传播)的过程,当Epoch=4时,意味着训练数据将被完整使用4次。

Iteration(迭代):一次Iteration是指完成一个batch的前向传播和反向传播,Iteration数量取决于batch size和数据集大小。

Epoch=4时的训练特性

当设置Epoch为4时,模型训练呈现以下特点:

训练时间缩短:相比默认的50-100个Epoch,4个Epoch显著减少训练时间,适合快速验证模型架构或进行初步测试。

欠拟合风险:对于复杂数据集,4个Epoch可能不足以让模型充分学习特征,导致欠拟合。

大数据集场景优势:当数据集极大时(如百万级样本),4个Epoch可能已经足够,因为每个样本已被多次使用(考虑batch size)。

Epoch与Iterations的数学关系

两者关系可通过公式表示:

总Iterations = Epoch数 × (训练集样本数 / batch size)举例说明:

- 训练集样本:10,000

- batch size:100

- Epoch=4

则:

总Iterations = 4 × (10,000/100) = 400次

实际应用建议

监控指标:即使Epoch=4,也应监控训练/验证损失和准确率曲线。

学习率调整:少量Epoch时,可考虑增大初始学习率加速收敛。

早停机制:当验证集性能不再提升时提前终止,即使未达到4个Epoch。

batch size影响:大batch size减少Iterations但可能影响泛化能力。

常见问题解答

Q:为什么我的模型在4个Epoch后性能仍然很差?

A:可能原因包括:学习率设置不当、模型容量不足、数据预处理问题或确实需要更多Epoch。

Q:Epoch=4时如何选择batch size?

A:建议从32或64开始,根据GPU内存调整,较小的batch size通常需要更多Iterations。

Q:所有数据集都适合4个Epoch吗?

A:不是,简单任务和小数据集可能足够,但复杂任务通常需要更多Epoch。

进阶技巧

热启动训练:先用4个Epoch快速验证,再决定是否继续训练。

周期性学习率:如Cosine退火,可在少量Epoch内实现更好的收敛。

混合精度训练:减少每个Iteration时间,在相同Epoch下完成更多优化步骤。

理解Epoch和Iterations的关系有助于更高效地设计训练流程,Epoch=4的设置虽然不常见,但在特定场景下(如超参数快速搜索、大规模预训练模型微调)具有实用价值,实际应用中应根据验证集表现灵活调整训练周期数。

参考文献:

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.

- Smith, L. N. (2017). Cyclical Learning Rates for Training Neural Networks. IEEE Winter Conference on Applications of Computer Vision.

- Masters, D., & Luschi, C. (2018). Revisiting Small Batch Training for Deep Neural Networks. arXiv preprint arXiv:1804.07612.