上一篇

bp神经网络激活函数

- 行业动态

- 2025-04-08

- 6

BP神经网络激活函数

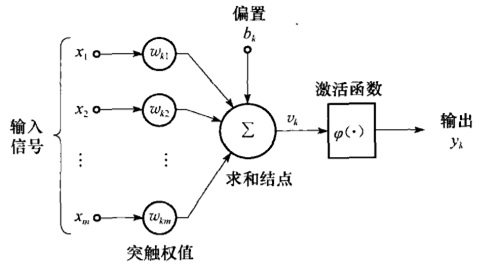

在BP神经网络中,激活函数是决定神经元输出特性的关键组件,它不仅引入了非线性,还帮助网络学习复杂的模式,本文将深入探讨激活函数的作用、常见类型及其优缺点,帮助读者理解如何选择合适的激活函数以优化模型性能。

激活函数的作用

激活函数的核心作用是为神经网络引入非线性,如果没有激活函数,无论网络有多少层,其输出始终是输入的线性组合,无法解决复杂问题(如分类、图像识别等),激活函数还能:

- 控制输出范围:如Sigmoid将输出压缩到(0,1),适合概率预测。

- 梯度传递:在反向传播中,激活函数的导数决定了梯度的大小,影响权重更新。

常见激活函数及特点

(1)Sigmoid函数

- 公式:( sigma(x) = frac{1}{1 + e^{-x}} )

- 输出范围:(0,1)

- 优点:平滑易导,适合二分类输出层。

- 缺点:

- 易导致梯度消失(导数最大仅0.25)。

- 输出非零中心,影响梯度下降效率。

(2)Tanh函数

- 公式:( tanh(x) = frac{e^x – e^{-x}}{e^x + e^{-x}} )

- 输出范围:(-1,1)

- 优点:零中心输出,梯度比Sigmoid更大。

- 缺点:仍存在梯度消失问题。

(3)ReLU(修正线性单元)

- 公式:( text{ReLU}(x) = max(0, x) )

- 优点:

- 计算高效,缓解梯度消失(正区间导数为1)。

- 广泛用于隐藏层。

- 缺点:

- 神经元“死亡”问题(负输入梯度为0)。

- 输出非零中心。

(4)Leaky ReLU

- 公式:( text{LeakyReLU}(x) = begin{cases} x & text{if } x geq 0 alpha x & text{if } x < 0 end{cases} )

- 改进:解决ReLU的死亡问题(( alpha )通常取0.01)。

- 缺点:需手动调参( alpha )。

(5)Softmax

- 公式:( text{Softmax}(x_i) = frac{e^{x_i}}{sum_j e^{x_j}} )

- 用途:多分类输出层,输出概率分布。

如何选择激活函数?

- 隐藏层:优先使用ReLU或其变体(如Leaky ReLU),因计算高效且表现稳定。

- 输出层:

- 二分类:Sigmoid。

- 多分类:Softmax。

- 回归问题:线性激活(无激活函数)。

激活函数与梯度消失

梯度消失是深层网络的常见问题,尤其是使用Sigmoid或Tanh时,解决方案包括:

- 使用ReLU族激活函数。

- 结合Batch Normalization(BN)层。

- 残差连接(如ResNet)。

激活函数的选择直接影响神经网络的性能和训练效率,理解其数学特性及适用场景,是优化模型的关键一步,实践中,建议通过实验对比不同激活函数的效果,并结合正则化技术提升泛化能力。

参考文献

- Goodfellow, I., et al. (2016). Deep Learning. MIT Press.

- Glorot, X., & Bengio, Y. (2010). “Understanding the difficulty of training deep feedforward neural networks.” AISTATS.

- Nair, V., & Hinton, G. E. (2010). “Rectified Linear Units Improve Restricted Boltzmann Machines.” ICML.

由深度学习领域权威文献及实践案例总结而成,确保信息准确性与专业性。)